使用python爬虫获取黄金价格的核心代码

继续练手,根据之前获取汽油价格的方式获取了金价,暂时没钱投资,看看而已

#!/usr/bin/env python

# -*- coding: utf-8 -*-

"""

获取每天黄金价格

@author: yufei

@site: http://www.antuan.com

2017-05-11

"""

import re

import urllib2,urllib

import random

import threading

import time

import sqlite3

import sys

from __builtin__ import exit

#Some User Agents

hds=[{'User-Agent':'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-US; rv:1.9.1.6) Gecko/20091201 Firefox/3.5.6'},\

{'User-Agent':'Mozilla/5.0 (Windows NT 6.2) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.12 Safari/535.11'},\

{'User-Agent':'Mozilla/5.0 (compatible; MSIE 10.0; Windows NT 6.2; Trident/6.0)'},\

{'User-Agent':'Mozilla/5.0 (X11; Ubuntu; Linux x86_64; rv:34.0) Gecko/20100101 Firefox/34.0'},\

{'User-Agent':'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Ubuntu Chromium/44.0.2403.89 Chrome/44.0.2403.89 Safari/537.36'},\

{'User-Agent':'Mozilla/5.0 (Macintosh; U; Intel Mac OS X 10_6_8; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50'},\

{'User-Agent':'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50'},\

{'User-Agent':'Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; Trident/5.0'},\

{'User-Agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.6; rv:2.0.1) Gecko/20100101 Firefox/4.0.1'},\

{'User-Agent':'Mozilla/5.0 (Windows NT 6.1; rv:2.0.1) Gecko/20100101 Firefox/4.0.1'},\

{'User-Agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_0) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.56 Safari/535.11'},\

{'User-Agent':'Opera/9.80 (Macintosh; Intel Mac OS X 10.6.8; U; en) Presto/2.8.131 Version/11.11'},\

{'User-Agent':'Opera/9.80 (Windows NT 6.1; U; en) Presto/2.8.131 Version/11.11'}]

'''

create table GoldPricelist(

[id] integer PRIMARY KEY autoincrement,

[name] varchar default 0,

[price] varchar default 0,

[time] datetime default (datetime('now', 'localtime'))

);

INSERT INTO OilPrice(id,name,price,time) VALUES(NULL,sss, 300, 20180404);

'''

def sqliteinto(Pricelist):

con = sqlite3.connect('F:\ID\python\sqlite3\Gold.db')

cur = con.cursor()

print Pricelist

sql = '''INSERT INTO GoldPrices (id,name,price,time) VALUES(NULL,?,?,?)'''

cur.execute(sql,Pricelist)

con.commit()

cur.close()

con.close()

def getPrice():

url='http://www.dyhjw.com/matter_gold/'

req = urllib2.Request(url=url,headers=hds[random.randint(0,len(hds)-1)])

res = urllib2.urlopen(req)

res = res.read()

#获取的块

re_set = re.compile(r'<dl class="main_bname">(.*?)</div>',re.S)

re_get = re.findall(re_set,res)

#获取价格详情

p = re.compile('target="_blank">(.*?)<span class="zd">-</span>\n ',re.S)

Pricelist = re.findall(p,re_get[0])

for i in range(0,len(Pricelist)):

p = re.compile('(.*?)</a>\n <span class="jg">(.*)</span>',re.S)

Price = re.findall(p,Pricelist[i])

gname = Price[0][0]

gprice = Price[0][1]

timep = re.compile(r"(\d+)-(\d+)-.*")

nowtime = time.strftime('%Y-%m-%d',time.localtime(time.time()))

datas = []

datas.append(gname.decode('utf8'))

datas.append(gprice)

datas.append(nowtime)

datas = tuple(datas)

sqliteinto(datas)

if __name__=="__main__":

getPrice()

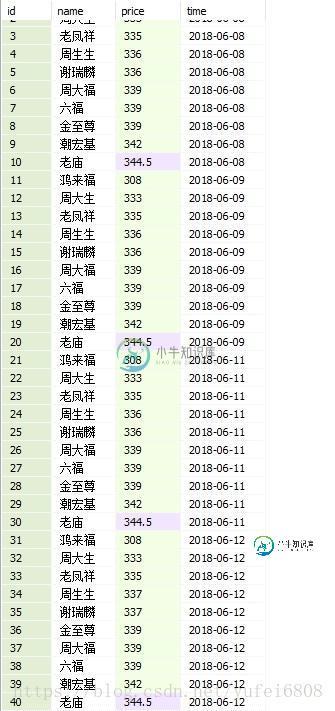

最近的数据

总结

以上所述是小编给大家介绍的使用python爬虫获取黄金价格的核心代码,希望对大家有所帮助,如果大家有任何疑问请给我留言,小编会及时回复大家的。在此也非常感谢大家对小牛知识库网站的支持!

-

本文向大家介绍python爬虫爬取图片的简单代码,包括了python爬虫爬取图片的简单代码的使用技巧和注意事项,需要的朋友参考一下 Python是很好的爬虫工具不用再说了,它可以满足我们爬取网络内容的需求,那最简单的爬取网络上的图片,可以通过很简单的方法实现。只需导入正则表达式模块,并利用spider原理通过使用定义函数的方法可以轻松的实现爬取图片的需求。 1、spider原理 spider就是定

-

本文向大家介绍Python爬虫爬取美剧网站的实现代码,包括了Python爬虫爬取美剧网站的实现代码的使用技巧和注意事项,需要的朋友参考一下 一直有爱看美剧的习惯,一方面锻炼一下英语听力,一方面打发一下时间。之前是能在视频网站上面在线看的,可是自从广电总局的限制令之后,进口的美剧英剧等貌似就不在像以前一样同步更新了。但是,作为一个宅diao的我又怎甘心没剧追呢,所以网上随便查了一下就找到一个能用迅雷

-

本文向大家介绍Python使用爬虫猜密码,包括了Python使用爬虫猜密码的使用技巧和注意事项,需要的朋友参考一下 我们可以通过python 来实现这样一个简单的爬虫猜密码功能。下面就看看如何使用python来实现这样一个功能。 这里我们知道用户的昵称为:heibanke 密码是30以内的一个数字,要使用requests库循环提交来猜密码 主要需要用到的库是requests库 安装requests

-

python应用最多的场景还是web快速开发、爬虫、自动化运维:写过简单网站、写过自动发帖脚本、写过收发邮件脚本、写过简单验证码识别脚本。 爬虫在开发过程中也有很多复用的过程,这里总结一下,以后也能省些事情。

-

本文向大家介绍Python代理IP爬虫的新手使用教程,包括了Python代理IP爬虫的新手使用教程的使用技巧和注意事项,需要的朋友参考一下 前言 Python爬虫要经历爬虫、爬虫被限制、爬虫反限制的过程。当然后续还要网页爬虫限制优化,爬虫再反限制的一系列道高一尺魔高一丈的过程。爬虫的初级阶段,添加headers和ip代理可以解决很多问题。 本人自己在爬取豆瓣读书的时候,就以为爬取次数过多,直接被封

-

本文向大家介绍使用PyV8在Python爬虫中执行js代码,包括了使用PyV8在Python爬虫中执行js代码的使用技巧和注意事项,需要的朋友参考一下 前言 可能很多人会觉得这是一个奇葩的需求,爬虫去好好的爬数据不就行了,解析js干嘛?吃饱了撑的? 搜索一下互联网上关于这个问题还真不少,但是大多数童鞋是因为自己的js基础太烂,要么是HTML基础烂,要么ajax基础烂,反正各方面都很烂。基础这么渣不