网络爬虫 - 如何解决爬虫切片时只能获取单个数据项的问题?

我看做过切片所爬取的还是很全的

共有2个答案

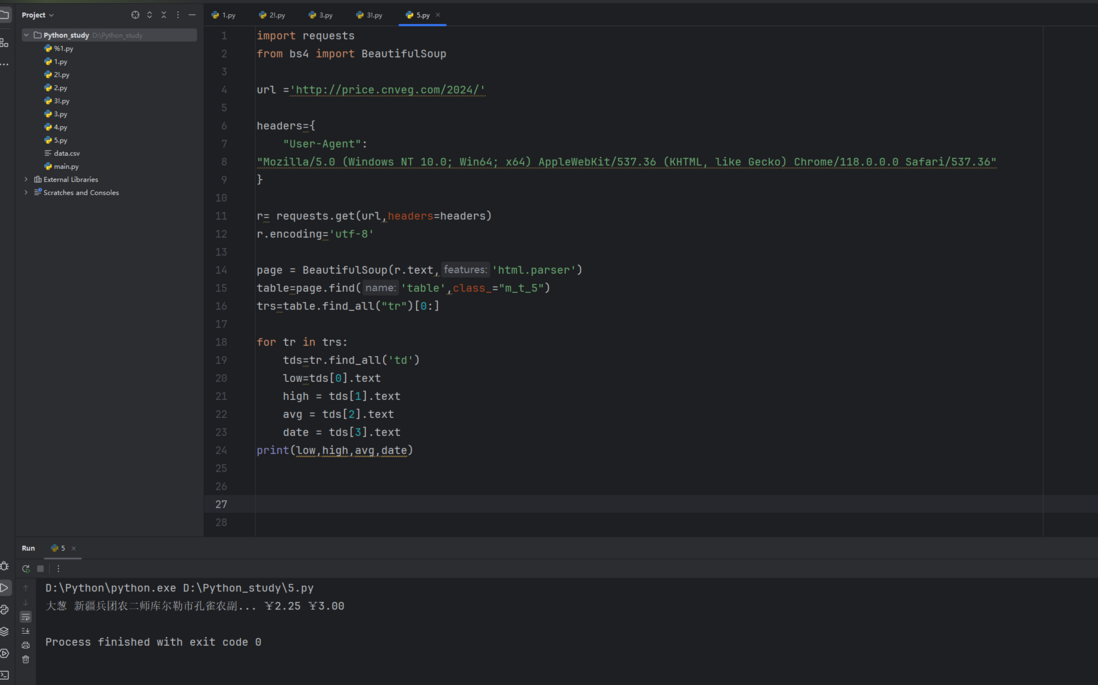

回答:python对空格和对齐严格要求,你的print函数放到外面去了,for循环里面根本就没输出内容,你可以调试一下看看,你的代码写的没啥问题,把print移到里面就行了

在解决爬虫切片时只能获取单个数据项的问题时,首先需要确定问题的具体来源。以下是一些可能的解决方案和检查点:

- 检查选择器:确保你的选择器(如XPath, CSS选择器)正确无误,并且能选中所有你想要的数据项。

- 检查切片逻辑:如果你使用了某种形式的切片(如Python中的

range()函数或列表切片),确保你的切片逻辑覆盖了所有你想要的数据项。 - 检查循环:如果你在使用循环来迭代数据项,确保循环的逻辑是正确的,并且循环的次数足够多,可以处理所有找到的数据项。

- 检查是否有限制:有些网站可能会限制爬虫的行为,如限制请求频率、限制IP地址等。如果可能,查看你的爬虫是否触发了这些限制。

- 检查响应内容:在调试时,打印出你收到的HTML响应内容,检查它是否包含了所有你想要的数据项。

- 使用调试工具:使用浏览器的开发者工具(如Chrome的开发者工具)来查看网页的DOM结构,这可以帮助你验证你的选择器是否正确。

- 检查异步加载:有些网站可能使用异步加载技术(如AJAX)来动态加载内容。如果你的爬虫只获取了初始的HTML内容,而没有等待异步加载的内容,那么你可能只会获取到部分数据。在这种情况下,你可能需要使用Selenium或其他工具来模拟浏览器行为,并等待内容加载完成。

- 查看错误和警告:在编写和运行爬虫时,注意查看任何可能的错误和警告信息。这些信息可能会提供关于问题的线索。

- 更新依赖库:如果你使用的是像

requests、lxml、BeautifulSoup等第三方库,确保这些库是最新版本的。有时,旧版本的库可能存在已知的问题或限制。 - 简化问题:如果你无法直接解决问题,尝试简化你的爬虫,只处理一个或少数几个数据项。一旦你能够成功地获取这些数据项,再逐步增加复杂性。

下面是一个使用Python和requests、lxml库进行网页爬取的简单示例,它使用XPath选择器来选取多个数据项:

import requests

from lxml import html

url = 'http://example.com' # 替换为你要爬取的网页URL

response = requests.get(url)

tree = html.fromstring(response.content)

# 假设你想要选取所有class为'item'的div元素中的文本内容

items = tree.xpath('//div[@class="item"]/text()')

# 打印所有选取的数据项

for item in items:

print(item.strip()) # 使用strip()去除可能的前导/尾随空白字符请注意,这只是一个示例,你需要根据你的具体情况调整选择器和其他代码。

-

问题内容: 如何过滤来自网络抓取工具等的点击。不是人类的点击。 我使用maxmind.com从IP请求城市。.如果我必须支付所有点击数(包括网络抓取工具,机器人等)的话,这并不便宜。 问题答案: 有两种检测机器人的一般方法,我将它们称为“礼貌/被动”和“激进”。基本上,您必须使您的网站出现心理障碍。 有礼貌 这些是礼貌地告诉抓取工具他们不应该抓取您的网站并限制抓取频率的方法。可以通过robots.

-

本文向大家介绍python爬虫爬取网页数据并解析数据,包括了python爬虫爬取网页数据并解析数据的使用技巧和注意事项,需要的朋友参考一下 1.网络爬虫的基本概念 网络爬虫(又称网络蜘蛛,机器人),就是模拟客户端发送网络请求,接收请求响应,一种按照一定的规则,自动地抓取互联网信息的程序。 只要浏览器能够做的事情,原则上,爬虫都能够做到。 2.网络爬虫的功能 网络爬虫可以代替手工做很多事情,比如可以

-

爬虫项是什么呢?比如采集文章列表、文章详情页,他们都是不同的采集项。 定义示例: 继承Yurun\Crawler\Module\Crawler\Contract\BaseCrawlerItem类。 <?php namespace Yurun\CrawlerApp\Module\YurunBlog\Article; use Imi\Bean\Annotation\Bean; use Yurun\C

-

本文向大家介绍python爬虫爬取图片的简单代码,包括了python爬虫爬取图片的简单代码的使用技巧和注意事项,需要的朋友参考一下 Python是很好的爬虫工具不用再说了,它可以满足我们爬取网络内容的需求,那最简单的爬取网络上的图片,可以通过很简单的方法实现。只需导入正则表达式模块,并利用spider原理通过使用定义函数的方法可以轻松的实现爬取图片的需求。 1、spider原理 spider就是定

-

主要内容:认识爬虫,爬虫分类,爬虫应用,爬虫是一把双刃剑,为什么用Python做爬虫,编写爬虫的流程网络爬虫又称网络蜘蛛、网络机器人,它是一种按照一定的规则自动浏览、检索网页信息的程序或者脚本。网络爬虫能够自动请求网页,并将所需要的数据抓取下来。通过对抓取的数据进行处理,从而提取出有价值的信息。 认识爬虫 我们所熟悉的一系列搜索引擎都是大型的网络爬虫,比如百度、搜狗、360浏览器、谷歌搜索等等。每个搜索引擎都拥有自己的爬虫程序,比如 360 浏览器的爬虫称作 360Spider,搜狗的爬虫叫做

-

案例:爬取百度新闻首页的新闻标题信息 url地址:http://news.baidu.com/ 具体实现步骤: 导入urlib库和re正则 使用urllib.request.Request()创建request请求对象 使用urllib.request.urlopen执行信息爬取,并返回Response对象 使用read()读取信息,使用decode()执行解码 使用re正则解析结果 遍历输出结果