关于多元线性回归分析——Python&SPSS

原始数据在这里

1.观察数据

首先,用Pandas打开数据,并进行观察。

import numpy

import pandas as pd

import matplotlib.pyplot as plt

%matplotlib inline

data = pd.read_csv('Folds5x2_pp.csv')

data.head()

会看到数据如下所示:

这份数据代表了一个循环发电厂,每个数据有5列,分别是:AT(温度), V(压力), AP(湿度), RH(压强), PE(输出电力)。我们不用纠结于每项具体的意思。

我们的问题是得到一个线性的关系,对应PE是样本输出,而AT/V/AP/RH这4个是样本特征, 机器学习的目的就是得到一个线性回归模型,即: PE=θ0+θ1∗AT+θ2∗V+θ3∗AP+θ4∗RH 而需要学习的,就是θ0,θ1,θ2,θ3,θ4这5个参数。

接下来对数据进行归一化处理:

data = (data - data.mean())/data.std()

因为回归线的截距θ0是不受样本特征影响的,因此我们在此可以设立一个X0=1,使得回归模型为:

PE=θ0*X0+θ1∗AT+θ2∗V+θ3∗AP+θ4∗RH

将方程向量化可得:

PE = hθ(x) = θx (θ应转置)

2.线性回归

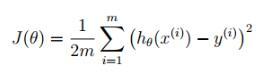

在线性回归中,首先应建立 cost function,当 cost function 的值最小时所取得θ值为所求的θ。

在线性回归中,Cost function如下所示:

因此,可以在Python中建立函数求损失方程:

def CostFunction(X,y,theta): inner = np.power((X*theta.T)-y,2) return np.sum(inner)/(2*len(X))

然后,设初始θ为=[0,0,0,0,0],可得到最初的J(θ)值为0.49994774247491858,代码如下所示

col = data.shape[1] X = data.iloc[:,0:col-1] y = data.iloc[:,col-1:col] X = np.matrix(X.values) y = np.matrix(y.values) theta = np.matrix(np.array([0,0,0,0,0])) temp = np.matrix(np.zeros(theta.shape)) CostFunction(X,y,theta)

接下来,有两种方法可以使用。1.梯度下降法(gradient descent)和 2.最小二乘法(normal equation)。在此我们使用梯度下降法来求解。

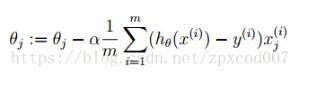

梯度下降法是求得J对θ的偏导数,通过设置步长,迭代使J(θ)逐步下降,从而求得局部最优解。

公式如下所示:

j:特征编号

m:样本编号

我们可以在Python中写出计算迭代后的θ和J(θ)

def gradientDescent(X,y,theta,alpha,iters):

temp = np.matrix(np.zeros(theta.shape))

parameters = int(theta.ravel().shape[1])

cost = np.zeros(iters)

for i in range(iters):

error = (X*theta.T)-y

for j in range(parameters):

term = np.multiply(error,X[:,j])

temp[0,j] = theta[0,j] - (alpha/len(X))*np.sum(term)

theta = temp

cost[i] = CostFunction(X,y,theta)

return theta,cost

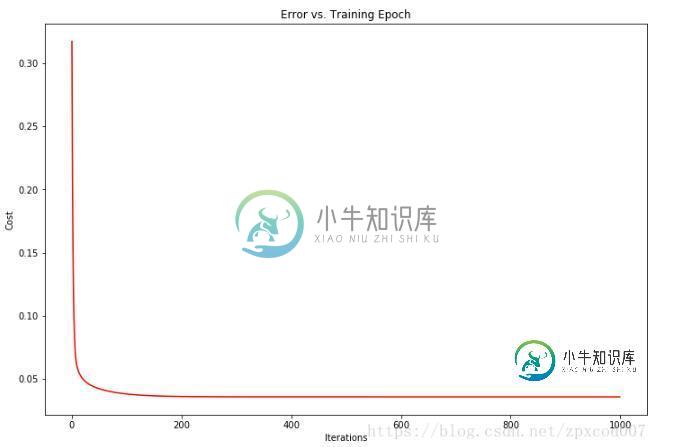

在此,我设置初始的α为0.1,可求得迭代1000次后θ0,θ1,θ2,θ3,θ4的值分别是:

-5.22080706e-14,-8.63485491e-01,-1.74182863e-01,2.16058120e-02,-1.35205248e-01

此时 J(θ)的值为0.0379648。

通过,可视化J(θ)和迭代次数可以发现,J(θ)收敛的非常快。

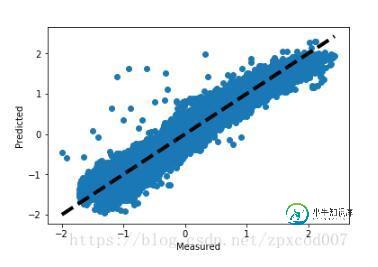

画图观察预测值和损失值,距离直线约近说明损失越小:

predicted = X*g.T predicted = predicted.flatten().A[0] y_f= y.flatten().A[0] fig, ax = plt.subplots() ax.scatter(y_f,predicted) ax.plot([y.min(), y.max()], [y.min(), y.max()], 'k--', lw=4) ax.set_xlabel('Measured') ax.set_ylabel('Predicted') plt.show()

3.sckit-learn

因为J(θ)收敛的太快了…所以我又用sckit-learn和SPSS验证了一下。

先看sckit-learn,在sklearn中,线性回归是使用的最小二乘法而不是梯度下降法,用起来也十分的简单。

代码如下:

from sklearn import linear_model model = linear_model.LinearRegression() model.fit(X, y)

打印出θ值后发现和梯度下降法算出来的相差无几,θ0,θ1,θ2,θ3,θ4的值分别是:

0,-0.86350078,-0.17417154,0.02160293,-0.13521023

4.SPSS

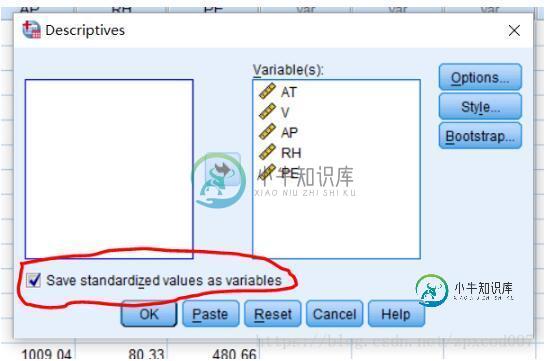

在看看SPSS

同样先将数据标准化后进行线

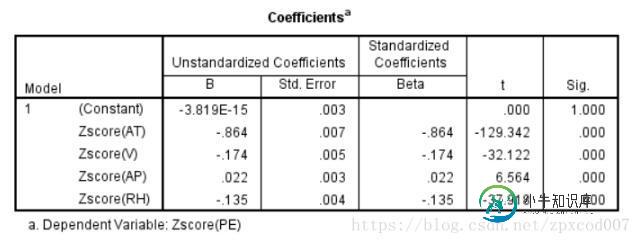

然后进行线性回归分析得到结果:

嘛…和前面两种方法的结果也差不多…就这样吧。

以上这篇关于多元线性回归分析——Python&SPSS就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持小牛知识库。

-

我想用python计算多元线性回归。我找到了这个简单线性回归的代码 a是系数,但我不明白是什么意思? 如何更改代码以获得多重线性回归?

-

本文向大家介绍Python线性回归实战分析,包括了Python线性回归实战分析的使用技巧和注意事项,需要的朋友参考一下 一、线性回归的理论 1)线性回归的基本概念 线性回归是一种有监督的学习算法,它介绍的自变量的和因变量的之间的线性的相关关系,分为一元线性回归和多元的线性回归。一元线性回归是一个自变量和一个因变量间的回归,可以看成是多远线性回归的特例。线性回归可以用来预测和分类,从回归方程可以看出

-

我在做多元回归问题。我有如下数据集。 我把工资作为因变量,其他变量作为自变量。在做了数据预处理之后,我运行了梯度下降、回归模型。我估计了所有独立特征的偏差(截距)和系数。我想做实际值的散点图和我预测的假设的回归线。因为我们这里有不止一个功能, 我有以下问题。 > 在绘制回归线时,特征值是多少,这样我就可以计算假设值。?意思是现在,我有截距和所有特征的权重,但是我没有特征值。我现在如何决定特征值?

-

我试图训练一个非常简单的线性回归模型。 我的代码是: 我得到以下错误: 我的输入有什么问题?我试过用几种方法改变的结构,但都没有效果。

-

本文向大家介绍scikit-learn线性回归,多元回归,多项式回归的实现,包括了scikit-learn线性回归,多元回归,多项式回归的实现的使用技巧和注意事项,需要的朋友参考一下 匹萨的直径与价格的数据 训练模型 预测一张12英寸匹萨价格:$13.68 一元线性回归假设解释变量和响应变量之间存在线性关系;这个线性模型所构成的空间是一个超平面(hyperplane)。 超平面是n维欧氏空间中余维

-

本文向大家介绍python实现机器学习之多元线性回归,包括了python实现机器学习之多元线性回归的使用技巧和注意事项,需要的朋友参考一下 总体思路与一元线性回归思想一样,现在将数据以矩阵形式进行运算,更加方便。 一元线性回归实现代码 下面是多元线性回归用Python实现的代码: 特别需要注意的是要弄清:矩阵的形状 在梯度下降的时候,计算两个偏导值,这里面的矩阵形状变化需要注意。 梯度下降数学式子