《同花顺》专题

-

Cosmos Changefeed火花流随机停止

我有一个 Spark 流式处理作业,它读取 Cosmos 更改源数据,如下所示,在具有 DBR 8.2 的数据砖集群中运行。 虽然作业正常工作,但偶尔,流会突然停止,并且在log4j输出中出现以下循环。重新启动作业将处理“待办事项”中的所有数据。以前有人经历过这样的事情吗?我不确定是什么原因造成的。有什么想法吗?

-

火花指数移动平均线

我也看过Pyspark中的加权移动平均线,但我需要一个Spark/Scala的方法,以及10天或30天的均线。 有什么想法吗?

-

更好的蜂巢-火花连接?

我正在回顾一个旧的Spark软件,它必须并行运行许多小的查询和计数()并使用直接的hive-sql。 在过去,该软件通过在shell()上直线运行每个查询来解决“并行化查询的问题”。我不能用现代新鲜的Spark,此刻只有Spark V2.2。下面的片段说明了完整的SQL查询方法。 有一种“Spark方式”可以访问Hive并运行SQL查询,性能(略)更好,而且Spark配置的重用性更好? 没有丢失纯

-

莲花多米诺骨牌脚本

我最近编写了一个Windows服务,它使用Exchange Web服务来监听一个特定的邮箱,然后当该邮箱收到新消息时,应用程序会向一组完全不同的用户发送一封电子邮件。我通过订阅服务做到了这一点,这样in就可以持续运行。 我想重新创建这个应用程序,除了将它与Lotus Domino/Notes集成。我做了一些研究,并且知道Lotus C API(可能)以及Lotus Domino Designer(

-

时间戳无法识别雪花

我在雪花中有一个字符串值如下;

-

10.12花旗金融面试记录

10.12花旗金融面试记录部门:个人银行部 岗位:面试官说的只有应用开发岗,然后我是数分,尴尬 面试过程: 一位leader+2位同事。 英语部分—— 英语自我介绍、爱好、职业方向。 我说我想找数分的,然后他就英语问我他们部门只有开发的,跟我的职业方向不匹配,我能不能接受。 笔试题拷打—— 紧接着,他打开了我的笔试题。。。 首先问我错的题目为什么选错了,然后让我描述一下我的编程题的思路,逻辑,时间复杂度,以及代码内部的一些

-

火花数仓实习生笔试

火花数仓实习生笔试1、返回每个部门工资排名前二的员工() A、使用ROW NUMBER()函数并通过子查询过滤 B、使用RANK()函数并通过子查询过滤RANK <2 C、使用DENSE RANK()函数并通过子查询过滤RANK <=2 D、使用NTILE(2)函数 2、SQL排序时希望特定某个值排在最后(如null、Unknow等) A、ORDER BY column name ASC B、ORDER BY co

-

将pyspark Dataframe写入具有相同列数和一个附加自动增量列的雪花表

我有一个pyspark dataframe有5列,我需要写到雪花表有6列,5列与dataframe列相同,但雪花表中有一个额外的自动增量列。 当我试图将此数据frame写入雪花表,但它给出了一个错误;由于dataframe和Snowflake表中的列数不同,导致列不匹配。我已经尝试了mode='append',但这不起作用。 我希望dataframe中的这5列应该被插入到雪花表中,并且第6个自动递

-

大火花分区尺寸的缺点

我读到过,太多的小分区会因为开销而损害性能,例如,向执行器发送大量任务。 使用最大的分区的缺点是什么?例如,为什么我会看到100s的MB范围内的建议? 如果丢失了一个分区,则需要进行大量的重新计算。对于许多较小的分区,您可能会更经常地丢失分区,但在运行时中的差异会更小。 如果在大分区上执行的少数任务中有一个任务的计算时间比其他任务长,这将使其他核心未被利用,但使用较小的分区,可以更好地在集群中分配

-

花旗一面11.14(四十五分钟)

花旗一面11.14(四十五分钟)海外经历有么? 深挖竞赛经历? 实习经历? 前端搭建在webservice上?怎么搭建这个webservice,怎么提供? http和https差异? 熟悉哪些协议 https协议?证书放在哪里? CDN服务?项目中是否有使用么? 延迟加载(懒加载) json全称 async和sync异步同步区别? 页面loading太慢,如何debug 未来的规划 实习学业是否冲突? 印象最深刻的实习工作内容?

-

mysql LIKE查询花费太长时间

问题内容: SQL: 用户索引: 个人资料索引 解释 : 上面的查询大约需要0.1221 我怎样才能使其运行更快? 问题答案: 我删除了此查询,因此搜索完成后不会显示总结果数。 似乎是临时解决方案,甚至是永久解决方案。

-

Canvas实现动态的雪花效果

Canvas实现动态的雪花效果本文向大家介绍Canvas实现动态的雪花效果,包括了Canvas实现动态的雪花效果的使用技巧和注意事项,需要的朋友参考一下 效果如下: 代码如下: 以上就是本文的全部内容,希望本文的内容对大家的学习或者工作能带来一定的帮助,同时也希望多多支持呐喊教程!

-

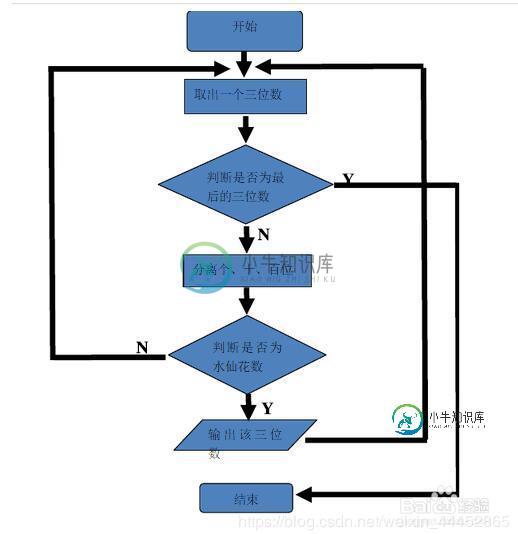

java实现水仙花数的计算

java实现水仙花数的计算本文向大家介绍java实现水仙花数的计算,包括了java实现水仙花数的计算的使用技巧和注意事项,需要的朋友参考一下 看到标题java实现水仙花数,首先先要知道什么是水仙花数,具体了解一下 所谓“水仙花数”是指一个三位数,其各位数字立方和等于该数 列如153=1*1*1+5*5*5+3*3*3 那么153就是水仙花数,首先是分析需要的功能,首先他是一个3位数。 那值一定在100-1000之间,必定

-

火花Kafka生产者可串行化

我想出一个例外: 在这个程序中,我尝试从hdfs路径读取记录,并将它们保存到Kafka中。问题是当我移除关于向Kafka发送记录的代码时,它运行得很好。我错过了什么?

-

DataProc上的Executor心跳超时火花