《kubernetes》专题

-

如何在安装了kubeadm的Kubernetes群集上配置入口控制器

我在Hetzner Cloud上安装了一个带有“kubeadm”的库伯内特斯集群。 安装成功后,我安装了带有Helm的入口控制器。 入口控制器服务的EXTERNAL-IP处于挂起状态。默认类型是LoadBalancer,据我所知,只有AWS、Google等云提供商才支持这种类型。。。 所以我将服务类型更改为NodePort。 我应该如何将外部DNS配置到我的服务? 我不想附加3。。。。端口,但让入

-

在raspberrypi kubernetes集群上将入口部署为监听端口80的演示集需要什么

你好kubernetes专家, 我有一个kubernetes集群,它运行在4个raspberry PI上,docker 18.04ce和kubernetes 1.9.7。 我部署了一个服务,可以通过集群IP从集群内访问此服务。我还部署了一个入口,如https://docs.traefik.io/user-guide/kubernetes/和如何让库伯内特斯IngresPort 80在裸机单节点集群

-

无节点端口的Kubernetes入口控制器

我们正在GKE(谷歌kubernetes引擎)上运行一个API服务器。我们使用Google云endpoint和API密钥处理授权。我们将每个API密钥上的某些IP地址列为白名单。为了做到这一点,我们必须将负载平衡器转换为入口控制器,以公开我们的API服务器。IP白名单不适用于loadbalancer服务。现在,我们有一个类似以下内容的入口设置:

-

kubernetes:nginx ingress vs traefik ingress vs ha proxy ingress vs kong ingress

我们正在研究kubernetes可用的各种开源入口控制器,需要从中选择最好的一个。我们正在评估以下四个入口控制器 Nginx入口控制器 这些在特性和性能方面有什么区别,在生产中应该采用哪一种。请提供您的建议

-

Kubernetes EKS入口和TLS

我正在尝试为应用程序完成一项非常常见的任务: 分配证书并使用TLS/HTTPS对其进行保护。 我花了将近一天的时间搜索留档,尝试多种不同的策略来让它发挥作用,但没有什么对我有用。 最初,我使用Helm在EKS上设置nginx ingress,方法如下:https://github.com/nginxinc/kubernetes-ingress.我尝试使用以下配置使示例应用程序工作(cafe): 入

-

具有集群ip服务和默认nginx的kubernetes入口控制器无法按预期工作

有一个kubernetes裸机集群,有7个节点。安装了helm并添加了helm repo ingres-nginxhttps://kubernetes.github.io/ingress-nginx在我的局域网中,我创建了一个dns一个可以在我的局域网中解析的记录。 工作原理:https://matthewpalmer.net/kubernetes-app-developer/articles/k

-

Kubernetes Nginx入口控制器公开Nginx Web服务器

我基本上希望通过URL从外部访问Nginx hello页面。我已经为运行kubernetes和Nginx ingress:vps的v服务器的子域创建了一个(工作)a记录。我的域名。通用域名格式 我使用以下教程在CoreOS上通过kubeadm将Kubernetes安装为单节点集群:https://kubernetes.io/docs/setup/independent/install-kubead

-

Kubernetes nginx ingress controller服务(版本0.9.0)拒绝连接

我尝试按照本教程来使用nginx入口控制器。在我尝试让它工作的过程中,一些细节发生了变化——只有一个后端服务而不是两个,一些端口号和所有内容都在默认名称空间中运行。我在CentOS Linux 7.4.1708版虚拟机上有一个kubernetes主机和三个仆从。 后端和默认后端都可以通过各自的服务endpoint在集群内访问。nginx状态页面在外部可用(MasterHostIP:32000/ng

-

如何在为Kubernetes入口服务的GCE L7平衡器中获得自定义healthcheck路径?

我试图在GCE中的Kubernetes(服务器1.6.4)中部署一个grafana实例。我正在使用以下清单: 部署(完整版本): 服务: 入口: 结果表明,grafana的安检为302,而默认的GCE安检为200(来源)。如您所见,部署中有一个自定义readinessProbe(第22行)。 一旦我将这些资源发布到kube apiserver,就会创建出所有内容,不会出错。具体来说,入口获得公共i

-

负载平衡器和Kubernetes服务的外部IPs类型之间有什么区别

我使用的是Kubernetes服务,但我对服务中的外部IP的参数有点困惑: 如果有路由到一个或多个群集节点的外部IP,则可以在这些外部IP上公开Kubernetes服务。通过服务端口上的外部IP(作为目标IP)进入集群的流量将路由到其中一个服务endpoint。外部IP不由Kubernetes管理,由集群管理员负责。 我不确定负载均衡器类型服务和使用外部IP的服务之间的区别。 我可以使用负载平衡器

-

Google Kubernetes引擎入口注释

我在google Kubernetes引擎上配置入口。我是ingress的新手,但据我所知,ingress可以服务于不同的负载平衡器,不同的LBs应该进行不同的配置。 我从GKE上的一个简单入口配置开始: 它工作得很好,所以我有两种不同的NodePort服务web np和etcd np。但现在我需要用一些重写规则扩展这个逻辑,以便指向服务1的请求将被重定向到另一个np服务,但在服务1之前。html

-

GCE负载平衡器后面的Kubernetes(GCE/GKE)上的Traefik

我已经按照用户指南在库伯内特斯上实现了Traefik。这给了我一个入口控制器,我能够在80和8080上创建一个入口和traefik-ingress-service监听。 我还设置了“gce”入口: 这样做的目的是创建一个GCE负载平衡器,它终止我的TLS,并将所有请求转发给NodePort类型的traefik入口服务。 GCE负载平衡器需要进行健康检查。默认为路径“/”。我以为traefik有个“

-

如何将nginx与Kubernetes(GKE)和googlehttps负载平衡器结合使用

我们利用入口创建HTTPS负载平衡器,直接转发到我们的(通常是nodejs)服务。然而,最近我们希望对NodeJ前面的流量进行更多的控制,而Google负载平衡器没有提供这种控制。 标准化的自定义错误页面 标准重写规则(例如将超文本传输协议重定向到https) 将pod readinessProbes与负载均衡器健康检查解耦(因此当没有健康的pod时,我们仍然可以提供自定义错误页面)。 我们在堆栈

-

gke上的kubernetes/为什么强制使用负载平衡器?

通过GKE进入kubernetes,目前正在裸机上通过kubeadm进行尝试。 在以后的环境中,不需要任何特定的负载平衡器;通过使用nginx入口和入口,可以为www提供服务。 相反,在gke上,使用相同的nginx入口,或者使用gke提供的l7,最终总是得到一个计费负载平衡器。 这似乎不是最终需要的,原因是什么?

-

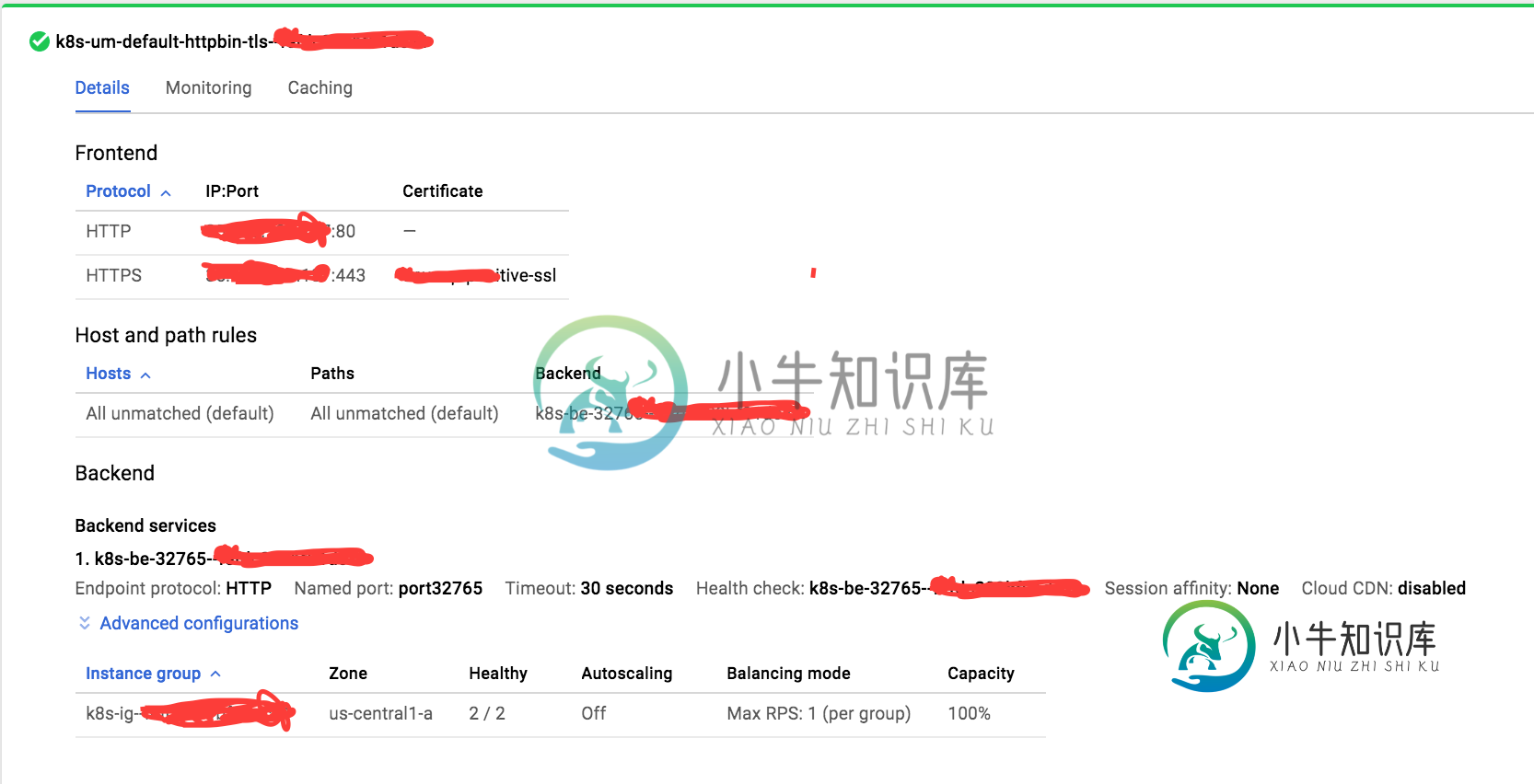

Google云负载平衡器使用Kubernetes入口强制HTTP而不是HTTPS

Google云负载平衡器使用Kubernetes入口强制HTTP而不是HTTPS我正在尝试部署一个Docker容器,它公开了一个简单的Docker服务器,它是Google容器引擎(库伯内特斯)中httpbin.org服务的克隆。 这是我正在使用的服务定义: 入口定义为: 在服务/入口仪表板中,我可以看到两个IP,一个直接绑定到服务(临时),另一个静态IP绑定到入口。直接在80号端口给他们两个打电话很有魅力。 完成后,我为静态IP创建了一个A记录,并确保GKE仪表板中的负载平衡