《GC》专题

-

跨GCP项目在GKE集群中将Google服务帐户与Kubernetes集群服务帐户绑定

我在一个GCP项目中构建了一个Google Kubernetes引擎(GKE)集群。 根据集群上运行的应用程序的不同用例,我将应用程序与不同的服务帐户和不同的授予权限相关联。为此,我将Google服务帐户(GSA)与库伯内特斯集群服务帐户(KSA)绑定如下: 参考:https://cloud.google.com/kubernetes-engine/docs/how-to/workload-ide

-

基于工作负载标识的GKE节点池GCP IAM绑定

我使用Cloud Composer在Kubernetes中运行任务来安排作业。我在与composer相同的GKE中设置了一个新的节点池,并使用它来运行Kubernetes任务。在该节点池中,我使用默认服务帐户,但将该帐户绑定到与Composer节点池相同的服务帐户,使用IAM策略绑定,并启用工作负载标识。 然而,我可以从错误中看到kubernetes服务号缺少作曲家服务号可以访问的一些东西的权限。

-

AttributeError:“tuple”对象没有“authorize”属性-GCP创建工作负载标识联合的服务帐户

我正在尝试在GCP中使用Python创建一个服务帐户。当我将env var GOOGLE_APPLICATION_凭证设置为JSON凭证文件,并使用以下代码时,这一切都很好: 但是,以下代码在使用Workload Identity Federation的CI-Github操作中失败: 失败与错误: 我正在使用以下Github操作向Google进行身份验证 有人能帮忙吗?

-

SPARK-HBASE-GCP模板(2/3)-JSON4S版本问题?

我试图在GCP上下文中测试Spark-HBase连接器,并尝试遵循1,它要求使用Maven(我尝试了Maven 3.6.3)对Spark 2.4进行本地封装连接器[2],在上提交作业时(完成后[3])得到以下错误。 知道吗? 谢谢你的支持 [2]https://github.com/hortonworks-spark/shc/tree/branch-2.4 [3]Spark-HBASE-GCP模板

-

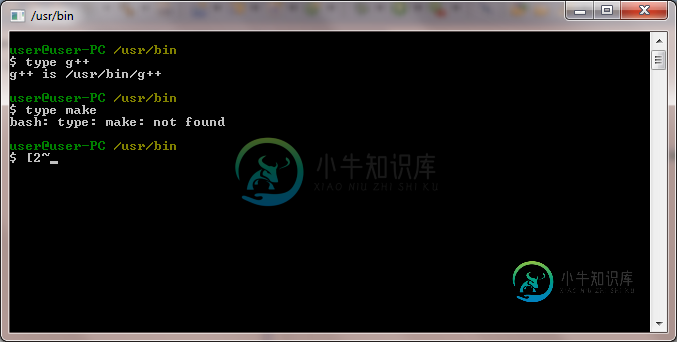

错误:安装eventlet时命令'gcc'失败,退出状态为1

我想在我的系统上安装,以便为软件部署提供“herd”..但是终端显示一个gcc错误: 为什么找不到?

-

使用gcsfuse挂载的Bucket中的数据在Google Cloud实例上运行Docker

我正在尝试运行Docker容器来分析Google Cloud Bucket中的数据。 我已经能够使用成功挂载存储桶,并且我测试了是否可以在存储桶中创建和删除文件之类的操作。 为了能够安装其他程序(并挂载bucket),我安装了Docker(并且没有使用Docker优化实例选项)。如果我在交互模式下运行Docker(不安装驱动器),它看起来工作正常。 但是,如果我尝试以交互模式运行Docker并安装

-

错误:此系统不支持“Cygwin GCC”

错误:此系统不支持“Cygwin GCC”我正在尝试使用Eclipse IDE(使用Windows 7)创建我的第一个C exeecutable。我得到了以下错误,而建设。 如何纠正它? 错误:: 无法获取主线程的上下文,错误 998 信息:配置“Debug”使用此系统不支持的工具链“Cygwin GCC”,仍在尝试构建。 使所有 构建文件:../src/lest test . CPP '[SIG]C:\ cygnus \ Cygwin-

-

JavaScript性能优化-GC算法篇

GC算法简介 1、GC是一种机制,垃圾回收器完成具体的工作 2、工作的内容就是查找垃圾释放空间、回收空间 3、算法就是工作时查找和回收所遵循的规则 常见的GC算法 1、引用计数 2、标记清除 3、标记整理 4、分代回收 GC算法之引用计数算法 1、核心思想:设置引用数,判断当前引用数是否为0 2、引用计数器 3、引用关系发生改变时改变引用数字 4、引用数字为0是立即回收 代码演示如下 co

-

内存篇 - gcore + llnode

2.1.1 Core & Core Dump 在开始之前,我们先了解下什么是 Core 和 Core Dump。 什么是 Core? 在使用半导体作为内存材料前,人类是利用线圈当作内存的材料,线圈就叫作 core ,用线圈做的内存就叫作 core memory。如今 ,半导体工业澎勃发展,已经没有人用 core memory 了,不过在许多情况下, 人们还是把记忆体叫作 core 。 什么是 Co

-

使用 BR 工具恢复 GCS 上的备份数据

本文描述了如何将存储在 Google Cloud Storage (GCS) 上的备份数据恢复到 Kubernetes 环境中的 TiDB 集群。底层通过使用 BR 来进行集群恢复。 本文使用的恢复方式基于 TiDB Operator 新版(v1.1 及以上)的 CustomResourceDefinition (CRD) 实现。 以下示例将存储在 GCS 上指定路径的集群备份数据恢复到 TiDB

-

使用 BR 工具备份 TiDB 集群到 GCS

本文档详细描述了如何将 Kubernetes 上 TiDB 集群的数据备份到 Google Cloud Storage (GCS) 上。BR 会在底层获取集群的逻辑备份,然后再将备份数据上传到远端 GCS。 本文使用的备份方式基于 TiDB Operator 新版(v1.1 及以上)的 CustomResourceDefinition (CRD) 实现。 Ad-hoc 备份 Ad-hoc 备份支持

-

使用 TiDB Lightning 恢复 GCS 上的备份数据

本文描述了将 Kubernetes 上通过 TiDB Operator 备份的数据恢复到 TiDB 集群的操作过程。底层通过使用 TiDB Lightning 来进行集群恢复。 本文使用的恢复方式基于 TiDB Operator 新版(v1.1 及以上)的 CustomResourceDefinition (CRD) 实现。基于 Helm Charts 实现的备份和恢复方式可参考基于 Helm C

-

使用 Dumpling 备份 TiDB 集群数据到 GCS

本文档详细描述了如何将 Kubernetes 上 TiDB 集群的数据备份到 Google Cloud Storage (GCS) 上。本文档中的“备份”,均是指全量备份(Ad-hoc 全量备份和定时全量备份),底层通过使用 Dumpling 获取集群的逻辑备份,然后再将备份数据上传到远端 GCS。 本文使用的备份方式基于 TiDB Operator 新版(v1.1 及以上)的 CustomRes

-

在 GCP GKE 上部署 TiDB 集群

本文介绍了如何在 GCP GKE 上部署 TiDB 集群。 环境准备 部署前,请确认已安装以下软件: Helm:用于安装 TiDB Operator gcloud:用于创建和管理 GCP 服务的命令行工具 完成 GKE 快速入门 中的准备工作 (Before you begin) 该教程包含以下内容: 启用 Kubernetes API 配置足够的配额等 部署集群 配置 GCP 服务 gcloud

-

1.10.12 6.12. GCC-4.0.3

GCC 软件包包含 GNU 编译器,其中有 C 和 C++ 编译器。 预计编译时间: 22 SBU (含测试套件)所需磁盘空间: 566 MB (含测试套件) 6.12.1. 安装 GCC 使用一个 sed 命令来禁止 GCC 安装它自己的 libiberty.a 。我们将使用 Binutils 附带的 libiberty.a 来代替: sed -i 's/install_to_$(INSTALL