《HDFS》专题

-

在HDFS上预共分组表和在Spark中用零洗牌读取表

作为spark作业的一部分,我有两个表要加入/合并,这在每次运行作业时都会引起很大的洗牌。我想通过存储一次共分组数据来摊销所有工作的成本,并将已经共分组的数据作为定期Spark运行的一部分,以避免洗牌。 为了实现这一点,我将一些HDFS中的数据存储在拼花板格式中。我正在使用Parquet重复字段来实现以下模式 (日期,[aRecords],[bRecords]) 在这种情况下,aRecords和b

-

Spark ml模型保存到hdfs

我正在尝试将我的模型保存为从spark ml库创建的对象。 但是,它给了我一个错误: 以下是我的依赖项: 我还想将从模型生成的dataframe保存为CSV。

-

Hadoop HDFS-保留许多部分文件还是concat?

请仅参考map-reduce性能问题。我不关心以任何其他方式拆分或合并这些结果。

-

用Scala编写HDFS输出文件

我正在尝试使用Scala编写一个HDFS输出文件,收到以下错误: 线程“main”org.apache.spark.sparkException中的异常:任务不可序列化,位于org.apache.spark.util.closurecleaner$.ensureclealizable(closurecleaner.scala:315)位于org.apache.spark.util.closurec

-

上载资源文件时createBlockOutputStream中出现Spark HDFS异常

我正试图使用在集群中运行我的JAR,但过了一段时间后出现异常。失败之前的最后一个是。我检查了所有的安全组,成功地执行了,但仍然得到错误。 ./bin/spark提交——类别MyMainClass——主纱线簇/tmp/myjar-1.0。jar myjar参数 ./bin/hadoop fs-ls /user/henrique/.sparkStaging/

-

Hadoop集群kerberized时无法访问HDFS

我成功地kerberized了一个测试Hortonworks集群。Ambari为这些服务创建了keytabs,并且它们都已启动。名称编号有HA。备用名称节点启动得快,活动名称节点需要更长得时间。Namenode UI显示一切都是正确的。可以使用Kerberos登录。名称编号为nn1.zim.com和nn2.zim.com 这个配置会有什么问题呢?以hdfs登录,用kinit-kt加载keytab。

-

从另一个运行Spark的Docker容器写入Docker中运行的HDFS

从另一个运行Spark的Docker容器写入Docker中运行的HDFS我有一个Docker的图像火花Jupyter(https://github.com/zipfian/spark-install) 我为hadoop准备了另一个docker图片。(https://github.com/kiwenlau/hadoop-cluster-docker) 我在Ubuntu中运行上述两张图片中的两个容器。对于第一个容器:我能够成功地启动jupyter并运行python代码:

-

对HDFS的色调访问:绕过默认色调。伊尼?

我正试图用bde2020提供的图像构建一个轻量级的最小hadoop堆栈(学习目的)。现在,堆栈包括(除其他外) 名称节点 基本上,我从大数据欧洲官方docker撰写开始,并根据他们的留档添加了色调图像 色调的文件浏览器无法访问HDFS: 将所有服务显式放到同一网络上 当我登录到hue的容器时,我可以看到namenode的端口9870是打开的()。50070不是。我认为我的问题与网络无关。尽管编辑了

-

flink hadoop实现问题-无法找到方案hdfs的文件系统实现

我正在努力将hdfs集成到flink。 Scala二进制版本:2.12, Flink(群集)版本:1.10.1 这里是HADOOP_CONF_DIR; hdfs的配置在这里; 这个配置和HADOOP_CONF_DIR在任务管理器中也是一样的。 pom.xml; 我试图从hdfs获取拼花地板文件的全部内容,我的示例代码就在那里; 错误就在这里; 这是一个奇怪的部分,正如您在lib文件夹下看到的Had

-

配置多个节点后hdfs dfs ls不工作

我开始学习在线教程,在我的单个本地VM上配置多个NDOE。以下是主节点上的主机: 下面是用于工作的命令: 现在我看到下面的错误消息: 我的配置有什么问题?我应该在哪里检查和纠正它? 非常感谢。

-

hdfs dfs-ls命令的结果

在执行hdfs dfs-ls命令时,我想知道结果是集群中存储的所有文件,还是执行它的节点中的分区。我是hadoop的新手,在每个节点中插入分区时遇到了一些问题。 谢谢你

-

用Java读取远程HDFS文件

我有一个简单的Hadoop安装有点麻烦。我已经下载了hadoop 2.4.0并安装在一个CentOSLinux节点(虚拟机)上。我已经为apache站点(http://hadoop.apache.org/docs/r2.4.0/hadoop-project-dist/hadoop-common/SingleCluster.html)上描述的具有伪分布的单个节点配置了hadoop。它从日志中没有问题

-

hadoop将本地文件系统文件夹复制到HDFS

我需要从本地文件系统复制一个文件夹到HDFS。我找不到任何例子移动文件夹(包括它的所有子文件夹)到HDFS

-

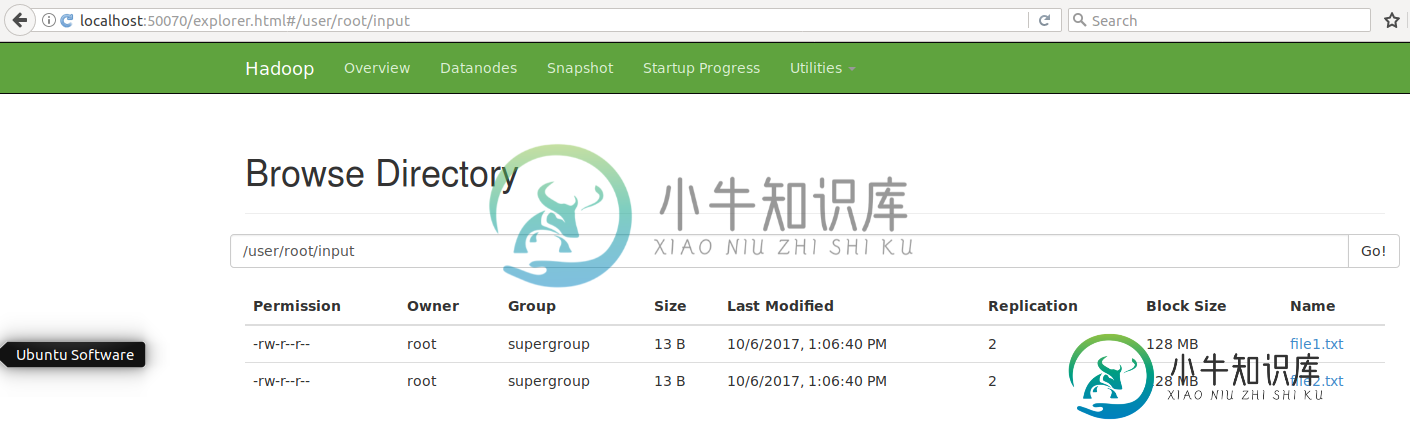

如何将文件从本地文件系统复制到HDFS文件系统?

我已经在Ubuntu 14.04上安装了hadoop。每当我将文件从本地文件系统复制到HDFS时,我都会出现以下错误。 我使用这个命令: 我遇到的错误是: 我是Linux环境的新手。我不明白哪个文件不存在。

-

如何加载文件从hdfs到本地服务器使用腻子?

我想加载一个文件从hdfs到我的本地服务器使用puty,然后重命名,并再次加载回hdfs。我怎么能这样做呢?我需要它的Unix命令。任何帮助将不胜感激。