《HDFS》专题

-

写入HDFS只能复制到0个节点,而不能复制minReplication(= 1)

问题内容: 我有3个数据节点在运行,在运行作业时出现以下错误提示, java.io.IOException:文件/ user / ashsshar / olhcache / loaderMap9b663bd9只能复制到0个节点,而不是minReplication(= 1)。有3个数据节点在运行,并且此操作中不包括3个节点。在org.apache.hadoop.hdfs.server.blockma

-

如何在hadoop hdfs中列出目录及其子目录中的所有文件

问题内容: 我在hdfs中有一个文件夹,其中有两个子文件夹,每个文件夹有大约30个子文件夹,最后每个子文件夹都包含xml文件。我想列出所有仅提供主文件夹路径的xml文件。在本地,我可以使用apache commons-io的 FileUtils.listFiles()执行此操作。我已经试过了 但是它仅列出了前两个子文件夹,并且没有进一步介绍。有什么办法可以在Hadoop中做到这一点? 问题答案:

-

尝试从Java中的HDFS读取文件时出现“错误的FS…预期:file:///”

问题内容: 我无法使用Java从HDFS读取文件: 我没有设置我们的HDFS,所以我不知道我不知道的东西。任何帮助表示赞赏。 问题答案: 试试这个: 请参考http://techidiocy.com/java-lang-illegalargumentexception-wrong-fs- expected-file/ 解决了类似的问题。

-

使用Java API将Parquet格式写入HDFS,而无需使用Avro和MR

问题内容: 什么是简单的方式来写 镶木格式 到 HDFS 通过(使用Java API) 直接创建平面架构 一个POJO的,不使用 的Avro 和 MR ? 我发现的样品已经过时,并且使用不推荐使用的方法,还使用了Avro,spark或MR之一。 问题答案: 实际上,没有外部框架的帮助,没有太多可用于读取/写入Apache Parquet文件的示例。 镶木地板库的核心是镶木地板列,您可以在其中找到一

-

关于hadoop HDFS文件系统重命名

问题内容: 我正在将大量数据存储到hdfs中。我需要将文件从一个文件夹移动到另一个文件夹。 请问一般来说,文件系统重命名方法的成本是多少?假设我必须移动TB的数据。 非常感谢你。 问题答案: 在HDFS或任何文件系统(如果实施得当)中移动文件涉及对名称空间的更改,而不涉及实际数据的移动。遍历代码仅完成“名称”节点中名称空间(内存和编辑日志)的更改。 从NameNode.java类 NameNode

-

从Windows使用Java和Kerberos Keytab访问Cloudera上的HDFS

问题内容: 我正在尝试连接到在Cloudera上运行的HDFS实例。我的第一个步骤启用Kerberos和创建Keytabs(如图所示这里)。 在下一步中,我想使用密钥表进行身份验证。 它失败并显示以下错误 java.io.IOException:从keytab /etc/hadoop/conf/hdfs.keytab登录hdfs @ CLOUDERA失败:javax.security.auth.l

-

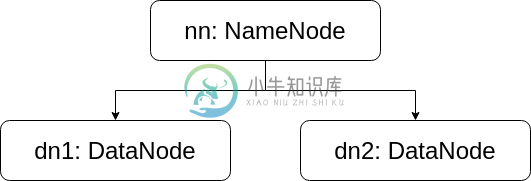

hdfs的体系结构

本文向大家介绍hdfs的体系结构相关面试题,主要包含被问及hdfs的体系结构时的应答技巧和注意事项,需要的朋友参考一下 解答: hdfs有namenode、secondraynamenode、datanode组成。 为n+1模式 namenode负责管理datanode和记录元数据 secondraynamenode负责合并日志 datanode负责存储数据

-

如何序列化hadoop中的对象(在HDFS中)

问题内容: 我有一个HashMap >。我想将我的HashMap对象(hmap)序列化为HDFS位置,然后在Mapper和Reducers上反序列化以使用它。 为了在HDFS上序列化我的HashMap对象,我使用了如下的普通Java对象序列化代码,但是出现了错误(权限被拒绝) 我有以下异常 有人可以建议或分享在hdfs上的hadoop中如何序列化对象的示例代码吗? 问题答案: 请尝试使用来自Apa

-

使用Java在hdfs中写入文件

问题内容: 我想在HDFS中创建文件并在其中写入数据。我使用以下代码: 它创建文件,但不写入任何内容。我搜索了很多,但没有找到任何东西。我怎么了 我是否需要任何权限才能在HDFS中写入? 问题答案: 的替代方法,你可以在获取文件系统时传递URI

-

Python从HDFS读取文件作为流

问题内容: 这是我的问题:我在HDFS中有一个文件,该文件可能很大(=不足以容纳所有内存) 我想做的是避免必须将此文件缓存在内存中,而仅像逐行处理常规文件一样逐行处理它: 我正在寻找是否有一种简单的方法可以在不使用外部库的情况下正确完成此操作。我可能可以使它与libpyhdfs或python- hdfs一起使用, 但我想尽可能避免在系统中引入新的依赖项和未经测试的库,尤其是因为这两个似乎都没有得到

-

在映射器中逐行从HDFS读取文本文件

问题内容: 下面的Mappers代码从HDFS读取文本文件正确吗?如果是这样的话: 如果不同节点中的两个映射器尝试几乎同时打开文件,会发生什么情况? 是否不需要关闭?如果是这样,如何在不关闭文件系统的情况下执行此操作? 我的代码是: 问题答案: 这将起作用,并进行一些修改-我假设您粘贴的代码被截断了: 您可以有多个映射器读取同一个文件,但是使用分布式缓存存在更多的局限性(不仅减少了承载文件块的数据

-

5.0 HDFS 集群

5.0 HDFS 集群主要内容:部署集群HDFS 集群是建立在 Hadoop 集群之上的,由于 HDFS 是 Hadoop 最主要的守护进程,所以 HDFS 集群的配置过程是 Hadoop 集群配置过程的代表。 使用 Docker 可以更加方便地、高效地构建出一个集群环境。 每台计算机中的配置 Hadoop 如何配置集群、不同的计算机里又应该有怎样的配置,这些问题是在学习中产生的。本章的配置中将会提供一个典型的示例,但 Hadoop 复

-

4.0 HDFS 配置与使用

4.0 HDFS 配置与使用主要内容:HDFS 配置和启动,HDFS 使用,实例之前提到过的 Hadoop 三种模式:单机模式、伪集群模式和集群模式。 单机模式:Hadoop 仅作为库存在,可以在单计算机上执行 MapReduce 任务,仅用于开发者搭建学习和试验环境。 伪集群模式:此模式 Hadoop 将以守护进程的形式在单机运行,一般用于开发者搭建学习和试验环境。 集群模式:此模式是 Hadoop 的生产环境模式,也就是说这才是 Hadoop 真正使用的模式,用于提供生产

-

HDFS 中的 Spark 类路径

对于运行在YARN (yarn-client)上的Spark作业,可以用位于HDFS的jar指定类路径吗 这有点像使用Map Reduce jobs:

-

汇合5.0.0 kafka connect hdfs接收器:无法描述升级后kafka connect消费者群体的滞后

我们从ConFluent 4.0.0升级到5.0.0,升级后我们无法列出kafka连接hdfs接收器连接器消费者滞后。 kafka 2.0/conFluent 5.0.0中的消费者组命令是否有任何修改?我如何跟踪我们需要根据此滞后发出警报的滞后?我们的代理在kafka 1.1.0版上运行。升级后也无法在kafka管理器中看到连接消费者组。kafka连接没有问题,因为连接器能够写入hdfs。谢谢。