《聚类》专题

-

聚类 - 层次聚类法

对于层次聚类法,我们不需要预先指定分类的数量,这个算方法会将每条数据都当作是一个分类,每次迭代的时候合并距离最近的两个分类,直到剩下一个分类为止。 因此聚类的结果是:顶层有一个大分类,这个分类下有两个子分类,每个子分类下又有两个子分类,依此类推,层次聚类也因此得命。 在合并的时候我们会计算两个分类之间的距离,可以采用不同的方法。如下图中的A、B、C三个分类,我们应该将哪两个分类合并起来呢? 单链聚

-

聚类

聚类是一种无监督学习问题,它的目标就是基于相似度将相似的子集聚合在一起。聚类经常用于探索性研究或者作为分层有监督流程的一部分。 spark.mllib包中支持下面的模型。 k-means算法 GMM(高斯混合模型) PIC(快速迭代聚类) LDA(隐式狄利克雷分布) 二分k-means算法 流式k-means算法

-

聚类

内容: 层次聚类法 编写层次聚类算法 k-means聚类算法 安然事件 前几章我们学习了如何构建分类系统,使用的是已经标记好类别的数据集进行训练: 训练完成后我们就可以用来预测了:这个人看起来像是篮球运动员,那个人可能是练体操的;这个人三年内不会患有糖尿病。 可以看到,分类器在训练阶段就已经知道各个类别的名称了。那如果我们不知道呢?如何构建一个能够自动对数据进行分组的系统?比如有1000人,每人有

-

聚类

聚类是一种无监督机器学习方法,它基于数据的内部结构寻找观察样本的自然族群(即集群),常用于新闻分类、推荐系统等。聚类的特点是训练数据没有标注,通常使用数据可视化评价结果。 聚类的常用方法包括 K均值聚类:把n个点(可以是样本的一次观察或一个实例)划分到k个聚类中,使得每个点都属于离它最近的均值(即聚类中心)对应的聚类,以之作为聚类的标准。 Affinity Propagation聚类:基于样本之间

-

聚类 - k-means聚类算法

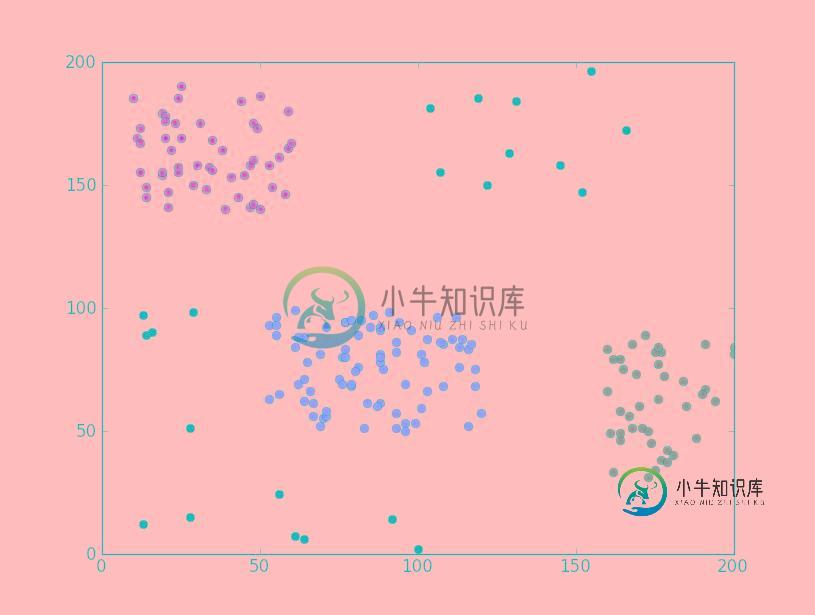

使用k-means算法时需要指定分类的数量,这也是算法名称中“k”的由来。 k-means是Lloyd博士在1957年提出的,虽然这个算法已有50年的历史,但却是当前最流行的聚类算法! 下面让我们来了解一下k-means聚类过程: 我们想将图中的记录分成三个分类(即k=3),比如上文提到的犬种数据,坐标轴分别是身高和体重。 由于k=3,我们随机选取三个点来作为聚类的起始点(分类的中心点),并用红黄

-

聚类 - PIC(快速迭代聚类)

1 谱聚类算法的原理 在分析快速迭代聚类之前,我们先来了解一下谱聚类算法。谱聚类算法是建立在谱图理论的基础上的算法,与传统的聚类算法相比,它能在任意形状的样本空间上聚类且能够收敛到全局最优解。 谱聚类算法的主要思想是将聚类问题转换为无向图的划分问题。 首先,数据点被看做一个图的顶点v,两数据的相似度看做图的边,边的集合由$E=A_{ij}$表示,由此构造样本数据集的相似度矩阵A,并求出拉普拉斯

-

Python聚类算法之凝聚层次聚类实例分析

Python聚类算法之凝聚层次聚类实例分析本文向大家介绍Python聚类算法之凝聚层次聚类实例分析,包括了Python聚类算法之凝聚层次聚类实例分析的使用技巧和注意事项,需要的朋友参考一下 本文实例讲述了Python聚类算法之凝聚层次聚类。分享给大家供大家参考,具体如下: 凝聚层次聚类:所谓凝聚的,指的是该算法初始时,将每个点作为一个簇,每一步合并两个最接近的簇。另外即使到最后,对于噪音点或是离群点也往往还是各占一簇的,除非过度合并。对于

-

Activiti聚类

我对Activiti非常陌生。我有一个具体的问题,假设我有两个ativiti引擎在两个实例上运行,并且两者都共享公共存储库。目前,如果我在实例A上启动任何任务,并且由于Activiti的默认特性而突然关闭它,它会被B选中,这正是我不想发生的,因为两个实例运行不同版本的软件。我需要下面的行为“在实例A上启动的作业应该由活动A完成,前提是我们暂停它”。这是可能的吗? 非常感谢!

-

2.3. 聚类

校验者: @花开无声 @小瑶 翻译者: @小瑶 @krokyin 未标记的数据的 Clustering(聚类) 可以使用模块 sklearn.cluster 来实现。 每个 clustering algorithm (聚类算法)有两个变体: 一个是 class, 它实现了 fit 方法来学习 train data(训练数据)的 clusters(聚类),还有一个 function(函数),是给定

-

聚类 - 编写层次聚类算法

我们可以使用优先队列来实现这个聚类算法。 什么是优先队列呢? 普通的队列有“先进先出”的规则,比如向队列先后添加Moa、Suzuka、Yui,取出时得到的也是Moa、Suzuka、Yui: 而对于优先队列,每个元素都可以附加一个优先级,从队列中取出时会得到优先级最高的元素。比如说,我们定义年龄越小优先级越高,以下是插入过程: 取出的第一个元素是Yui,因为她的年龄最小: 我们看看Python中如何

-

K-Means 聚类算法 kmeans 聚类算法

算法介绍 K-Means又名为K均值算法,他是一个聚类算法,这里的K就是聚簇中心的个数,代表数据中存在多少数据簇。K-Means在聚类算法中算是非常简单的一个算法了。有点类似于KNN算法,都用到了距离矢量度量,用欧式距离作为小分类的标准。 算法步骤 (1)、设定数字k,从n个初始数据中随机的设置k个点为聚类中心点。 (2)、针对n个点的每个数据点,遍历计算到k个聚类中心点的距离,最后按照离哪个中心

-

反极聚类

我做了一个照片拼接脚本(PHP)。这个脚本有一张图片,并将其更改为小图片的照片堆积。从远处看,它看起来像真实的图片,当你靠近时,你会看到它都是小图片。我取一个固定像素数的正方形,并确定该正方形的平均颜色。然后我将此与我的数据库进行比较,该数据库包含几千张图片的平均颜色。我用所有可用的图像确定颜色距离。但是要完全运行这个脚本需要几分钟。 瓶颈是将最佳图片与主图片的一部分相匹配。我一直在网上搜索如何减

-

k-means 聚类

聚类 聚类,简单来说,就是将一个庞杂数据集中具有相似特征的数据自动归类到一起,称为一个簇,簇内的对象越相似,聚类的效果越好。它是一种无监督的学习(Unsupervised Learning)方法,不需要预先标注好的训练集。聚类与分类最大的区别就是分类的目标事先已知,例如猫狗识别,你在分类之前已经预先知道要将它分为猫、狗两个种类;而在你聚类之前,你对你的目标是未知的,同样以动物为例,对于一个动物集来

-

K-means 聚类

k-means 算法,也被称为 k-平均 或 k-均值,是一种得到最广泛使用的聚类算法。 它把n个点(可以是样本的一次观察或一个实例)划分到k个聚类中,使得每个点都属于离他最近的均值(此即聚类中心)对应的聚类,以之作为聚类的标准。 相异度计算方法: 欧几里得距离 曼哈顿距离 闵可夫斯基距离 皮尔逊相关系数 优点 简单、快速,可并行计算 已经获得防范的应用 缺点 必须事先给出k(要生成的簇的数目),

-

2.4. 双聚类

校验者: @udy 翻译者: @程威 Biclustering 可以使用 sklearn.cluster.bicluster 模块。 Biclustering 算法对数据矩阵的行列同时进行聚类。 同时对行列进行聚类称之为 biclusters。 每一次聚类都会通过原始数据矩阵的一些属性确定一个子矩阵。 例如, 一个矩阵 (10, 10) , 一个 bicluster 聚类,有三列二行,就是一个子矩