《kafka》专题

-

阿帕奇Storm三叉戟与Kafka喷口集成

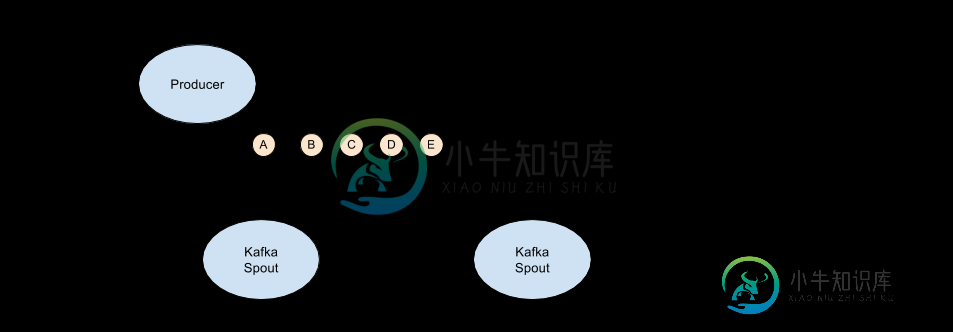

我无法找到正确集成Kafka和Apache Storm Trident的好文档。我试图查看相关的问题之前张贴在这里,但没有充分的信息。 这样,我就可以为我的拓扑生成流,如下面的代码所示 虽然我提供了并行性和我的分区,但是只有一个Kafka Spout的执行器在运行,因此我无法很好地扩展它。 有谁能指导我更好地将Apache Storm Trident(2.0.0)与Apache Kafka(1.0

-

Kafka Spout没有从broker读取补偿,只是从Zookeeper读取特定消息后

我对阿帕奇Storm和Kafka有意见。KafkaSpout正常读取来自Kafka的消息,但在大约30,000条消息之后,失败的元组开始出现,博尔特没有收到任何消息。 我查看worker.log并看到,当拓扑启动时,它尝试从Zookeeper读取分区信息,然后在broker中读取分区信息,成功了,如您所见:偏移量9539 Tweets正常保存,然后Kafka Spout尝试从Zookeeper读取

-

Storm1.1.0+KAFKA0.10.2.1:NoSuchMethodError&ExceptioninInitializerError

我对storm和Kafka都是新手。我想运行一个开源项目:github:cestella:streaming_outliers 这个项目使用Storm0.10.0。但是,我的storm集群是Storm1.0.3,这对Storm0.10.0不起作用。 java.lang.nosuchmethoderror:org.apache.kafka.common.network.networksend.(Lj

-

Apache Storm没有收到来自kafka的消息

我正在尝试把阿帕奇Storm和Kafka整合在一起。连接似乎建立良好,但没有收到任何消息。但是这些消息似乎也被发送到了Kafka服务器,而Kafka服务器中相应主题的索引文件显示存在一些数据。有没有一种方法可以在Storm End上调试这个更多的..?我正在使用Storm的客户解码器来处理信息。Storm的实现是:

-

Kafka Storm HDFS/S3数据流

现在还不清楚你是否能像在《水槽》中那样在Kafka中做一个扇出(复制)。 我想让Kafka将数据保存到HDFS或S3,并将该数据的副本发送到Storm进行实时处理。Storm集合/分析的输出将存储在Cassandra中。我看到一些实现将所有数据从Kafka流到Storm,然后从Storm输出两个。但是,我想消除Storm对原始数据存储的依赖。 这可能吗?您知道任何类似的文档/示例/实现吗? 还有,

-

启用SSL的Storm Kafka喷口

我想知道是否有任何Kafka喷口支持安全的Kafka经纪人。apache storm的KafkaSpout不支持SSL Kafka。 下面提到的Kafka不接受SSL Kafka生产者/消费者支持的任何参数。 请让我知道有没有任何方法,我们可以实现安全的Kafka消息流处理与Storm拓扑。

-

Storm UI抛出“kafka的偏移滞后不支持旧版本。请将kafka spout更新到最新版本。“

Storm UI显示一条消息:“旧版本不支持kafka的偏移滞后。请将kafka spout更新到最新版本。”在“拓扑喷出滞后误差”下是什么意思?

-

Storm KafkaSpout停止使用来自Kafka主题的消息

2016-07-05 03:59:25.042 O.A.S.D.Executor[INFO]正在处理-2元组的接收消息:源:__System:-1,流:__Tick,ID:{},[30] 2016-07-05 03:59:25.946 O.A.S.D.Executor[INFO]正在处理-2元组的接收消息:源:__System:-1,流:__Metrics_Tick,ID:{},[60] 我的测试

-

为什么我的Kafka留言都在暴风里重播?

为什么我的Kafka留言都在暴风里重播?我试图弄清楚为什么每次我重新启动我的Storm拓扑时,我所有的Kafka消息都被重播。 我的理解是,一旦最后一个Bolt对元组进行了处理,spout就应该在Kafka上提交消息,因此在重新启动后我不应该看到它的重播。 我的代码是一个简单的Kafka喷口和一个螺栓,只是打印每一个消息,然后处理他们。 澄清一下,在我重新启动管道之前一切正常。下面的行为是我可以在其他(非Storm)消费者身上得到的,也

-

org.apache.kafka.common.KafkaException:使用自定义对象Serializer构造kafka生产者失败

我编写了一个spring kafka包,使用spring boot将消息发送到kafka主题,其中“Key”作为字符串,“Arraylist”作为值。“Custom Object”是一个具有属性item id、item name和item ordered count的类。 Kafka制作人日志如下所示。 我编写了一个自定义序列化程序,如下所示。 “Arraylist”的Serde类如下所示。 Ka

-

Spring Kafka-显示带有@重试的自定义错误消息

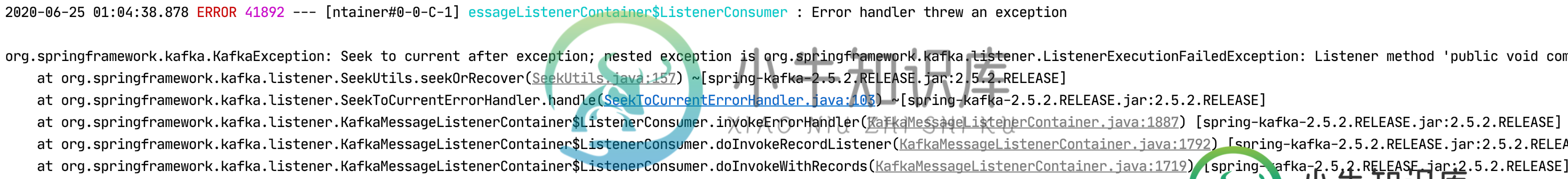

Spring Kafka-显示带有@重试的自定义错误消息我目前正在使用Spring Kafka来使用topic中的消息以及Spring的@Retry。因此,基本上,我正在尝试处理消费者消息以防出现错误。但在这样做时,我希望避免KafkaMessageListenerContainer抛出的异常消息。相反,我想显示一条自定义消息。我尝试在ConcurrentKafkAlisterContainerFactory中添加错误处理程序,但这样做时,我的重试没有

-

Spring kafka@KafkaListener未被调用

我正在尝试使用SpringKafka将kafka与我的SpringBoot(v2.0.6版本)应用程序集成。现在我想要一个消费者和一个生产者。我让制作人工作得很好,我可以看到通过控制台消费者发送到主题的消息。我无法使用消费者代码,当Kafka主题中出现新消息时,它不会被调用。 这是我的Kafka配置类: 以下是我的pom依赖项: 以及消费者代码: 我正在我的计算机上运行kafka,正如我所说的——

-

如何将数据从Kafka传递到Spark Streaming?

我正试图将数据从Kafka传递到火花流。 这就是我到现在所做的: null

-

如何在Kafka中阻止消费者同时消费信息?

我有一个简单的Kafka消费者微服务应用程序,它使用来自某个主题的消息,同一个应用程序运行在两个不同的池中。 所以,当消息由制作人生成,而我的应用程序尝试使用来自主题的消息时,它只被一个池中的一个人使用。 如何停止从消费者Kafka读取并发消息。我想在两个池中使用相同的消息。 这种情况下可能的解决方案是什么

-

如何告诉spring kafka消费者在运行时停止消费?

我正在使用带有KafkaListener注释的spring kafka v2.5.2。 在运行时,我希望能够向消费者发送停止消费的信号。 我看到了autoStartup参数,但它似乎只对初始化有效,之后无法更改。 我看到了KafkaListenerEndpointRegistry的methode close()。。。 你有什么建议吗? 提前谢谢。