《log4j》专题

-

Log4j中未生成日志文件

我试图实现log4j。我用log4j创建了一个示例java程序。 下面是我的log4j。属性: 我正在控制台屏幕上获取输出。但是没有生成日志文件。我必须做什么才能生成日志文件,谢谢

-

用于处理Logstash中log4j日志模式的grok过滤器

我一直在寻找grok过滤器,用于处理log4j日志中的转换模式 下面是一个示例日志条目: 谁能帮我找到Logstash grok过滤器。

-

MDC与Log4j不能正常工作

嗨,我想在日志模式中显示登录的用户ID、主机名、ip地址等。我也在使用log4j。我正在使用MDC。在我的主控制器中,我可以看到带有指定模式的日志,但在其他文件日志中,我无法看到模式,这是不是好像我在某个会话中设置了MDC,并在其他控制器中再次放置了上下文值?请建议。 log4j.properties 我还有其他不同的控制器。现在,主控制器中的logger语句在日志模式中显示上下文信息,但在其他控

-

条件log4j。xml应用模式

因为%C和%M是资源密集型的 %d{yyyy-MM-dd HH:MM:ss}[%C][%M][%t] 我希望%C和%M只有在日志级别设置为调试(或更详细的级别)时才有效。 log4j是否对这种条件输出格式有任何规定?

-

通过glassfish log4j控制自定义记录器

我有一个Web应用程序,使用log4j。我在 /WEB-INF/classes/log4j.properties文件中配置了一个自定义记录器,如下所示: 日志消息按预期写入server.log,但我试图找到一种方法来控制自定义记录器日志级别通过glassfish服务器。 我尝试从命令中创建glassfish中的记录器: 但是,即使asadmin命令将记录器设置为警告,所有INFO消息仍然会被记录。

-

log4j构建一致的日志记录

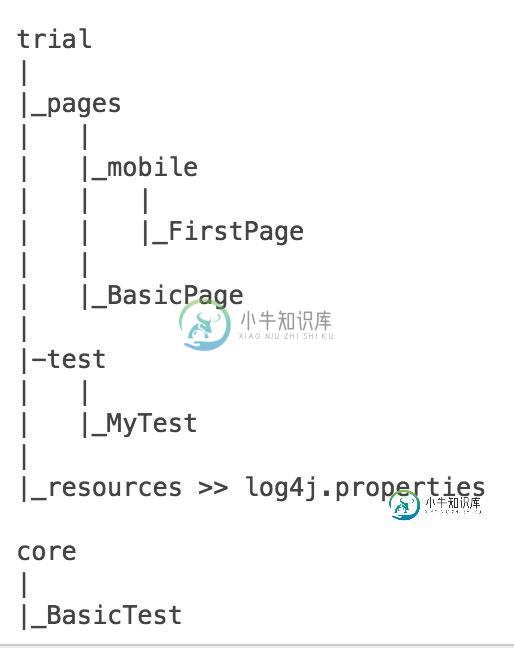

log4j构建一致的日志记录我试图实现log4j日志记录类。代码的包结构如下所述。目前我的log4j.properties放在包的资源下。 我有时确实会得到日志,但有时调试器会显示“log4j: WARN无法为记录器找到附加程序”所以我最后得到了: 我应该在哪里放置log4j.properties来获得MyTest中一致的日志? 同一个项目可以在不同的包中有多个log4j.properties吗? 如何将调试器/编译器的lo

-

Apache气流-Bash操作员成功,但有关于log4j的警告

我正在运行我运行了一个执行 一切都很好,但是当我去我的任务日志,我看到这些: 似乎是Apache未处理的问题?

-

如何恢复此错误:log4j: WARN无法找到记录器的附加程序(net.sf.jasperreports.extensions.扩展环境)

我试图用iReport做报告,但我有这个问题: 我的来源:

-

log4j:警告找不到附加程序

我有一个非常简单的scala应用程序。它所做的只是初始化记录器并logger.info(“你好”)。我在类路径中有一个log4j.properties文件,它具有以下设置 但是,当我尝试运行应用程序时。我得到的错误是log4j:WARN找不到记录器的appender(app.TestApp$)。log4j:警告请正确初始化log4j系统。 我错过了什么?但是,如果我有hadoop core,我会打

-

JavaEclipse和jasper报告:如何定位log4j。房产?

我总是在这件事上出错

-

如何从shell脚本重写Log4j值?

当Kafka JDBC接收器连接器启动时,我使用connect-log4j属性进行日志记录。我试图在connect-log4j.properties中重写shell脚本中的一个值。 我的Shell脚本: //从Shell脚本命令获取process.name process.name=????? log4j.appender.stdout=org.apache.log4j.consoleappend

-

如何在不更改log4j.properties的情况下关闭PySpark日志中的信息?

我在一个集群中工作,在该集群中,我没有权限在使用pyspark时更改文件log4j.properties以停止信息日志记录(如这里的第一个答案所述)上面问题的第一个答案解释了以下解决方案,适用于spark-shell(scala)

-

在Apache Spark中使用Log4j2

对于Apache Spark日志记录,我尝试用Log4j2替换Log4j(到目前为止没有成功)。到目前为止,我已经设法将Log4j2用于我的应用程序日志,但我还想将它用于Spark内部日志(以避免同时存在两个不同的配置和框架)。

-

Spark不接受log4j2.xml

log4j:warn可持续解析错误10和列78 log4j:warn文档根元素“configuration”必须与DOCTYPE根“null”匹配。LOG4J:WARN可持续解析错误10和列78 LOG4J:WARN文档无效:找不到语法。log4j:错误DOM元素是-不是元素。使用Spark默认的log4j配置文件:org/apache/spark/log4j-defaults.propertie

-

从log4j中分离Logback中的应用程序日志和Spark日志

我知道和都在/usr/local/Spark/jars中,尽管在pom.xml中排除了这些jar,但Spark很可能引用了这些jar,因为如果删除它们,在spark-submit的运行时会给出一个ClassNotFoundException。 我的问题是:有没有一种方法可以在我的应用程序中使用Logback实现本机日志记录,同时保留Spark的内部日志记录功能。理想情况下,我希望将我的日志返回应用