《昆仑万维》专题

-

MySQL快速从60万行中选择10条随机行

问题内容: 如何最好地编写一个查询,从总共60万行中随机选择10行? 问题答案: 一个出色的职位,可以处理多种情况,从简单到有缺口,再到有缺口的不均匀。 http://jan.kneschke.de/projects/mysql/order-by- rand/ 对于大多数一般情况,这是您的操作方法: 这假定id的分布是相等的,并且id列表中可能存在间隙。请参阅文章以获取更多高级示例

-

Mysql快速插入千万条数据的实战教程

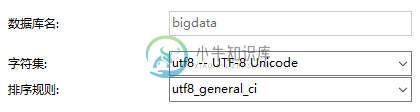

Mysql快速插入千万条数据的实战教程本文向大家介绍Mysql快速插入千万条数据的实战教程,包括了Mysql快速插入千万条数据的实战教程的使用技巧和注意事项,需要的朋友参考一下 一.创建数据库 二.创建表 1.创建 dept表 2.创建emp表 三.设置参数 SHOW VARIABLES LIKE 'log_bin_trust_function_creators'; 默认关闭. 需要设置为1。因为表中设置 mediumint 字段

-

封装好的一个万能检测表单的方法

本文向大家介绍封装好的一个万能检测表单的方法,包括了封装好的一个万能检测表单的方法的使用技巧和注意事项,需要的朋友参考一下 检测表单中的不能为空(.notnull)的验证 作用:一对form标签下有多个(包括一个)表单需要提交时,使用js准确的判断当前按钮对那些元素做判断 用法:在form标签下 找到当前 表单的容器 给予class="form",当前表单的提交按钮给予 class="chec

-

MySQL从60万行中快速选择10条随机行

问题内容: 如何最好地编写一个查询,从总共60万行中随机选择10行? 问题答案: 一个出色的职位,处理从简单到有缺口,再到有缺口不均匀的几种情况。 http://jan.kneschke.de/projects/mysql/order-by- rand/ 对于大多数一般情况,这是您的操作方法: 这假定id的分布是相等的,并且id列表中可能存在间隙。请参阅文章以获取更多高级示例

-

在Python中合并具有数百万行的两个表

问题内容: 我正在使用Python进行一些数据分析。我有两个表,第一个(叫它“ A”)有1000万行和10列,第二个(“ B”)有7300万行和2列。他们有1个具有共同ID的列,我想根据该列将两个表相交。特别是我想要表的内部联接。 我无法将表B作为pandas数据框加载到内存中,以在pandas上使用常规合并功能。我尝试通过读取表B上的文件的块,将每个块与A相交,并将这些交集连接起来(内部联接的输

-

在java中使用lmax Disruptor(3.0)处理数百万文档

我有以下用例: 当我的服务启动时,它可能需要在尽可能短的时间内处理数百万个文档。将有三个数据来源。 我已设置以下内容: 我的每个源调用consume都使用Guice来创建一个单例破坏者。 我的eventHandler例程是 我在日志中看到,制作人(

-

向hbase插入数百万条记录时会出现SocketTimeoutException

我构建了一个由九个节点组成的hbase集群。每个节点都有64GB的内存容量。现在,我想向hbase插入数百万条记录。为了提高写入性能,我在每个节点中创建了20个线程,并且在每个节点中将writebuffer设置为64MB,并且自动刷新为false。 准备好数据并设置好配置后,我启动hbase集群。但当记录达到一定程度时,问题就出现了。 Java语言网SocketTimeoutException:等

-

更新嵌套字段以获取数百万个文档

问题内容: 我对脚本使用批量更新以更新嵌套字段,但这非常慢: 您知道另一种可能更快的方法吗? 为了不对每次更新重复执行脚本,似乎可以存储该脚本,但是我找不到保持“动态”参数的方法。 问题答案: 与性能优化问题一样,由于有许多可能导致性能不佳的原因,因此没有唯一的答案。 在您的情况下,您正在批量请求。当执行,该文件实际上是被重新索引: …要更新文档就是要对其进行检索,更改,然后为整个文档重新编制索引

-

Neo4j 2.1.0-M01严重失败,树图为830万片叶子

(已经在Github上打开了一个案例#2250,但这里可能有人有解决方案?)他讲故事。我们有一个数据集,它只是一个具有 级别为0的单个根节点(有时它的ID(root)=0,因为我们从空数据库开始) 我们正在使用LOAD CSV加载数据,其中每一行创建一个节点和与前一级节点的关系。Neo4j是一个2.1.0-M01 Enterprise for Startups,集群有3个节点,每个实例有8Gb内存

-

使用PySpark生成6000万JSON文件时的OutOfMemoryError[重复]

通过JDBC连接,我能够成功地从Oracle db使用下面的PySpark代码生成6000万记录CSV文件。 根据管理员的要求,我更新了我的评论:这是一些不同的问题,其他outoutmemory问题也存在,但在不同的场景中会得到。错误可能是一样的,但问题是不同的。在我的情况下,我得到了大量的数据。

-

使用带有大型(100万或更多)规则的Drools

我们正在评估一个与医疗相关的软件应用程序的Drools。我们最初的规则集大约是25k,但随着时间的推移,这个规则集将增长到100多万。这就是典型规则的结构: 正在评估的项目将包含一系列代码作为事实。我们试图做的是创建一个推荐引擎,引导用户对项目进行更改以符合法规。我担心的是,我们不能有选择地过滤应该触发哪些规则,而不通过计算所有“when”语句来找到匹配的规则。如果我们有数百万条规则(我们的一些竞

-

筛选埃拉托色尼素数高达一百万c

所以我的代码需要帮助。由于某种原因,当我输入超过500,000的数字时,它总是崩溃。这是确切的分配。 实现埃拉托斯特尼筛,并用它来查找所有小于或等于一百万的素数。使用结果来证明哥德巴赫猜想对于 400 万到 100 万之间的所有偶数(包括 100 万)。 使用以下声明实现函数: 此函数采用整数数组作为其参数。数组应初始化为值 1 到 1000000。该函数修改数组,以便仅保留质数;所有其他值均归零

-

调整kafka性能以每秒获得100万条消息

我使用3个VM服务器,每个都有16个核心/56 GB Ram /1TB,来设置一个kafka集群。我的工作与Kafka0.10.0版本。我在其中两个上安装了一个经纪人。我创建了一个主题,有2个分区,1个分区/代理,没有复制。 我的目标是每秒接收1 000 000条信息。 我用Kafka制作人perf test做了一个测试。sh script和我得到的消息在150000 msg/s和204000 m

-

申万宏源证券资管产品经理岗面经

申万宏源证券资管产品经理岗面经面试流程:6~8人一组进行面试,先各自进行2分钟左右的自我介绍,须说明意向城市、研究方向等内容,然后面试官进行提问,主要针对实习经历 1、说说你能够胜任该岗位的主要优势是什么? 2如何看待资管新规对行业和个人的影响? 3、针对你的简历提出一些个性化问题,比如你是怎么确定自己的职业选择的? 4、你对工作强度大和加班是什么样的看法等等之类的。 5、细询问之前投行的实习经历,包括对投行项目所在行业的了解

-

模板标签参考 - 全局标签 - loop|万能循环

loop|万能循环: 标签名称:loop 标记简介: 功能说明:调用任意表的数据标签 适用范围:全局使用 基本语法: {dede:loop table='dede_archives' sort='' row='4' if=''} <a href='[field:arcurl/]'>[field:title/]</a> {/dede:loop} 参数说明: table = '' 查询表名 sort