《大数据测试》专题

-

如何使用MinMaxScaler sklearn归一化训练和测试数据

问题内容: 因此,我对此有疑问,一直在寻找答案。所以问题是我何时使用 这之后,我将训练和测试模型(,作为特征,如标签),并得到一些准确度得分。现在我的疑问是,当我必须预测新数据集的标签时会发生什么。说, 因为当我规范化列时,和的值将根据新数据而不是将在其上训练模型的数据来更改。因此,现在将是下面的数据准备步骤之后的数据。 的价值和将关于改变和价值。的数据准备是关于的。 有关不同数字的数据准备如何有

-

在代码欺骗(Laravel)中设置验收测试数据库

我正在使用Codeception框架在Laravel5应用程序中执行验收测试。我想使用一个单独的数据库进行测试,以防止真实数据库在测试中发生变化。我配置了服务器。基于Codeception文档的yml文件。但真正的数据库无论如何都会受到影响。这是我的配置文件: /协同感知。yml /测试/验收。一套yml realDB是真实的数据库,在执行验收测试后会发生更改。我尝试了不同的清理案例。一套yml:

-

使用Testcontainers和Liquibase时在测试之间重置数据库

如果我在集成测试中使用的是单例数据库容器,那么在每次测试之前,我如何确保数据库处于干净状态(没有数据)?代码库使用Liquibase进行数据迁移。

-

Spring boot&Spring data rest集成测试无法持久化数据

我正在使用Spring Boot和Spring Data Rest来公开我的数据存储库。 我编写的集成测试将用户添加到数据库中,然后调用rest方法列出用户。但未列出添加的用户。 ApplicationRunner用于在数据库中填充数据,我将Spring配置文件用于不同的数据库。 例如,对于我的测试: 经过更仔细的检查,数据实际上会进入数据库。当我注入UserRepository并调用.count

-

Provider中的PACT使用者驱动的设置测试数据

我正在执行一些测试,如果使用者设置了某个ID或任何文本,而这些ID或文本在提供者数据库中并不存在,那么我希望在提供者测试中执行以下步骤 接收带有以下信息的协议文件:首先需要设置哪些内容 然后我将有我的函数,它将开始将那些不可用的数据插入数据库 然后调用API以提供实际响应。 现在我想知道,消费者应该使用哪个字段来让提供者知道,在实际的API调用之前需要一些先决条件或预设置。

-

在Django进行selenium测试后,数据库仍在使用中

我有一个Django项目,在其中我开始编写Selenium测试。第一个看起来像这样: 运行时,测试通过,但仍以以下错误结束: 当然,问题是在下一次运行测试时,数据库仍然存在,因此,在未确认删除数据库的情况下,测试不会运行。 如果我注释掉最后一行: 那我就不明白这个错误了。我猜只是因为数据库连接没有建立。有时是1次,有时是4次。在4个会话的其中一个案例中,这些是正在运行的会话: 我一直在试图找到这个

-

测试数据库的用户名,无需验证[Firebase/Swift 3]

我目前的问题是,当用户想要在我的应用程序(使用Firebase)上创建帐户时,会发生以下错误: 2017-07-12 21:57:05.958 GeneralMessage[8525][Firebase/Database][I-RDB038012]侦听器位于/users失败:权限被拒绝 我意识到发生错误是因为用户试图从数据库中读取,而没有登录到帐户(经过身份验证)。问题还在于,用户在测试是否使用名

-

非加密信道传输敏感数据测试 (OTG-CRYPST-003)

综述 敏感信息在通过网络传输中必须被保护。如果数据是通过HTTPS或其他加密机制传输的,必须保证没有漏洞或这限制,如在文章 测试弱SSL/TLS加密算法,不充分的传输层保护(OTG-CRYPST-001)[1] 和其他OWASP文档中的描述的问题[2], [3], [4], [5]。 通常根据经验来看,如果数据在存储时必须被保护,那么在传输中也应该如此。下面是一些敏感信息的例子: 用于认证的信息(

-

针对Sqlserver大数据量插入速度慢或丢失数据的解决方法

本文向大家介绍针对Sqlserver大数据量插入速度慢或丢失数据的解决方法,包括了针对Sqlserver大数据量插入速度慢或丢失数据的解决方法的使用技巧和注意事项,需要的朋友参考一下 我的设备上每秒将2000条数据插入数据库,2个设备总共4000条,当在程序里面直接用insert语句插入时,两个设备同时插入大概总共能插入约2800条左右,数据丢失约1200条左右,测试了很多方法,整理出了两种效果比

-

如何预处理“大数据” tsv文件并将其加载到python数据框中?

问题内容: 我目前正在尝试将以下大的制表符分隔的文件导入Python中类似数据框的结构中-自然,我正在使用数据框,尽管我愿意接受其他选择。 该文件大小为几GB,不是标准文件,它已损坏,即行的列数不同。一排可能有25列,另一排可能有21列。 这是数据示例: 如您所见,其中某些列的顺序不正确… 现在,我认为将文件导入数据框的正确方法是对数据进行预处理,以便可以输出带有值的数据框,例如 更复杂的是,这是

-

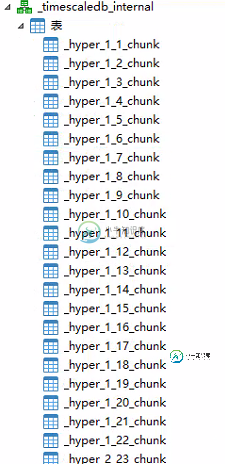

postgresql数据库 timescaledb 时序库 把大数据量表转换为超表的问题

postgresql数据库 timescaledb 时序库 把大数据量表转换为超表的问题本文向大家介绍postgresql数据库 timescaledb 时序库 把大数据量表转换为超表的问题,包括了postgresql数据库 timescaledb 时序库 把大数据量表转换为超表的问题的使用技巧和注意事项,需要的朋友参考一下 前言 这几天工作的时候发现在 timescaledb 时序库 中有部分大数据量的表不是超表,估计是当时建库的时候没有改 影响插入,查询效率 ,因此需要改成超表

-

H2o:迭代大于内存的数据,而不将所有数据加载到内存

有没有一种方法可以使用H2O迭代大于集群累积内存大小的数据?我有一个大数据集,我需要批量迭代并输入Tensorflow进行梯度下降。在给定的时间,我只需要在内存中加载一批(或少数)。有没有一种方法可以设置H2O来执行这种迭代,而无需将整个数据集加载到内存中? 这是一个相关的问题,一年多前就已经回答了,但没有解决我的问题:在h2o中加载大于内存大小的数据

-

大摇大摆的用户界面-打开api 3,多部分/表单数据数组问题

我正在使用OpenApi 3.0.2规范使用swagger ui。 我设置了一个带有多部分/表单数据内容的requestBody 当我执行来自swagger ui的请求时,一切都正常,但是 如果我添加一个array类型的参数,它将以这种方式在curl调用中转换: 我需要分解数组 我看了看留档,找到了一些样式和爆炸属性,但它们只适用于参数属性,而不是请求体(?)。 在我的路线文件中: media-i

-

TestNG-在测试执行报告中可以忽略数据提供者测试方法吗?

我正在使用dataProvider方法并使用此数据提供者形成一个URL,并且应该将此形成的URL传递给下一个数据提供者。在TestNG-测试执行报告中可以忽略此数据提供者测试方法吗? TestNG-test execution报告中应忽略第一个数据提供程序A

-

如何使用TensorFlow清理数据以预测Auto MPG数据的燃油效率?

本文向大家介绍如何使用TensorFlow清理数据以预测Auto MPG数据的燃油效率?,包括了如何使用TensorFlow清理数据以预测Auto MPG数据的燃油效率?的使用技巧和注意事项,需要的朋友参考一下 Tensorflow是Google提供的一种机器学习框架。它是一个开放源代码框架,与Python结合使用以实现算法,深度学习应用程序等等。 可以使用下面的代码行在Windows上安装'te