《大数据测试》专题

-

大数据生态

大数据生态fink生态 spark生态 hadoop生态 大数据技术体系与主流技术栈

-

大数据认证

2018年的20个主要的大数据认证 “大数据”一词反映了一个非常实际的增长趋势。到2020年,每个人每秒将产生1.7MB数据。根据调研机构IDC公司的调查,2020年全球数据量将增加到44万亿GB。数以亿计的智能手机和数十亿台物联网(IoT)设备每分钟产生的近300万个Facebook帖子和近300万个视频,每秒约有40,000次谷歌搜索查询。 而大数据认证的数量也在不断增加,尽管不尽相同。这些资

-

腾讯 - 大数据

腾讯 - 大数据投的 Teg 云架构平台,结果被大数据捞了,一面就挂了。 一面 3.28 自我介绍 介绍冷存储项目 介绍阿里tianchi比赛 线程和进程区别,协程和线程区别? 页表实现 如果访问进程地址空间,在page table 中找不到,会发生什么? 做题 输入一串0和1组成的字符串。重新排列这个字符串使得任何一个字符都不是它前面两个字符的和。比如011就不满足,因为0+1=1。 010,110,111都是

-

Zoom 0810数据方向笔试 大数据 2022.8.10

Zoom 0810数据方向笔试 大数据 2022.8.10选择题:25题 考试内容有SQL语句,数据库,spark(包括给你一段spark程序让你输出结果),hive,数学(概率论的一些东西) 编程题:两题 1.算法题:一个数=x平方+y平方+z平方,求有多少质数满足这个条件(具体记不清了,大概是这样) 2.sql题:给你日期和工资,求平均涨薪幅度和平均涨薪时间(思路是使用lead窗口函数,然后两列相减) 总结:第一次考试,选择题花了50分钟,一定要把选

-

大数据面试记录

大数据面试记录#数据人的面试交流地# 1.首先自我介绍,一定要加上自己会啥,自己的优势一定要多说出来 2.简历上写的项目一定要自己做的,如果是网上抄的一定要弄懂才能写出来,要不然容易出现问题 3.写自己的技能一定要写自己弄的比较懂的 4.再来说一下我对大数据的理解,大数据讲究计算和存储,对于存储一定要懂hdfs,hive等等技术,对于计算我建议一定要会spark,flink也要会,你可以不用但要会,spark说

-

大数据平台之数据存储

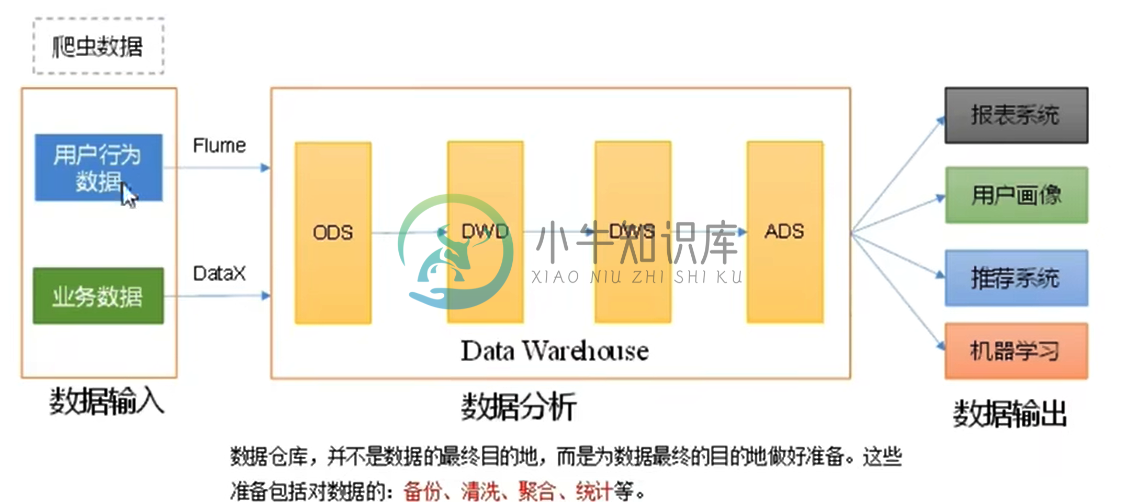

大数据平台之数据存储主要内容:1.大数据生态技术,2.数据存储,3.数据存储的发展,4.数据存储的方式1.大数据生态技术 数据存储处理: 清洗, 关联, 规范化, 组织建模, 通过数据质量的检测, 数据分析然后提供相应的数据服务 离线数仓: 实时数仓: 以Kafka, cancal/Maxwell/FlinkCdc为区分, 离线数仓为Hive, Sqoop 实时数仓:分层: Ods, Dwd, Dim, Dwm, Dws, Ads 离线数仓分层: Ods. Dwd, Dws, Dwt, Ads 实

-

pandas数据框的最大大小

问题内容: 我试图使用s或函数读取稍大的数据集,但我一直遇到s。数据框的最大大小是多少?我的理解是,只要数据适合内存,数据帧就应该可以,这对我来说不是问题。还有什么可能导致内存错误? 就上下文而言,我试图在《2007年消费者金融调查》中阅读ASCII格式(使用)和Stata格式(使用)。该文件的dta大小约为200MB,而ASCII的大小约为1.2GB,在Stata中打开该文件将告诉我,对于22,

-

科大讯飞大数据一面

科大讯飞大数据一面#科大讯飞求职进展汇总##春招# 面试官人很好,还挺帅(有点像shy哥? 全程拷打简历,会重点问实习和2个左右项目 本来我在不断引导面试官问我数据库和机器学习方面的内容,但是面试官好像不怎么想问,连数据怎么清洗的这种都没问,就问了聚类了解那些?k-means聚类怎么优化?肘部法则和肘部加速的区别? 由于我项目大都是deep learning方向的,所以都在让我讲dl方向的东西 还有就是项目遇到了哪

-

数据库单元测试

问题内容: 我希望在编写用于测试某些数据库条目的单元测试中获得一些建议。 如果找不到记录,则我正在测试的功能会将数据库作为种子。 我似乎不太了解如何进行len测试。我正在使用测试数据库,因此我可以在任何时候都对其进行核对,因此,如果我只需要在函数上强制使用一个空的数据库,就没有问题了。 该函数本身可以正常工作,我只想确保已覆盖该函数。 任何建议都很好。 谢谢! 问题答案: 确实取决于您,有很多方法

-

生成测试数据(Generator)

实际运行的时候这个插件是派不上用途的,但这个插件依然是非常重要的插件之一。因为每一个使用 ELK stack 的运维人员都应该清楚一个道理:数据是支持操作的唯一真理(否则你也用不着 ELK)。所以在上线之前,你一定会需要在自己的实际环境中,测试 Logstash 和 Elasticsearch 的性能状况。这时候,这个用来生成测试数据的插件就有用了! 配置示例 input { genera

-

大数据增量PCA

问题内容: 我只是尝试使用sklearn.decomposition中的IncrementalPCA,但它像以前的PCA和RandomizedPCA一样引发了MemoryError。我的问题是,我要加载的矩阵太大,无法放入RAM。现在,它以形状〜(1000000,1000)的数据集形式存储在hdf5数据库中,因此我有1.000.000.000 float32值。我以为IncrementalPCA可

-

大数据集的TFIDF

问题内容: 我有一个大约有800万条新闻文章的语料库,我需要以稀疏矩阵的形式获取它们的TFIDF表示形式。我已经能够使用scikit-learn来实现相对较少的样本数量,但是我相信它不能用于如此庞大的数据集,因为它首先将输入矩阵加载到内存中,这是一个昂贵的过程。 谁知道,对于大型数据集,提取TFIDF向量的最佳方法是什么? 问题答案: Gensim具有高效的tf-idf模型,不需要一次将所有内容存

-

大数据多处理

问题内容: 我用来并行化一些繁重的计算。 目标函数返回大量数据(庞大的列表)。我的RAM用完了。 如果不使用,我只需将生成的元素依次计算出来,就将目标函数更改为生成器。 我了解多处理不支持生成器- 它等待整个输出并立即返回,对吗?没有屈服。有没有一种方法可以使工作人员在数据可用时立即产生数据,而无需在RAM中构造整个结果数组? 简单的例子: 这是Python 2.7。 问题答案: 这听起来像是队列

-

1.5.3.2.16 大数据分析

SuperMap iClient for Leaflet 对接了 SuperMap iServer 的分布式分析服务,为用户提供大数据分析功能,主要包括: 密度分析 点聚合分析 单对象空间查询分析 区域汇总分析 矢量裁剪分析

-

编写大型数据

由于网络的原因,如何有效的写大数据在异步框架是一个特殊的问题。因为写操作是非阻塞的,即便是在数据不能写出时,只是通知 ChannelFuture 完成了。当这种情况发生时,你必须停止写操作或面临内存耗尽的风险。所以写时,会产生大量的数据,我们需要做好准备来处理的这种情况下的缓慢的连接远端导致延迟释放内存的问题你。作为一个例子让我们考虑写一个文件的内容到网络。 在我们的讨论传输(见4.2节)时,我们