《大数据测试》专题

-

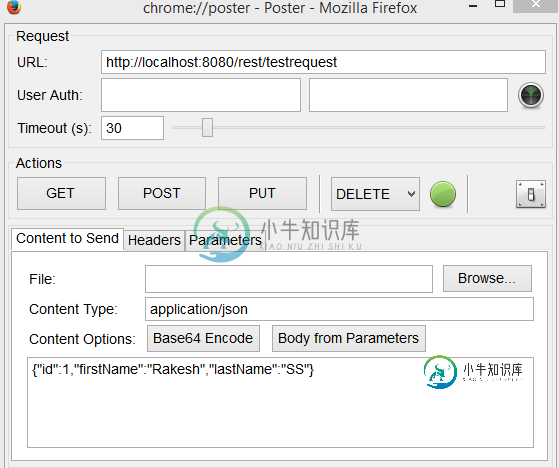

测试SpringREST服务的数据格式

测试SpringREST服务的数据格式我正在测试SpringREST服务,特别是POST方法 以下是我的控制器的代码片段: 员工类别: 我在pom.xml中也包含了jackson库的依赖 pom.xml 当我提交请求时,我的状态为:415不支持的媒体类型 这是我收到的错误消息:服务器拒绝了此请求,因为请求实体的格式不受请求方法的请求资源的支持。 请说明我做错了什么?

-

如何测试Spring数据存储库?

我想要一个在Spring数据的帮助下创建的存储库(例如)。我不熟悉spring-data(但不熟悉spring),我使用本教程。我选择的处理数据库的技术是JPA2.1和Hibernate。问题是我不知道如何为这样的存储库编写单元测试。 让我们以方法为例。由于我正在进行测试--首先,我应该为它编写一个单元测试--这就是我遇到三个问题的地方: > 首先,如何将的模拟注入到不存在的接口实现中?Sprin

-

Spock-使用数据表测试异常

如何使用Spock以良好的方式(例如数据表)测试异常? 示例:具有一个方法,该方法可以抛出不同消息的异常,或者如果用户有效,则不抛出异常。 规范类本身: 变体1 这一个正在运行,但真正的意图被所有的when/then标签和反复调用弄得一团糟。 变式2 这个不工作,因为Spock在编译时提出了这个错误: 异常条件只允许在'然后'块 变式3 这个不工作,因为Spock在编译时提出了这个错误: 异常条件

-

Opentelemetry Java自动测试数据到Jaeger

我是Opentelemetry领域的新手,希望将Spring-petclinic仪器数据发送给在我的远程云系统上运行的Jaeger 下面是bat文件: 当我运行bat文件,准备在浏览器(http://localhost:8080)中打开petclinic应用程序时,在控制台中出现以下错误: 如何解决这一问题?是否有其他依赖项要添加到petclinic pom.xml或代码中?

-

数据库测试计划(Database Test Plan)

在本章中,我们将了解如何创建一个简单的测试计划来测试数据库服务器。 为了我们的测试目的,我们使用MYSQL数据库服务器。 您可以使用任何其他数据库进行测试。 有关MYSQL中的安装和表创建,请参阅MYSQL教程 。 安装MYSQL后,请按照以下步骤设置数据库 - 创建一个名为“tutorial”的数据库。 创建一个表tutorials_tbl 。 将记录插入tutorials_tbl ,如下所示

-

大数据开发面试题之Hive篇

大数据开发面试题之Hive篇hive的架构 hive外部表和内部表的区别 内部表的数据由hive管理,且存储在hive.metastore.warehouse.dir配置下的路径中;外部表的数据由HDFS存储,路径可以自己指定; 删除表时,内部表会把元数据及真实数据删除;外部表不删除真实数据。 你用过hive哪些窗口函数 可参考:面试官:你用过哪些窗口函数 一般用什么文件格式 可参考:面试官:“你们实际生产中hive用什么文

-

字节面试-大数据开发实习

字节面试-大数据开发实习视频ms 前三分钟 自我介绍 数据仓库的了解 怎样设计数据分层 了解的大数据组件 spark用于解决什么问题 spark底层逻辑 sql的join实现方式 举例A(3) join B (5) 有几条数据 join底层逻辑 sql题 查询用户峰值 全程不到30分钟 **我就是一个小菜鸡。问就是面试凉凉 问的其实感觉没有特别难 但就是啥都不会。还是学的太过浅层次。总的来说 项目拷打 底层深挖。G

-

滴滴大数据开发实习面试

滴滴大数据开发实习面试了解大数据吗? 分布式是什么? 1、list、set、map之间的区别与联系 2、arraylist和linkedlist之间的区别与联系 3、数组与链表的区别 4、线程和进程的区别?为什么要设置线程? 5、线程安全如何保证?几种方法?为什么会出现线程不安全 6、线程池用于干啥? 7、同步与异步的概念? SQL相关 1、讲一下索引?索引怎么实现 2、列排序是什么数据结构? 3、B树和B+树的区别?

-

使用相同的测试数据运行所有测试

从excel文件读取测试数据。要求:我想首先我的所有测试应该运行在相同的测试数据,即excel行,然后所有测试与另一行。 解决方案:尝试将@Factory与我的@DataProvider一起使用 问题:如果我在@dataProvider中使用核心值,那么它可以正常工作。但是当从excel动态获取时,如果给我错误:[错误]导致:java.lang.NullPointerException } 基类

-

为什么H2数据库文件大小的增长超过了数据大小

我有一个h2数据库文件,文件大小已经增长到5GB。我删除了一些数据以缩小文件的大小。但即使从数据库中删除了一半记录,文件大小仍然保持不变。 我已经尝试了以下所有选项来减少数据库大小,但没有一个对我有用。 我的连接字符串如下所示: 注: 我们正在结清我们已经开始的交易 文件中没有5GB的数据 有人能给我建议一些解决方法或修复方法来减少我的数据库大小吗

-

Spring数据排序操作超出最大大小

我是相当新的Spring和MongoDB,并有一个问题,从我的MongoDB拉数据。我试图获得相当大的数据量,并收到以下异常: 执行器错误:操作失败:排序操作使用超过最大33554432字节的RAM。添加索引,或指定一个较小的限制。;嵌套异常是com.mongodb.MongoExc0019: Execator错误:操作失败:排序操作使用超过内存的最大33554432字节。添加索引,或指定较小的限

-

Neo4j查找数据库的最大字节大小

我找到了关于如何计算neo4j数据库大小的以下信息:https://neo4j.com/developer/guide-sizing-and-hardware-calculator/#_disk_storage

-

加载大于 h2o 中内存大小的数据

我正在尝试在h2o中加载大于内存大小的数据。 H2o博客提到: 下面是连接到h2o 3.6.0.8的代码: 给 我试着把一个169 MB的csv加载到h2o中。 这抛出了一个错误, 这表示内存溢出错误。 问:如果H2opromise加载大于其内存容量的数据集(如上面的博客引述所说的交换到磁盘机制),这是加载数据的正确方法吗?

-

兴金数金,大数据实习面经

兴金数金,大数据实习面经一,上来就问了项目里日志的处理量,50w 100M左右 二,问项目里如何解决Hbase的热点问题,面试官没听明白,后面就直接问热点问题如何解决的 答的就举年份例子,加盐,预分区 三,Kafka里是如何leader和follow是如何实现同步的 具体怎么实现同步我确实不知道,我就答的是offset在follow和leader挂了后如何在实现同步的,面试官说我似乎说了又没说明白,后面查了一下,下

-

神策数据 测开一面

神策数据 测开一面神策数据 一面 基础 手撕:环形链表找环入口 py基础: list set hash dictionary 自省 形参实参 gil range 网络: tcp udp相关 直播,验证用tcp/udp? 如何用udp达到tcp效果#面经#