《衡泰技术》专题

-

Red Hat Linux,Apache2.0+Weblogic9.2负载均衡集群安装配置

本文向大家介绍Red Hat Linux,Apache2.0+Weblogic9.2负载均衡集群安装配置,包括了Red Hat Linux,Apache2.0+Weblogic9.2负载均衡集群安装配置的使用技巧和注意事项,需要的朋友参考一下 ******************************************************************************

-

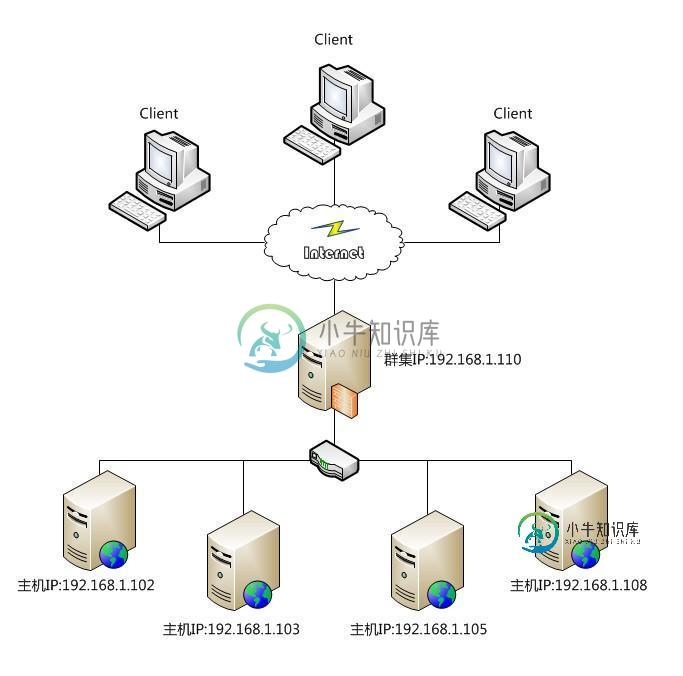

Nginx 负载均衡是什么以及该如何配置

本文向大家介绍Nginx 负载均衡是什么以及该如何配置,包括了Nginx 负载均衡是什么以及该如何配置的使用技巧和注意事项,需要的朋友参考一下 什么是负载均衡 负载均衡主要通过专门的硬件设备或者通过软件算法实现。通过硬件设备实现的负载均衡效果好、效率高、性能稳定,但是成本比较高。通过软件实现的负载均衡主要依赖于均衡算法的选择和程序的健壮性。均衡算法也是多种多样的,常见的有两大类:即静态负载均衡算法

-

历史推送和替换之间的权衡是什么?

问题内容: 我使用历史记录包将无效的URL重定向到我的react组件上的404页面。 我之所以使用而不是因为我不希望浏览器记录我访问过的任何无效URL。 我在这里错过了重点吗?在为我的目的选择一个或另一个之间是否需要权衡? 有人可以向我解释吗?提前致谢 ;) 问题答案: 我认为您的想法正确。 我个人使用无效URL重定向(或不相关,即当登录的用户转到“ / login” URL时重定向到“配置文件”

-

Windows Server 2008 R2 负载平衡安装配置入门篇

Windows Server 2008 R2 负载平衡安装配置入门篇本文向大家介绍Windows Server 2008 R2 负载平衡安装配置入门篇,包括了Windows Server 2008 R2 负载平衡安装配置入门篇的使用技巧和注意事项,需要的朋友参考一下 一、简单介绍负载均衡 负载均衡也称负载共享,它是指负载均衡是指通过对系统负载情况进行动态调整,把负荷分摊到多个操作节点上执行,以减少系统中因各个节点负载不均衡所造成的影响,从而提高系统的工作效率。 在

-

详解Nginx HTTP负载均衡和反向代理配置

本文向大家介绍详解Nginx HTTP负载均衡和反向代理配置,包括了详解Nginx HTTP负载均衡和反向代理配置的使用技巧和注意事项,需要的朋友参考一下 当前大并发的网站基本都采用了Nginx来做代理服务器,并且做缓存,来扛住大并发。先前也用nginx配置过简单的代理,今天有时间把整合过程拿出来和大家分享,不过其中大部分也是网上找来的资源。 nginx完整的反向代理代码如下所示 : 通过上述所

-

Nginx与Tomcat实现动静态分离和负载均衡

Nginx与Tomcat实现动静态分离和负载均衡本文向大家介绍Nginx与Tomcat实现动静态分离和负载均衡,包括了Nginx与Tomcat实现动静态分离和负载均衡的使用技巧和注意事项,需要的朋友参考一下 本文介绍了Nginx与Tomcat实现动静态分离和负载均衡,所谓动静分离就是通过nginx(或apache等)来处理用户端请求的图片、html等静态的文件,tomcat(或weblogic)处理jsp、do等动态文件,从而达到动静页面访问时

-

Azure Kubernetes-具有Https服务的内部负载平衡器?

我已经在AKS上部署了我的kubernetes应用程序,它使用内部负载均衡器,而没有单独的入口控制器。 目前该服务可以使用超文本传输协议访问,我想保护该服务。如何启用https以及应在何处安装证书?

-

负载平衡我的kubernetes集群中的外部服务

我安装了一个kubernetes集群。我想为我的一个微服务使用外部数据库(在我的集群之外),但这个外部数据库被设置为集群,没有自己的负载均衡器。 有没有办法创建一个内部负载平衡器服务,让kubernetes始终将微服务定向到正在运行的实例? 我看到您可以设置loadbalancer类型的服务,我如何使用它?我尝试创建它,但我看到loadbalancer服务是用NodePort创建的。它可以在没有节

-

AWS Kubernetes:在AWS负载平衡器上选择SSL证书

我正在尝试为我的AWS EKS群集的AWS负载平衡器配置SSL。负载平衡器正在代理我的群集上运行的Traefik实例。这在HTTP上运行良好。 然后,我在Cert Manager中创建了我的AWS证书,复制了ARN并遵循了文档的这一部分:服务-Kubernetes 但是证书没有链接到AWS负载平衡器中的侦听器。我在网上找不到更多的文档或工作示例。有人能给我指出一个吗? LoadBalancer配置

-

名称kubernete生成的Google云入口负载均衡器

我有多个kubernetes集群,它们具有Google驱动的负载均衡器(入口磅)。 因此,现在要访问我的k8s群集服务,我只需ping$kubectl get服务提供的公共IP,酷。 我的问题是,有时我需要拆除/创建集群,重新配置服务,这些服务可能很快也需要SSL证书,我的集群/服务构建也需要易于复制(对于云开发人员!)。 问题很简单:我可以拥有入口负载均衡器IP而不是入口负载均衡器主机名吗? 类

-

带有外部服务器的Google云负载均衡器

我想知道是否有可能将Google云负载平衡器链接到一个外部服务器——一个托管在Google云之外的服务器? 因此,负载均衡器可能会链接到Google Cloud实例,但也可能链接到外部服务器。

-

从其他区域访问GCP内部负载平衡器

我需要从另一个GCP区域访问运行在GKE Nginx入口服务上的内部应用程序,该服务运行在内部负载均衡器上。 我完全知道,直接使用谷歌网络是不可能的,这是一个巨大的限制(GCP功能请求)。 通过AWS的VPN隧道可以很好地访问内部负载平衡器,但我不确定在同一网络下的GCP区域之间创建这样的隧道是一个好主意。 欢迎变通方法!

-

GCE负载平衡器后面的Kubernetes(GCE/GKE)上的Traefik

我已经按照用户指南在库伯内特斯上实现了Traefik。这给了我一个入口控制器,我能够在80和8080上创建一个入口和traefik-ingress-service监听。 我还设置了“gce”入口: 这样做的目的是创建一个GCE负载平衡器,它终止我的TLS,并将所有请求转发给NodePort类型的traefik入口服务。 GCE负载平衡器需要进行健康检查。默认为路径“/”。我以为traefik有个“

-

创建没有GCP负载平衡器的kubernetes nginx入口

所以我正在使用库伯内特斯作为一个辅助项目,它很棒。运行像我这样的小项目更便宜(一个3-5个实例的小集群基本上为我提供了大约30美元/月的GCP所需的一切)。 我唯一努力的领域是尝试使用kubernetes入口资源映射到集群并扇出到我的微服务(它们是小型Go或节点后端)。我有入口映射到不同服务的配置设置,没有问题。 我知道,在创建入口资源时,您可以很容易地让GCP启动负载平衡器。这很好,但这也意味着

-

具有负载平衡和提交功能的微服务

我热衷于了解微服务的以下几个方面。 > 提交和回滚。如果要通过调用多个微服务来实现业务目标,谁来协调提交和回滚?微服务是否需要在其实现中嵌入提交-回滚协议?或者,它是由某种外部因素提供的? 微服务的负载平衡。一个微服务是由负载均衡器前置来帮助它扩展的吗?因此,扩展是否超出了服务的实现范围? 与AWS Lambda/Bluemix OpenWhisk/Azure函数相关。微服务与“无服务器”架构相比