《APUS-独角兽》专题

-

独立栅格层中的随机森林类概率

我正在使用randomForest包对不同预测值的光栅堆栈进行分类。分类工作正常,但我还想检索类概率。对于我的代码,我只得到一个具有第一个类概率的RasterLayer,但我希望得到一个具有一个层中每个类的类概率的RasterStack。

-

kafka 可以脱离 zookeeper 单独使用吗?为什么?

本文向大家介绍kafka 可以脱离 zookeeper 单独使用吗?为什么?相关面试题,主要包含被问及kafka 可以脱离 zookeeper 单独使用吗?为什么?时的应答技巧和注意事项,需要的朋友参考一下 kafka 不能脱离 zookeeper 单独使用,因为 kafka 使用 zookeeper 管理和协调 kafka 的节点服务器。

-

独立应用程序Winforms使用哪个数据库

问题内容: 我需要使用Visual Studio在WinForms中开发一个简单的会计应用程序,例如客户,供应商和会计资料(借方/贷方)等。 我从未开发过使用数据库的独立应用程序,我总是开发过服务器端应用程序(现有的SQL Server等)… 我喜欢用DB开发一个独立的应用程序。我的意思是:创建一个安装项目(setup.exe / setup.msi)并发送给客户,他/她应在Windows pc上

-

如何在单独的camel上下文中模拟camelendpoint

我正在为一个向最终用户隐藏骆驼业务的库编写测试用例。该库公开了sendMessages()等方法,并在内部使用ProducerTemplate将消息发送到一个骆驼路由,在该路由中将消息聚合并最终发送到目的地。 我希望能够编写调用library方法的测试,并模拟骆驼路由endpoint,以便稍后对其进行断言。 如果我使用CamelSpringTestSupport,它基本上会创建一个新的类PathX

-

如何在单独的组件中使用url参数

在过去的两天里,我一直在学习React,我在理解URL参数方面遇到了困难。 假设我想要一个路由。路线的定义如下: 现在我希望在另一个文件中定义的对象能够使用值。我该怎么做?我已经找到了关于路由url参数的教程,但没有一个解释如何实现这一点。 下面是我的视图现在的样子: 在哪里可以获得详细信息中的?我试过: 但是,未定义。

-

编写单独的JSON条目Python时遇到问题

希望有人能告诉我为什么会这样。我这里有三部电影,我试图系统地获取每一部电影的JSON数据,并将其打印到一个单独的文件中,名为data\u fetch。txt。我正在使用的站点是omdbapi。通用域名格式。我能够成功地获得所有电影的JSON,但由于一些奇怪的原因,当它被编写时,它被编写成一个条目。因此,当我打开我刚刚编写的文件并对条目进行计数时,计数器只会在应该有3个单独条目的情况下吐出1个条目。

-

将单独的“double”值转换为ArrayList中的数组

我创建了一个程序,其中包含一个ArrayList,其中包含学生成绩的单独“双”值。然而,本课程要求创建一个分数整数数组,而不是我之前使用的单独值。 我的学生类代码(我已经删除了不相关的代码,开门见山): 名册等级: 我已经将分隔的值(Grade1、Grade2、Grade3)更改为“int[]Grades”数组,修改了构造函数,并添加了setter和getter。所以,我认为学生班很好,然而花名册

-

调试独立的Spring启动应用程序(Intellij IDEA)

我正在使用Intellij IDEA 14.1,并试图调试最基本的独立Spring Boot 1.2.5应用程序。有人能告诉我怎么做吗? 我读过http://docs.spring.io/autorepo/docs/spring-boot/1.2.5.RELEASE/maven-plugin/usage.html但并没有成功地使其发挥作用。最简单的方法是禁用Spring Boot在调试时使用的分叉

-

数独检查器:在C中访问3x3子网格

我已经创建了一个程序,允许用户输入一个数独拼图的所有值,即9x9,将这些值存储在一个数组中,并可以检查所有行和列中的值是否不同,但我很难理解如何实现代码来关注3x3的每个子网格。我想我必须有最后一个嵌套for循环,它可能被3除,但我完全被这部分卡住了。 }

-

elasticsearch kibana在单独的aws ec2服务器中设置

我在一个实例中安装了elasticsearch,在另一个实例中安装了kibana。这两个服务都在运行,我可以使用curl将elasticsearch及其实例公共ip连接到端口9200版本:7.9.2都假设:公共ip elasticsearch-x.x.x kibana-y.y.y 问题:无法将kibana实例与其curl和公共ip连接到端口5601错误:无法连接到y.y.y.y端口5601:连接被

-

Eclipselink JPA 3.0和独立数据库的连接错误

我被要求将大型独立Swing应用程序的数据库连接JAR从Eclipselink JPA 2.0迁移到Eclipselink JPA 3.0实现。 我看到一个很大的不同:Eclipselink 3.0使用雅加达。现在我所要做的就是连接到数据库,但到目前为止我一直没有成功,我不知道为什么。这是我的测试课: 当我运行这个时,我得到了这个异常。 异常告诉我我的persistence.xml或我正在使用的j

-

在单独的docker组合文件之间共享卷

我试图允许nginx在多个容器之间代理,同时访问这些容器中的静态文件。 若要在使用docker compose创建的容器之间共享卷,请执行以下操作: 然而,我实际需要的是nginx compose文件在一个单独的文件中,也在一个完全不同的文件夹中。换句话说,命令将单独运行。我尝试了以下方法: 此处正确找到的一个工作是将nginx容器静态文件卷改为如下所示: 上面的方法是正确的,但是它看起来是“刺耳

-

为什么Jedis中set()的nxxx参数是独占的?

在绝地武士中,我想通过一次调用来设置一些键和值,以及过期时间。 我可以通过set()和expire()的组合来实现这一点,但它需要两个调用。 我找到了以下方法: 设置(最终字符串键、最终字符串值、最终字符串nxxx、最终字符串expx、最终长时间) 但我必须选择nx(仅当它不存在时才设置键)或xx(仅当密钥已存在时设置)。 我想涵盖这两种情况。 有什么建议吗?或者有什么理由这样写?

-

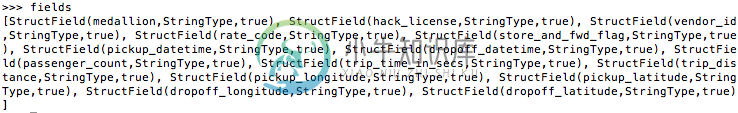

如何让Spark output在单独的新行上打印?

如何让Spark output在单独的新行上打印?目前,我的spark console打印如下,可读性不强: 我希望它在新行上打印每个结构字段项目,以便更容易阅读。我该怎么办?谢谢。 更新:我实际上在学习本教程(http://www.nodalpoint.com/spark-data-frames-from-csv-files-handling-headers-column-types/),作者可以逐行打印,无需pprint。我想知道他/她是怎么

-

无法在独立模式下启动keycloak服务器

提前致谢