《2022毕业即失业取暖地》专题

-

美团业务运营管理岗面经(一面-业务面)

美团业务运营管理岗面经(一面-业务面)投递岗位:业务管理运营岗 个人情况:1段银行投行部+1段审计+1段咨询+1段互联网 实习 笔试情况:全部行测题,无主观问答题,难度适中,可以通过多刷题来准备 面试情况:30分钟左右 面试问题汇总: 1. 自我介绍 2. 挖深了咨询公司的实习经历,包括工作内容、团队中的角色、所经历的项目等 3. 从现在来看,为什么XX产品当时有这样的市场表现 4. 咨询公司的实习中是否有和其他成员发生意见分歧的情况

-

Cron作业无法读取以前的Cron日志

为了检测cron作业中可能发生的故障,我设置了另一个cron作业来检查crontab发出的上一个日志: 手动运行时,一切正常: 剧本是这样写的 Crontab: 但当使用crontab运行时,日志读取为空。我错过了什么?

-

writer中的Spring批处理读取作业参数

我当前正在命令行中传递文件名在spring批处理作业中的参数并运行我的作业,spring批处理作业将查找文件并读取、处理和写入该文件。我目前在读取器中的作业参数文件名和读取器文件名,如何才能在处理器和写入器中使用相同的作业参数文件名。

-

运行独家导入作业时获取错误

我正试图使用scoop将数据从MySQL数据库导入到hdfs中,但我得到了“没有为ClassWriter生成的列”错误。 下面是我的独家命令: 下面是错误堆栈: 20/03/08 16:11:27错误Manager.SqlManager:执行com.mysql.jdbc.exceptions.jdbc4.CommunicationsException语句时出错:通信链接失败 最后一个成功发送到服务

-

Spring批处理:不能用不同的作业参数启动作业,也不能访问作业参数

我得和Spring批处理问题。都与通过命令行传入的JobParameters有关。 第一期: 为了从JobParameters获取路径,我使用BeforeStep注释加载JobParameters并将它们复制到局部变量上。不幸的是,这不起作用。变量将为并且执行失败,因为文件无法打开。 如何访问读取器中的作业参数?我想将文件路径作为命令行参数传入,然后读取这个文件。

-

在Jenkins作业的另一个Jenkins实例上运行Jenkins作业

问题内容: 我想创建一个Jenkins作业来启动其他Jenkins作业。那将非常容易,因为Jenkins模板项目插件允许我们创建一个类型为“使用来自另一个项目的构建器”的构建步骤。但是,使我的情况更难的是,我必须在其他计算机上开始Jenkins的工作。有什么标准方法可以做到吗? 问题答案: 万一您只想触发Job的新版本,您有多种方法可以完成它 您可以使用远程访问API并触发请求以从源Job构建目标

-

如何使用Jenkins DSL为所有作业设置作业超时

问题内容: 我阅读了如何使用Jenkins DSL设置作业超时。设置一项作业的超时时间。我想为所有作业设置它,并且设置略有不同:150%,平均超过10个作业,最多30分钟。 根据相关的job-dsl-plugin文档,我应该使用以下语法: 我在http://job-dsl.herokuapp.com/中进行了测试,这是相关的XML部分: 我使用之前手动编辑过的作业进行了验证,并且XML是正确的。因

-

Hadoop调度作业按顺序运行(一个接一个作业)?

假设我在Hadoop环境中资源有限,我不想安排长时间运行的作业(即需要几天时间才能完成)。我正在分析大量过去的时间序列数据。我想安排一次需要一天数据的mapreduce作业(这需要一个小时来处理)。 那么,我如何安排,使新的工作提交后,前一个工作完成?

-

加载Jenkins作业配置页面很慢,没有运行作业

目前,当我们试图打开Jenkins配置页面时,大约需要45秒,而对于其他页面,如请求作业视图或查看控制台输出,则不到3秒。根据线程转储分析结果,我们得到了一个CPU“峰值”,描述为 "您的应用程序可能受到高CPU的困扰。"查看线程报告,我们没有看到任何阻塞状态,但有一个可疑状态:"1个线程是无限循环:DestRoyJavaVM" 不幸的是,我们无法确定这种高CPU的原因,可能还有相关的无限循环。

-

快手平台产品商业化-产品经理(数据业务)

快手平台产品商业化-产品经理(数据业务)1.自我介绍 2. 深挖实习经历 3. 第一个问题就是关于数据分析相关的工作,工作内容,数据报表的形式 4. 需求是基于什么提出的?之前实习中PRD需求前的调研以及分析工作都如何做的?什么流程什么形势 5. 与数据产品合作时候,如何做的项目,你的主要工作是什么? 6. 需求上线后会不会复盘业务的数据? 7. 你的职业偏向:两个track 功能产品和数据产品 8. 原型图画得怎么样,sql hive

-

使用BigQuery API执行python插入作业时登录失败

我试图通过设置服务器身份验证将本地文件加载到bigquery。我已经完成了以下步骤 > gcloud auth激活服务帐户命令 使用登录 gcloud身份验证登录 正在尝试执行python脚本以将文件上载到BigQuery 范围= 结果是 但我有足够的权限创建查询作业 我错过了什么?我以为我已经登录了。

-

云数据流中失败的作业:启用数据流API

我当前正尝试将Dataflow与pub/sub一起使用,但出现以下错误: 工作流失败。原因:(6E74E8516C0638CA):刷新凭据时出现问题。请检查:1。已为项目启用Dataflow API。2.您的项目有一个机器人服务帐户:service-[project number]@dataflow-service-producer-prod.iam.gserviceAccount.com应该可以

-

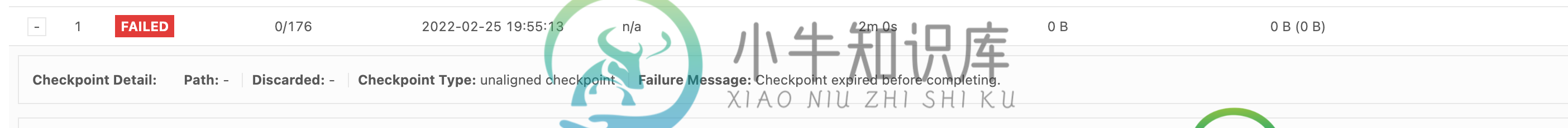

Flink流作业中的检查点设置失败(表/Sql Api)

Flink流作业中的检查点设置失败(表/Sql Api)我的工作流程工作原理如下: src[Kafka]- 但我的工作是运行精细的数据完美地流向Kafka和MySQL,但它在检查点失败,附加图像相同。 Ps :目前我已经禁用了检查点,但是当我使用相同的属性启用时,它会失败

-

Google Cloud Dataproc最后阶段作业失败引发的火花

我在Dataproc上使用Spark集群,但我的作业在处理结束时失败了。 我的数据源是Google Cloud Storage上csv格式的文本日志文件(总量为3.5TB,5000个文件)。 处理逻辑如下: 将文件读到DataFrame(模式[“timestamp”,“message”]); 将所有邮件分组到1秒的窗口中; 对每个分组消息应用管道[tokenizer->HashingTF]以提取单

-

如何在Talend中自动重新运行失败的作业?

如果一段时间后出现故障,是否有办法自动重新运行作业(例如:当连接失败时,在10分钟后重试一次)?我搜索了互联网,但我确实找到了任何结构化的解决方案,我真的被这个问题困住了。 这在塔伦德是可以实现的吗?如果是,要使用的组件是什么,以什么顺序?提前谢谢你。