《Keep内推》专题

-

Oracle LOB未内联存储

设置 我有一个oracle表,它有两个属性和一个CLOB数据类型。下面的表是我用两种方法创建的,每种方法都应该给出相同的行为。 情景 null 问题 LOB表浪费了大量的磁盘空间,因为块大小是8KB,每个块的数据总是在3-4K字符左右,在某些情况下甚至超过这个字符。因此,每行必须浪费4KB的空间,在20兆行以外的情况下,它在50兆行的GBs中运行

-

Spark vs Flink内存不足

我已经建立了一个Spark and Flink k-means应用程序。我的测试用例是一个3节点集群上的100万个点的集群。 当内存瓶颈开始时,Flink开始外包给磁盘,工作缓慢,但工作正常。然而,如果内存已满,Spark将失去执行器,并再次启动(无限循环?)。 我尝试在邮件列表的帮助下自定义内存设置,谢谢。但是火花仍然不起作用。 是否需要设置任何配置?我是说Flink的记忆力很差,斯帕克也必须能

-

HttpResponseMessageStringContent替换消息内容

我试图用HttpResponseMessage返回一个错误消息,但我得到的是我假定的< code>StringContent。ToString()。这是我的代码: 错误状态代码类似于401、404等。消息是纯文本的,如“照片未找到”或“错误的参数”。我的期望是,当出现错误时,用状态代码(401等)进行响应。)和一条纯文本错误消息。我收到的是HTML格式的响应,状态代码为200,内容如下: Stat

-

nodejs内存分配失败

-

Javafx中GridPane内部的HBox

-

-

mvn java:exec增加了内存

我使用“mvn exec:java”运行我的程序: 我没有找到更改JVM的最大内存分配。 我试过-Dexec.commandlineArgs="..."但那不起作用...

-

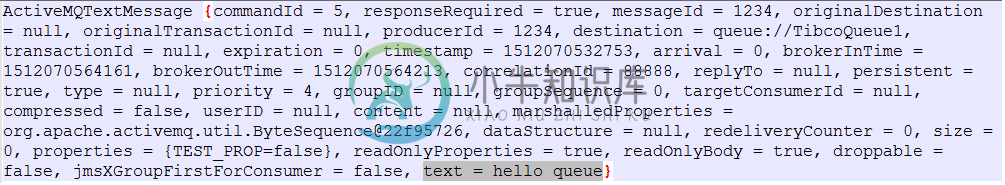

提取jms文本内容

提取jms文本内容 -

Spark 1.4增加maxResultSize内存

我正在使用Spark1.4进行研究,并与内存设置进行斗争。我的机器有16GB内存,所以没有问题,因为我的文件只有300MB。但是,当我试图使用函数将Spark RDD转换为panda dataframe时,我收到以下错误: 我试图修复这个问题,更改了spark-config文件,但仍然得到相同的错误。我听说这是Spark1.4的一个问题,不知道您是否知道如何解决这个问题。任何帮助都是非常感谢的。

-

访问内部微服务

我有两个不同的微服务,将尤里卡作为服务注册表,现在我正在尝试从另一个微服务调用微服务,解析带有功能区的endpoint以进行客户端负载平衡。 服务A: 此服务公开一个终结点,并且应用程序.yml 如下所示: 调用服务A的服务B具有以下应用程序类: 控制器 服务 但我在尝试访问服务时遇到了一个异常: 对此有什么建议吗?

-

监视java本地内存

我们正在监视jvm指标,如堆、元数据库、线程和gc计数,我们能够将这些指标推送到像Prometheus一样的monitorng服务器。类似地,我们希望跟踪Java本地内存指标(jcmd vm.sumary的输出)。我的问题是,是否可以通过调用任何jvm运行时类来获得这些度量?

-

Thymeleaf, Javascript内联和迭代

使用SpringMVC和Thymeleaf,我正在构建一个包含一些javascript的html视图。 在页面中,th: each与迭代值一起使用,为一组按钮提供唯一的超文本标记语言id。 我的问题出现在尝试生成javascript时,该javascript将对每个按钮id使用jQuery引用。 在另一种视图解析语言中,我会使用代码: (以上可能不是100%语法正确,但我希望你明白——我试图做的是

-

应用内计费v3 NullPointerException

为了测试Android应用内计费v3,我实现了一个对话框,其中添加了一个选项适配器。我添加了测试SKU,“Android.测试.购买”,“Android.测试.取消”,“Android.测试.退款”,“Android.测试.项目不可用”。 当我使用该对话框启动购买流时,一切正常,我能够购买该商品,并且该商品是绝对购买的。然而,当我的应用程序尝试刷新UI时,我会收到一个nullpointerexce

-

动态应用内购买

这个问题(Android应用内计费动态产品列表)是3年前问过的。动态的应用内购买项目在Android上还是不可用的吗? 我之所以要实现这种功能,是因为我的应用程序提供了一种让某些用户创建自己的应用内购买的方式,供其他人购买。

-

Kafka内部数据管理

有人能帮我理解在以下情况下会发生什么吗: 来自主题A的流在其上执行了一些不同的操作,这些操作会导致生成多个内部Kafka主题,例如:KSTREAM-REDUCE-00000000 14 KSTREAM-JOIN-0000000 358等。 它们在拓扑中显示为“消费者组名生成的名称” 话题A加入话题B。。。B必须重新输入才能与A加入内部主题“组重新输入B”。 如果我的拓扑结构发生变化,那么除非所有这

-

Spark内部工作原理

我知道Spark可以使用Scala、Python和Java来操作。另外,RDDs用于存储数据。 但是请解释一下,Spark的架构是什么,内部是如何工作的。