《同花顺面试》专题

-

雪花ODBC和变体数据类型

使用odbctest和Snowflake 64位ODBC驱动程序for Windows: 这是odbc跟踪的相关部分: sqdrsvc 3dfc-52bc输入SQLPrepare HSTMT 0x000000435c961620 UCHAR*0x000000435d262720[140]“插入”sfdest“.”qauser“.”bt14726“(”varchar_10_col“,”varchar

-

雪花动态过程statement.execute()返回值

创建过程GetLastUpdateDate()以$$的形式返回布尔语言javascript

-

火花:将多列分解成一列

是否有可能在火花中将多个列爆炸成一个新列?我有一个如下所示的数据框: 期望输出: 到目前为止,我尝试过: 这不起作用。非常感谢您的任何建议。

-

火花 Scala UDF 中的异常处理

我目前正在使用上面的UDF将一列字符串解析成一个键和值的数组。“50:63.25,100:58.38”到[[50,63.2],[100,58.38]]。在某些情况下,字符串是“\N”,我无法解析列值。如果字符串是“\N”,那么我应该返回一个空数组。有人能帮我处理这个异常或帮我添加一个新的案例吗?我是spark-scala的新手。 错误:scala.MatchError:[Ljava.lang.St

-

UDF 中的异常处理:火花 1.6

这个函数的作用是将字符串列解析为键和值的数组。""to。这是我的UDF,它创建了一个包装的int和Double结构元素数组。 有些情况下,输入字符串的格式不正确,我会得到一个错误:输入字符串的< code > Java . lang . numberformatexception :因为“< code>k.trim.toInt”无法转换像“< code>.01-4.1293”这样的脏数据,这是一个

-

火花结块中的累积函数

火花结块中的累积函数我尝试过用这个方法来计算累积值,但是如果日期字段与累积字段中的值相同,那么有人能提出类似于这个问题的解决方案吗

-

Sparklyr:直接转换为拼花地板

-

阿帕奇火花移动平均线

-

按模式划分的雪花子串

我需要一个动态的方式只提取123456从这些字符串。你能提出一个解决办法吗。

-

未解析依赖关系火花库

当我试图用Intellij编译我的项目时,sbt正在抱怨未解决的依赖项 [Warn]===public:已尝试[Warn]https://repol.maven.org/maven2/org/apache/spark/spark-core/2.1.1/spark-core-2.1.1.pom[Warn]未解析的依赖关系路径:org.apache.spark:spark-core:2.1.1 我的s

-

雪花中时间戳转换错误

-

《雪花》中无限与楠的处理

我正在将数据仓库前端从Hadoop后端转换为雪花后端,我需要将其每个SQL函数转换为雪花等效函数。我遇到的一个麻烦是处理产生无穷大/-无穷大或NaN(不是一个数字)的公式。 在Hadoop中,这是一个使用IS_INF和is_nan检查公式的简单问题。在SQL Server(我们测试的另一个后端)中,这可以使用SET ARITHABORT off/SET ANSI_WARNINGS off来完成。H

-

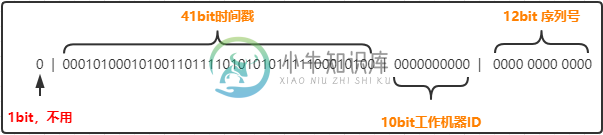

分布式Id 雪花算法原理

分布式Id 雪花算法原理分布式ID常见生成策略 分布式ID生成策略常见的有如下几种: 数据库自增ID。 UUID生成。 Redis的原子自增方式。 数据库水平拆分,设置初始值和相同的自增步长。 批量申请自增ID。 雪花算法。 百度UidGenerator算法(基于雪花算法实现自定义时间戳)。 美团Leaf算法(依赖于数据库,ZK)。 其核心思想就是:使用一个 64 bit 的 long 型的数字作为全局唯一 id。在分布

-

花田在线邮件群发系统

花田在线邮件群发系统采用javaMail编写的一个在线邮件群发系统,有效的解决一般企业群发邮件给客户的难题。QQ:839160526 链接:http://pan.baidu.com/s/1dzcM 密码:56gj

-

如何控制JAXB内存中架构生成的顺序/顺序?

问题内容: 我有3个相互依赖的xsd文件来构建我的元素定义。每个xsd文件都有其自己的名称空间。当我使用JAXB xjc生成类时,得到3个相应的包。到目前为止,一切都很好。 当我想使用解组器进行架构验证时,就会出现我的问题。为了避免不得不读取xsd文件,我从被解组的相关类中动态生成了模式。但是,由于该类依赖于其他2个包中的对象,因此除非我指定所有3个包,否则它无法生成架构。这已经不是一个非常实用的