Spark:增加任务/分区的数量

Spark中的任务数由阶段开始时的RDD分区总数决定。例如,当Spark应用程序从HDFS读取数据时,Hadoop RDD的分区方法继承自MapReduce中的FileInputFormat,它受HDFS块的大小、Mapred.min.split.size的值和压缩方法等的影响。

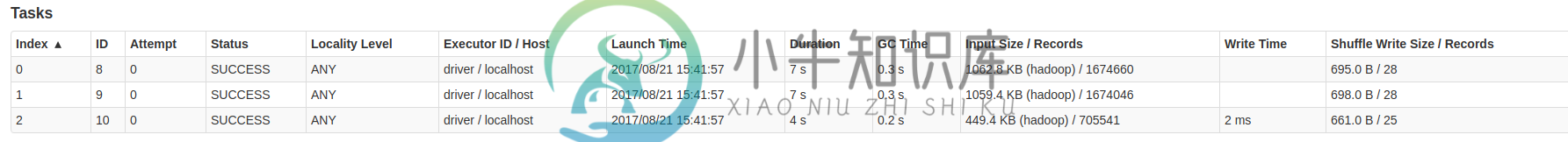

截图中的任务花了7,7,4秒,我想让它们平衡。另外,阶段被分成3个任务,有什么方法可以指定Spark的分区/任务数吗?

共有1个答案

任务依赖于分区。您可以为RDD设置分区器,在分区器中您可以设置分区的数量。

-

在减少分区数量时,可以使用coalesce,这很好,因为它不会引起混乱,而且似乎可以立即工作(不需要额外的作业阶段)。 有时我想做相反的事情,但重新分区会导致混乱。我想几个月前,我实际上通过使用balanceSlack=1.0的CoalescedRDD实现了这一点-所以会发生的是,它会分割一个分区,从而得到所有分区都位于同一节点上的分区位置(如此小的网络IO)。 这种功能在Hadoop中是自动的,

-

我试图理解和之间的区别。 如果我正确理解了这个答案,只能减少dataframe的分区数量,如果我们尝试增加分区数量,那么分区数量将保持不变。 但当我试图执行下面的代码时,我发现了两件事 对于合并的Dataframe,可以增加分区数 对于Rdd,如果Shuffle=false,那么分区的数量不能随着合并而增加。 这是否意味着使用合并数据帧分区可以增加? 当我执行以下代码时: 我得到以下输出 当我执行

-

我在尝试将DF转换为RDD时遇到了一个问题。这个过程中的一个阶段总共使用了200个任务,而在此之前的大多数部分使用了更多的任务,我很难理解它为什么使用这个数字,以及我是否需要找到一种方法来提高性能。 该程序使用 Spark 版本 2.1.0,并在我使用 250 个执行器的 Yarn 集群上运行。 这些是将DF转换为RDD的行: 这导致了前面提到的200个任务,如以下屏幕截图中的活动阶段所示。 它基

-

我对Spark相当陌生,所以也许我只是错过或误解了一些基本的东西。如有任何帮助,不胜感激。

-

假设我正在从S3文件夹中读取100个文件。每个文件的大小为10 MB。当我执行<code>df=spark.read时。parquet(s3路径),文件(或更确切地说分区)如何在任务之间分布?E、 g.在这种情况下,<code>df</code>将有100个分区,如果spark有10个任务正在运行以将该文件夹的内容读取到数据帧中,那么这些分区是如何分配给这10个任务的?它是以循环方式进行的,还是每