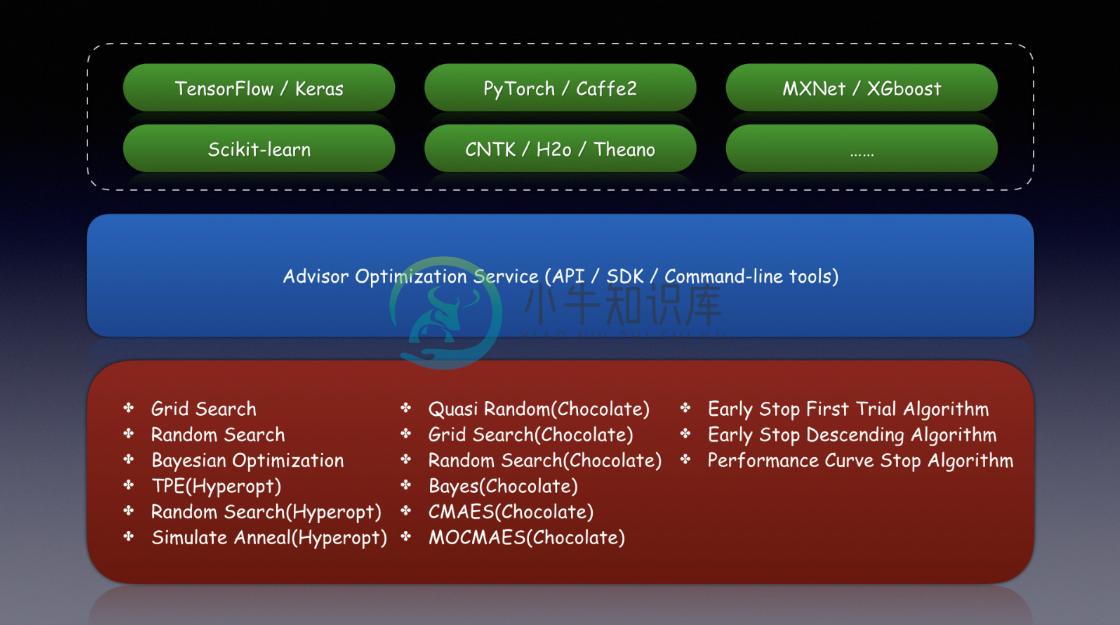

Advisor是用于黑盒优化的超参数调整系统。它是具有这些功能的Google Vizier的开源实现。

-

易于使用API,SDK,WEB和CLI

-

支持研究和试验的抽象

-

包括搜索和早期停止算法

-

用经过训练的模型推荐参数

-

与Google Vizier相同的编程接口

-

命令行工具就像Microsoft NNI一样。

支持的算法

[x]网格搜索

[x]随机搜索

[x]贝叶斯优化

[x] TPE(Hyperopt)

[x]随机搜索(Hyperopt)

[x]模拟退火(Hyperopt)

[x]准随机(巧克力色)

[x]网格搜索(巧克力)

[x]随机搜索(巧克力)

[x]贝叶斯(巧克力)

[x] CMAES(巧克力)

[x] MOCMAES(巧克力色)

[] SMAC算法

[x]早期停止初审算法

[x]早期停止下降算法

[]性能曲线停止算法

-

问题内容: 我之前曾使用Scikit-learn的GridSearchCV优化模型的超参数,但只是想知道是否存在类似的工具来优化Tensorflow的超参数(例如 历元数,学习率,滑动窗口大小等 )。 如果没有,如何实现有效运行所有不同组合的代码段? 问题答案: 使用Tensorflow进行网格搜索的另一个可行的(已记录)选项是Ray Tune 。它是用于超参数调整的可扩展框架,专门用于深度学习/

-

问题内容: 与默认参数相比,我需要Oracle Hotspot 更快地引发异常。 默认情况下,当超过98%的时间用于GC并且少于2%的堆被恢复时,就会发生OOME(描述为http://www.oracle.com/technetwork/java/javase/gc- tuning-6 -140523.html#par_gc.oom )。 例如,当20%以上的时间用于GC时,我需要JVM抛出OOM

-

校验者: @想和太阳肩并肩 翻译者: @\SRY/ 超参数,即不直接在估计器内学习的参数。在 scikit-learn 包中,它们作为估计器类中构造函数的参数进行传递。典型的例子有:用于支持向量分类器的 C 、kernel 和 gamma ,用于Lasso的 alpha 等。 搜索超参数空间以便获得最好 交叉验证 分数的方法是可能的而且是值得提倡的。 通过这种方式,构造估计器时被提供的任何参数或许

-

我有一个包含两个分支的神经网络。一个分支接受卷积神经网络的输入。另一个分支是一个完全连接的层。我合并这两个分支,然后使用softmax获得输出。我不能使用顺序模型,因为它已被弃用,因此必须使用函数式API。我想调整卷积神经网络分支的超参数。例如,我想弄清楚我应该使用多少卷积层。如果是顺序模型,我会使用for循环,但由于我使用的是函数式API,我真的不能这样做。我已经附加了我的代码。有人能告诉我如何

-

8.4. Spring里的advisor(Advisor) API 在Spring里,一个advisor是一个仅仅包含一个通知对象和与之关联的切入点表达式的切面。 除了引入这种特殊形式,任何advisor都可以和任何通知一起工作。 org.springframework.aop.support.DefaultPointcutAdvisor是最常用的advisor类。例如,它可以和: MethodI

-

简介 超参数自动调优是Xiaomi Cloud-ML的功能,可以一次定义多组超参数组合,提交后并行进行训练,并返回效果最优的超参数组合。 代码规范 用户可自定义“效果最优”的指标,需要在TensorFlow模型代码中把指标写到 training/hptuning/metric 中,如下。 tf.summary.scalar("training/hptuning/metric", loss) 使用