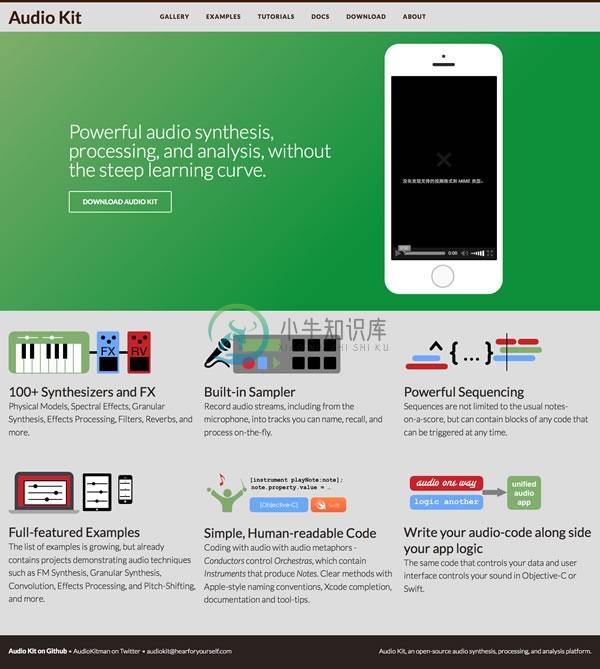

AudioKit 是一个开源的强大的音频合成、处理和分析库。用于 iPhone/OS X 应用的开发,支持 Objective-C 和 Swift 语言。

示例代码:

#import "NewInstrument.h"

@implementation NewInstrument

- (instancetype)init

{

self = [super init];

if (self) {

AKSineTable *sineTable = [[AKSineTable alloc] init];

[self addFTable:sineTable];

AKFMOscillator *fmOscillator;

fmOscillator = [[AKFMOscillator alloc] initWithFTable:sineTable

baseFrequency:akp(440)

carrierMultiplier:akp(1)

modulatingMultiplier:akp(0.5)

modulationIndex:akp(1.0)

amplitude:akp(0.1)];

[self connect:fmOscillator];

AKAudioOutput *audioOutput = [[AKAudioOutput alloc] initWithAudioSource:fmOscil];

[self connect:audioOutput];

}

return self;

}

@end-

基本使用 AudioKit 音频播放相关的功能如下: 播放背景音乐,同一时间只能播放一个音乐,播放别的音乐会直接卸载掉正在播放的音乐。 播放音效,同一时间可以播放多个音效,当多人说话时,也可以用来播放人声。 播放人声,与播放背景音乐一致,同一时间只能播放一个人声,用于播放一些旁白之类的声音非常适合。 对应的 API 调用方式如下: btnPlayGame.onClick.AddListener((

-

原文:AudioKit Tutorial: Getting Started 作者:Colin Eberhardt 同时感谢:kmyhy 近来手上有一些音频相关的开发工作,搜搜基Hub,目前最为强大,性能屌爆,编码炫酷的开源库也只有AudioKit了。Raywenderlich也能找到相关教程,介于作者是3.0+的教程,很多代码都不能跑了,特此整理一趴。 本文不仅是一篇iOS开发教程,更是一篇精彩的

-

Tony Fung Choi Fung 8 ios swift audiokit 我正在尝试构建一个从midi文件中呈现音符的音序器. 目前我正在使用AudioKit进行音乐数据处理.想知道如何使用AudioKit从midi文件中获取音符数据/事件. 我曾尝试使用AKSequencer并输出到AKMIDINode来监听MIDI事件,但似乎无法从中得到任何东西. class CustomMIDINo

-

使用您想要从中获取数据的节点 . 我在上面的引文中使用了AKNodeOutputPlot,因为它非常简单,只是将该数据用作绘图的输入,但是您可以获取数据并对其执行任何操作 . 在此代码中(来自AKNodeOutputPlot): internal func setupNode(_ input: AKNode?) { if !isConnected { input?.avAudioNode.inst

-

目前需要用whsiper做语音转录服务,whisper限制25M的大小,请问该如何做这个事情? 目前的需求是 Android iOS Web 都需要这个功能, 目前有几种方案: 方案1 做一个音频分割服务器,然后在做一个转录服务。前端拿到语音文件之后,把语音文件传给音频分割服务器,分割服务器根据波形进行分割,分割完之后传给转录接口。 问题: 这样做的话是不是会造成语音上传多次导致时间较长的问题,因

-

问题内容: 我正在设计一个简单的调谐器,所以我的目标是显示音符名称(A,B,F#)以及理论声音和实际输入之间的 距离( 以分为单位)。 我是音频和信号处理的新手,所以我做了一些研究,发现 了一个 叫做快速傅立叶变换 的东西 ,它可以分析字节并给我频率。另外,我发现了一些Java库,例如通用数学和JTransforms,所以我不会自己编写硬代码。 我相信就这样,因为每个范围的频率都可以以相同的气质直

-

本文向大家介绍web-audio 合成音频,包括了web-audio 合成音频的使用技巧和注意事项,需要的朋友参考一下 示例 在此示例中,我们展示了如何生成一个简单的正弦波,并将其输出到用户的扬声器/耳机上。 上面的变量的start和stop方法sourceNode都有一个可选参数when,用于指定启动或停止之前要等待的秒数。 因此,停止声音的另一种方法是: type可以将振荡器节点的参数设置为以

-

我编写了代码将几个音频文件与1个图像组合成WebM视频。(audio1与默认jpg结合,audio2与默认jpg结合等)。 问题是,在此之后,视频长度比音频长度长25秒(因此音频在视频结束前缩短25秒)。 有没有办法在音频的同时停止视频?这是我使用的代码(我启动一个BAT命令文件)

-

需求: 声音动态生成, 视频固定来源. 代码中使用的是testsrc. 代码一直卡在rawvedio写入命名管道哪也没撒错误 示例代码: vscode中截图:

-

问题内容: 任何人都有关于如何使用Hbase处理非结构化数据(如音频,视频和图像)的想法。我为此做了很多尝试,但我没有任何想法。请提供任何帮助。 问题答案: 选项1:将图像转换为字节数组,您可以准备放置请求并插入到表中。同样,也可以实现音频和视频文件。 参见https://docs.oracle.com/javase/7/docs/api/javax/imageio/package- summar