Python基于jieba, wordcloud库生成中文词云

代码如下

import wordcloud

import jieba

font = r'C:\Windows\Fonts\simfang.ttf'

w = wordcloud.WordCloud(height = 700, width = 1000, font_path=font, \

stopwords=['et','al', 'Crampin', 'and','the', 'Liu'], max_words=30)

with open('NSFC.txt', 'r') as f:

txt = f.read()

txt = ' '.join(jieba.lcut(txt))

print(txt)

w.generate(txt)

w.to_file('world.png')

准备文件:需要在当前程序运行目录准备一个中文文本文件NSFC.txt。

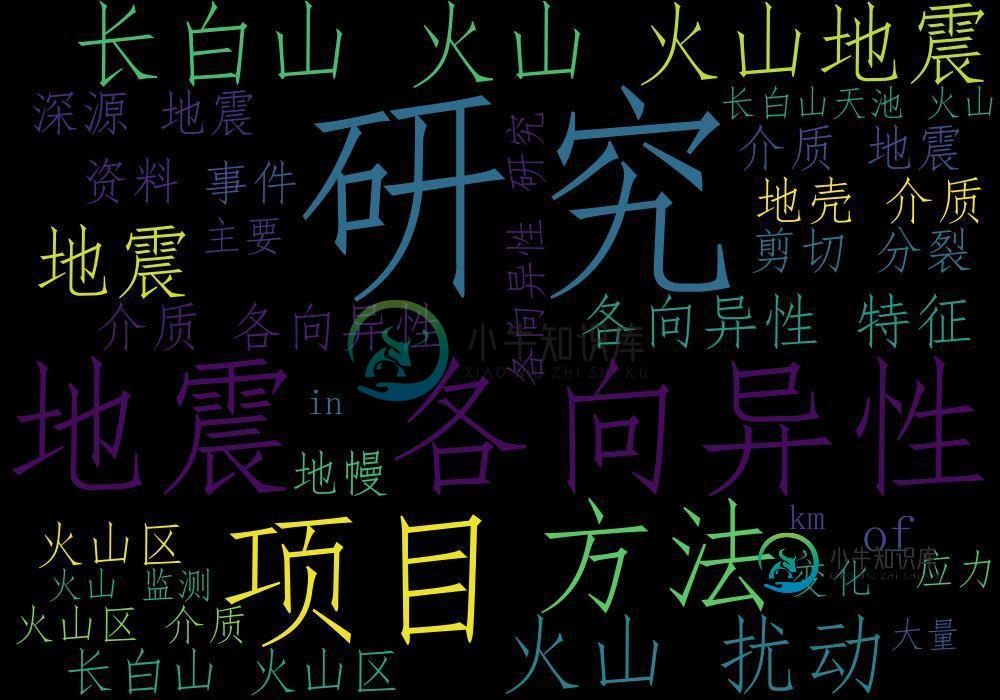

程序运行后,完成对NSFC.txt文件中的中文统计,并输出图形文件展示词云。

图片效果如下:

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持小牛知识库。

-

本文向大家介绍python中文分词库jieba使用方法详解,包括了python中文分词库jieba使用方法详解的使用技巧和注意事项,需要的朋友参考一下 安装python中文分词库jieba 法1:Anaconda Prompt下输入conda install jieba 法2:Terminal下输入pip3 install jieba 1、分词 1.1、CUT函数简介 cut(sentence,

-

本文向大家介绍浅谈python jieba分词模块的基本用法,包括了浅谈python jieba分词模块的基本用法的使用技巧和注意事项,需要的朋友参考一下 jieba(结巴)是一个强大的分词库,完美支持中文分词,本文对其基本用法做一个简要总结。 特点 支持三种分词模式: 精确模式,试图将句子最精确地切开,适合文本分析; 全模式,把句子中所有的可以成词的词语都扫描出来, 速度非常快,但是不能解决歧义

-

安装jieba分词工具 在https://pypi.python.org/pypi/jieba/下载jieba-0.38.zip 解压后执行: python setup.py install 试验切词效果 创建testjieba.py文件内容如下: # coding:utf-8 #!/usr/local/bin/python import jieba seg_list = jieba.cut(

-

问题内容: 我想将“ The”,“他们”和“ My”排除在我的词云中。我正在使用如下所示的python库’wordcloud’,并使用这3个其他停用词来更新STOPWORDS列表,但wordcloud仍包括它们。我需要更改什么才能排除这三个词? 我导入的库是: 我曾尝试按照以下步骤将元素添加到STOPWORDS集中,但是即使单词添加成功,wordcloud仍显示我添加到STOPWORDS集中的3个

-

问题内容: 所以我基本上是在一个项目中,计算机从单词列表中提取一个单词,然后为用户弄乱它。只有一个问题:我不想一直在列表中写很多单词,所以我想知道是否有一种方法可以导入很多随机单词,所以即使我也不知道它是什么,并且那我也可以玩游戏吗?这是整个程序的编码,我只输入了6个字: 问题答案: 如果您重复执行此操作,我将在本地下载它并从本地文件中提取。* nix用户可以使用。 例: 从远程字典中提取 如果您

-

两种打字方式我都不知道。等待的集合。abc。Awaitable涵盖一个基于生成器的协同路由,它是中定义的Awaitable之一 https://www.python.org/dev/peps/pep-0492/#await-expression 从Python 3.6开始,几个API,如和实际上返回基于生成器的协程。我通常对它们的返回值应用关键字没有问题,但是我要处理正常值和可等待值的混合,我需要