python创建属于自己的单词词库 便于背单词

本文实例为大家分享了python创建单词词库的具体代码,供大家参考,具体内容如下

基本思路:以COCA两万单词表为基础,用python爬取金山词霸的单词词性,词义,音频分别存入sqllite。背单词的时候根据需要自定义数据的选择方式。

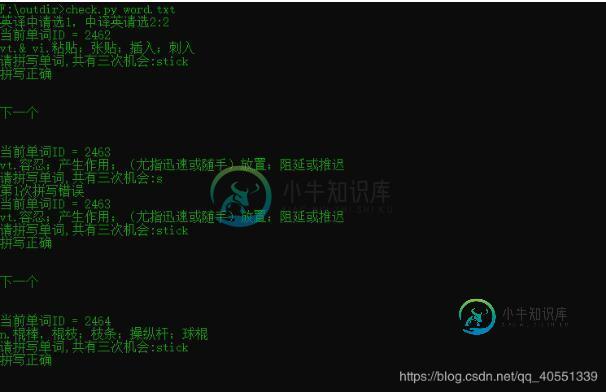

效果如下:

代码写的比较随意,还请见谅。

创建数据库

cu.execute('create table test (id INTEGER PRIMARY KEY AUTOINCREMENT,dc varchar(20),cx varchar(20),cy varchar(50),mp3 varchar(50));')

完整代码,效率不高,不过够用了

import requests

from bs4 import BeautifulSoup

import re

import traceback

import sqlite3

import time

import sys

def ycl(word):

try:

url = "http://www.iciba.com/{}".format(word)

headers = { 'Host': 'www.iciba.com', 'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:43.0) Gecko/20100101 Firefox/43.0', 'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8', 'Accept-Language': 'zh-CN,zh;q=0.8,en-US;q=0.5,en;q=0.3', 'Accept-Encoding': 'gzip, deflate', 'Referer': 'http://www.baidu.com', 'Connection': 'keep-alive', 'Cache-Control': 'max-age=0', }

response = requests.get(url = url,headers = headers)

soup = BeautifulSoup(response.text,"lxml")

#输出单词词性

cx = soup.find(class_='base-list switch_part')(class_='prop')

#输出词性词义

mp3 = soup.find_all(class_='new-speak-step')[1]

pattern = re.compile(r'http://(?:[a-zA-Z]|[0-9]|[$-_@.&+]|[!*\(\),]|(?:%[0-9a-fA-F][0-9a-fA-F]))+.mp3')

mp3url = re.findall(pattern,mp3['ms-on-mouseover'])

mp3url = '.'.join(mp3url)

r = requests.get(mp3url)

#单词音频输出路径

dress = "E:\\sound\\"

mp3path = dress +word+".mp3"

with open(mp3path, 'wb') as f:

f.write(r.content)

#获取词性个数

meanings =soup.find_all(class_='prop')

#实行每个词性的词义同行输出

for i in range(len(meanings)):

s = soup.find(class_='base-list switch_part')('li')[i]('span')

c = cx[i].text

a = ''

for x in range(len(s)):

b = s[x].text

a = a + b

print(word)

print(c)

print(a)

# 存入数据库的方法

conn = sqlite3.connect("word.db")

cu = conn.cursor()

sql =cu.execute("INSERT INTO test (id,dc,cx,cy,mp3)VALUES(NULL,'%s','%s','%s','%s');"%(word,c,a,mp3path))

print(sql)

conn.commit()

print('\n')

except Exception as e:

print(e)

print("error")

with open("log.txt",'a') as f:

f.write(word+'\n')

def duqudanci(file):

wordcount = 0

for line in open(file):

word = line.strip('\n')

wordcount += 1

print(wordcount)

ycl(word)

if __name__ == '__main__':

conn = sqlite3.connect("word.db")

cu = conn.cursor()

word = ""

#需要爬取的单词

duqudanci(sys.argv[1])

print('下载完成')

conn.commit()

conn.close()

自定义背单词: 根据需要可以将单词放入txt文件中进行测试,可以输出词义拼写单词,也可以输出单词,选择对应释义。 当然还可以给每个单词词义加两个属性值,分别表示学习次数和答错次数,然后可以根据这两个值来选择单词,如果有兴趣的话,可以尝试一下。

import sqlite3

import random

import sys

from playsound import playsound

# 中译英

def CtoE():

for j in list1:

sql =cu.execute('select id,dc,cx,cy,mp3 from wordinfo where id = ?',(j,))

for it in sql:

# 返回的是元组,直接对元组查询

c=0

while c<3:

print("当前单词ID = "+str(it[0]))

print("释义:"+it[3])

# 播放音频

playsound(it[4])

a = input("请拼写单词,共有三次机会:")

if a == it[1]:

print("拼写正确")

break;

c += 1

print('第%d次拼写错误'%c)

print('\n')

print("下一个")

print('\n')

# 英译中

def EtoC():

for j in list1:

sql =cu.execute('select id,dc,cx,cy,mp3 from wordinfo where id = ?',(j,))

d =0

for it in sql:

# 返回的是元组,直接对元组查询

c=0

while c<3:

# 释放list2

list2 = []

sql =cu.execute('select cy from wordinfo where id !=? order by random() limit 3',(j,))

for t in sql:

for o in range(len(t)):

#将随机取出的数据放入列表

list2.append(t[o])

# 加入正确答案

p = random.randint(0,3)

list2.insert(p,it[3])

print("当前单词ID = "+str(it[0]))

print("选择单词的对应释义:----"+it[1])

playsound(it[4])

dict1 = {'A':list2[0],'B':list2[1],'C':list2[2],'D':list2[3]}

print("A:"+dict1.get('A')+'\n')

print("B:"+dict1.get('B')+'\n')

print("C:"+dict1.get('C')+'\n')

print("D:"+dict1.get('D')+'\n')

answer1 = input("请选择,共有三次机会(大写):")

if dict1.get(answer1)== it[3]:

print("正确")

break;

c += 1

print('第%d次拼写错误'%c)

d += 1

print('\n')

print("下一个")

print('\n')

def main(file):

for line in open(file):

word = line.strip('\n')

sql =cu.execute('select id from wordinfo where dc = ?',(word,))

for x in sql:

list1.append(x[0])

cho = input("英译中请选1,中译英请选2:")

if cho =="1":

EtoC()

elif cho =="2":

CtoE()

else:

print("错误,请重试")

if __name__ == '__main__':

conn = sqlite3.connect("word.db")

cu = conn.cursor()

list1 = []

word = ""

main(sys.argv[1])

conn.commit()

conn.close()

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持小牛知识库。

-

我是NLP新手,我遇到了OpenNLP。根据我的理解,意味着将文本分割成单词和句子。单词通常用空格隔开,但并非所有空格都相等。例如,洛杉矶在一个人的思想中不考虑空白。但每当我运行OpenNLP标记器时,它都会为洛杉矶创建两个不同的标记:Los 以下是输出: 我在线测试了其他一些标记化器,它们产生相同的输出。如果不是标记化,识别这两个词属于一起的过程是什么?

-

我最初在这里发布了这个问题,但后来被告知将其发布到代码审查;然而,他们告诉我,我的问题需要在这里发布。我会试着更好地解释我的问题,希望没有混淆。我正在尝试编写一个单词一致性程序,它将执行以下操作: 1) 读“停”字。txt文件放入一个只包含停止词的字典(使用与您计时的字典类型相同的字典),称为stopWordDict。(警告:在将换行符('\n')添加到stopWordDict之前,请先将其从停止

-

问题内容: 我有一组不同语言的单词(英语,波兰语,芬兰语,俄语等),需要检查一下,用大写字母写的是什么。 我尝试使用简单的正则表达式:,但仅匹配拉丁字母,然后添加了俄语大写字母:。 但是,许多 带有变音符号的unicode字母 仍然存在。如何将 所有 大写字母添加到正则表达式中? 可以不使用符号枚举就可以做到这一点吗? PS我知道,如何在Ruby中做到这一点,但现在我正在使用Python。 问题答

-

所以我做了一个函数 因此,它所做的是获取一个字符串,将其拆分,并生成一个字典,其中键是单词,值是它出现的次数。 好的,我现在要做的是,做一个函数,它接受这个函数的输出,并产生一个如下格式的列表- ((超过1个字母的单词列表),(最常用单词列表),(最长单词列表)) 另外,例如,假设两个单词出现了3次,并且两个单词都有6个字母长,那么这两个单词都应该包含在(最频繁的)和(最长的)列表中。 因此,到目

-

我正在做一个著名的WordCount程序的稍微改进的版本,它应该输出单词占书的百分比。例如: 基本上,我需要计算所有的单词,计算每一个单词的出现次数,将这组值除以总数。所以至少应该有两个工作: 作业1 null null > 我希望避免重复原始输入,这就是为什么我要在job1中同时计算字数和总数。但我不明白如何避免在一个输出中混淆结果。我尝试使用,但在本例中,映射器的结果不会进入reducer。

-

●词库管理:对于同音字(锦绣大地、锦锈大地)、形近字(杏石口村、杏右口村)、缩写地址(牛栏山第一中学、牛栏山一中)、别名 等经常误写的地址,在系统中将经常出现错误的地址与正确的区域对应起来(也称为关键词绑定),下次再出现,能够直接分 到匹配站点,提高分单准确率。 例如:地址“牛栏山一中”在自动分拣的时候解析错误,我们在地图上找到“牛栏山第一中学”并确认“牛栏山一中”就是“牛栏山 第一中学”,因此,