nodejs制作爬虫实现批量下载图片

今天想获取一大批猫的图片,然后就在360流浪器搜索框中输入 猫 ,然后点击图片。就看到了一大波猫的图片: http://image.so.com/i?q=%E7%8... ,我在想啊,要是审查元素,一张张手动下载,多麻烦,所以打算写程序来实现。不写不知道,一写发现里面还是有很多道道的。

1. 爬取图片链接

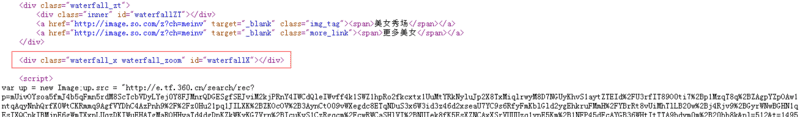

因为之前也写过nodejs爬虫功能(参见:NodeJS制作爬虫全过程 ),所以觉得应该很简单,就用cheerio来处理dom啦,结果打印一下啥也没有,后来查看源代码:

发现 waterfall_zoom 里面空空如也,查找了一下,发现所有的数据都是写在 <script> 里面,然后动态加载到页面的,所以用cheerio.load到的页面里面其实没数据的。真实数据:

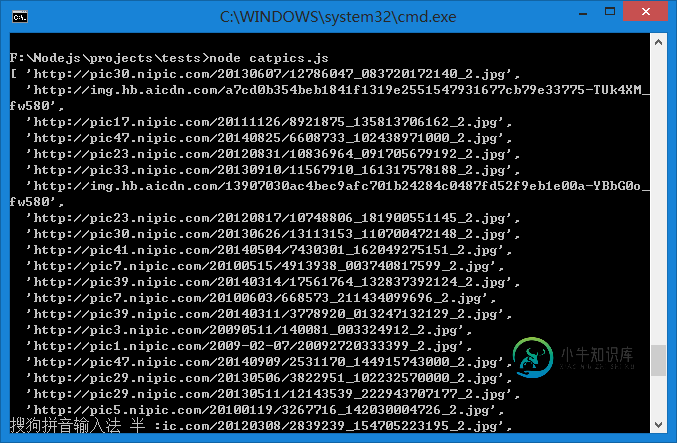

分析完毕,刷刷写代码:

var request = require('request');

var cheerio = require('cheerio');

var url = 'http://image.so.com/i?q=%E7%8C%AB&src=tab_www';

request(url,function(err,res,body){

if(!err && res.statusCode === 200){

var $ = cheerio.load(body);

var imgList = []

JSON.parse($('script[id="initData"]').html()).list.forEach(function(item){

imgList.push(item.img)

});

console.log(imgList);

}

});

2. 下载图片到本地 2.1 粗糙的方案

最初的思路很简单,简单的 fs.createWriteStream() 就能解决:

var downloadPic = function(src, dest){

request(src).pipe(fs.createWriteStream(dest)).on('close',function(){

console.log('pic saved!')

})

}

使用方式:

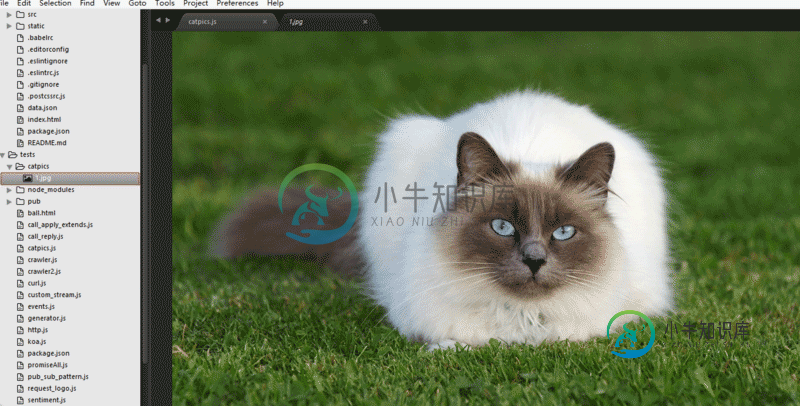

downloadPic(imgList[0],'./catpics/1.jpg');

成功捕获一只猫!然后写了一个循环准备捕获所有猫。然而这种方式是串行的,速度很慢!下载一大批图片要花大量时间。

2.2 使用async异步批量下载

关于async的map操作,详见: async_demo/map.js ,对集合中的每一个元素,执行某个异步操作,得到结果。所有的结果将汇总到最终的callback里。与forEach的区别是,forEach只关心操作不管最后的值,而map关心的最后产生的值。

提供了两种方式:

并行执行。 async.map 同时对集合中所有元素进行操作,结果汇总到最终callback里。如果出错,则立刻返回错误以及已经执行完的任务的结果,未执行完的占个空位

顺序执行。 async.mapSeries 对集合中的元素一个一个执行操作,结果汇总到最终callback里。如果出错,则立刻返回错误以及已经执行完的结果,未执行的被忽略。

在此处:

async.mapSeries(imgList,function(item, callback){

setTimeout(function(){

downloadPic(item, './catpics/'+ (new Date()).getTime() +'.jpg');

callback(null, item);

},400);

}, function(err, results){});

注: 此处使用setTimeout,是因为下载需要一定时间,在笔者较慢网速下,需要400ms的间隔能确保每张图片下载完全。

成功捕获一批猫猫!

2.3 使用bagpipe批量

bagpipe 是朴灵大大做的一个在nodejs中控制并发执行的模块。其安装和使用也比较简单:

npm install bagpipe --save

使用:

var Bagpipe = require('bagpipe');

var bagpipe = new Bagpipe(10);

var files = ['这里有很多很多文件'];

for(vari =0; i < files.length; i++){

bagpipe.push(fs.readFile, files[i], 'utf-8',function(err, data){

...

});

}

在此处:

var bagpipe = new Bagpipe(10,{timeout: 100});

for(var i = 0; i < imgList.length; i++) {

console.log('i:'+i)

bagpipe.push(downloadPic, imgList[i], './catpics/'+ i +'.jpg', function(err, data){

//

});

}

3.总结

作为一个程序员,能用程序解决就不手动解决。每一次尝都会有新的收获。

-

本文向大家介绍Nodejs实现批量下载妹纸图,包括了Nodejs实现批量下载妹纸图的使用技巧和注意事项,需要的朋友参考一下 听说最近下载妹子图很火? Nodejs (javascrpt)自然不能落后~ 虽然从没写过像样的Nodejs程序,但作为至少翻过书的前端同学来说,Nodejs用得还蛮顺手的哈~ 花了一点事件学习了下Nodejs的网页获取和文件下载方法,没事乱捣腾就写了这个半成品的下载器 使用

-

本文向大家介绍python实现爬虫下载美女图片,包括了python实现爬虫下载美女图片的使用技巧和注意事项,需要的朋友参考一下 本次爬取的贴吧是百度的美女吧,给广大男同胞们一些激励 在爬取之前需要在浏览器先登录百度贴吧的帐号,各位也可以在代码中使用post提交或者加入cookie 爬行地址:http://tieba.baidu.com/f?kw=%E7%BE%8E%E5%A5%B3&ie=utf-

-

本文向大家介绍Python爬虫实现百度图片自动下载,包括了Python爬虫实现百度图片自动下载的使用技巧和注意事项,需要的朋友参考一下 制作爬虫的步骤 制作一个爬虫一般分以下几个步骤: 分析需求分析网页源代码,配合开发者工具编写正则表达式或者XPath表达式正式编写 python 爬虫代码 效果预览 运行效果如下: 存放图片的文件夹: 需求分析 我们的爬虫至少要实现两个功能:一是搜索图片,二是自动

-

本文向大家介绍NodeJS制作爬虫全过程(续),包括了NodeJS制作爬虫全过程(续)的使用技巧和注意事项,需要的朋友参考一下 书接上回,我们需要修改程序以达到连续抓取40个页面的内容。也就是说我们需要输出每篇文章的标题、链接、第一条评论、评论用户和论坛积分。 如图所示,$('.reply_author').eq(0).text().trim();得到的值即为正确的第一条评论的用户。 {<1>}

-

本文向大家介绍nodejs制作小爬虫功能示例,包括了nodejs制作小爬虫功能示例的使用技巧和注意事项,需要的朋友参考一下 本文实例讲述了nodejs制作小爬虫功能。分享给大家供大家参考,具体如下: 1 安装nodejs 2 安装需要模块 3 新建js文件 4 引入 5 利用request模块发送请求 一个小爬虫案例就完了 附上完整代码 下面的带数据库 希望本文所述对大家node.js程序设计有所

-

主要内容:案例简单分析,编写爬虫程序本节通过具体的爬虫程序,演示 BS4 解析库的实际应用。爬虫程序目标:下载诗词名句网( https://www.shicimingju.com/book/)《 两晋演义》小说。 关于分析网页分过程,这里不再做详细介绍了,只要通读了前面的文章,那么关于如何分析网页,此时您应该了然于胸了。其实,无论您爬取什么类型的网站,分析过程总是相似的。 案例简单分析 首先判网站属于静态网站,因此您的主要任务是分析