Python制作豆瓣图片的爬虫

前段时间自学了一段时间的Python,想着浓一点项目来练练手。看着大佬们一说就是爬了100W+的数据就非常的羡慕,不过对于我这种初学者来说,也就爬一爬图片。

我相信很多人的第一个爬虫程序都是爬去贴吧的图片,嗯,我平时不玩贴吧,加上我觉得豆瓣挺良心的,我就爬了豆瓣首页上面的图片。其实最刚开始是想爬全站,后来一想我这简直是脑子犯抽,全站的图片爬下来得有多少,再说这个只是练一下手,所以就只爬取了首页上的图片。废话不多说 开始代码。

首先是主文件的代码:

import re from html_downloder import HtmlDownloader from html_downloder import Image "'起始URL'" url = "https://www.douban.com" "'保存目录'" image_path = "F:\source\Python\爬虫\ImageGet\Image%s.jpg" "'定义实体类'" downloader = HtmlDownloader() html = downloader.download(url) "'SaveFile(html, html_path)'" html = html.decode('utf-8') "'正则表达式'" reg1 = r'="(https://img[\S]*?[jpg|png])"' "'提取图片的URL'" dbdata = re.findall(reg1, html) imgsave = Image() "'下载保存图片'" imgsave.ImageGet(dbdata, image_path)

我们打开豆瓣首页然后看一下里面图片的url会发现

都是以“=”等号开头,后面接双引号,中间都是https://img,末尾以双引号结束。

因此我们的正则表达式可以写成 reg1 = r'="(https://img[\S]*?[jpg|png])"'

在这个表达式中"[]"中括号里面的东西会作为一个整体,其中[\S]表示大小写字母和数字,[jpg|png]表示以png结尾或者jpg结尾(在这次爬虫中并没有包括gif,因为打开gif的url发现是空白)。

然后是html_downloder.py的代码:

# file: html_downloader.py

import urllib.request

import urllib.error

import time

class HtmlDownloader(object):

def download(self, url):

if url is None:

return None

try:

header = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64)'}

"'发出请求'"

request = urllib.request.Request(url=url, headers=header)

"'获取结果'"

response = urllib.request.urlopen(url)

except urllib.error.URLError as e:

if hasattr(e, "code"):

print(e.code)

if hasattr(e, "reason"):

print(e.reason)

if response.getcode() != 200:

return None

html = response.read()

response.close()

return html

class Image (object):

def ImageGet(self, imageurl, image_path):

x = 0

for li in imageurl:

urllib.request.urlretrieve(li, image_path % x)

x = x + 1

"'休眠5s以免给服务器造成严重负担'"

time.sleep(5) 这个文件的代码主要是负责下载html网页和下载具体的图片。

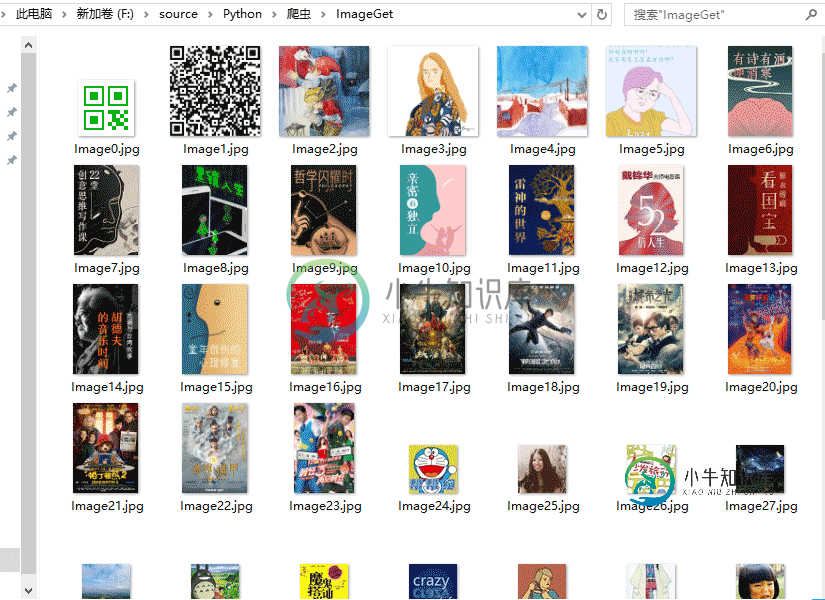

接下来就可以在保存路径对应的文件夹中中看到下载的图片了

至此,爬虫告一段落,离大佬的路还远得很,继续加油!!

-

本文向大家介绍python制作花瓣网美女图片爬虫,包括了python制作花瓣网美女图片爬虫的使用技巧和注意事项,需要的朋友参考一下 花瓣图片的加载使用了延迟加载的技术,源代码只能下载20多张图片,修改后基本能下载所有的了,只是速度有点慢,后面再优化下

-

本文向大家介绍Python爬豆瓣电影实例,包括了Python爬豆瓣电影实例的使用技巧和注意事项,需要的朋友参考一下 文件结构 html_downloader.py - 下载网页html内容 html_outputer.py - 输出结果到文件中 html_parser.py: 解析器:解析html的dom树 spider_main.py - 主函数 综述 其实就是使用了urllib2和Beauti

-

本文向大家介绍Python实现豆瓣图片下载的方法,包括了Python实现豆瓣图片下载的方法的使用技巧和注意事项,需要的朋友参考一下 本文实例讲述了Python实现豆瓣图片下载的方法。分享给大家供大家参考。具体分析如下: 1 用 tk 封装一下 2 用户可以自己输入图片url 希望本文所述对大家的Python程序设计有所帮助。

-

豆瓣小组图片采集程序 By 肾虚公子 官网: http://Douban.miaowu.asia 主程序:dou2.py Mac/Liunx 用户需要创建 Doubanimg 文件夹 然后运行程序(python dou2.py)即可。 Windows用户请下载压缩包: 下载 程序基本功能 用户可以自由选择用户组下载图片支持豆瓣所有小组 本程序自动采集代理 采集代理后随机选择 自动下载图片并保存 获

-

本文向大家介绍Python多线程爬取豆瓣影评API接口,包括了Python多线程爬取豆瓣影评API接口的使用技巧和注意事项,需要的朋友参考一下 爬虫库 使用简单的requests库,这是一个阻塞的库,速度比较慢。 解析使用XPATH表达式 总体采用类的形式 多线程 使用concurrent.future并发模块,建立线程池,把future对象扔进去执行即可实现并发爬取效果 数据存储 使用Pytho

-

本文向大家介绍实践Python的爬虫框架Scrapy来抓取豆瓣电影TOP250,包括了实践Python的爬虫框架Scrapy来抓取豆瓣电影TOP250的使用技巧和注意事项,需要的朋友参考一下 安装部署Scrapy 在安装Scrapy前首先需要确定的是已经安装好了Python(目前Scrapy支持Python2.5,Python2.6和Python2.7)。官方文档中介绍了三种方法进行安装,我采用的