python实现k-means聚类算法

k-means聚类算法

k-means是发现给定数据集的k个簇的算法,也就是将数据集聚合为k类的算法。

算法过程如下:

1)从N个文档随机选取K个文档作为质心

2)对剩余的每个文档测量其到每个质心的距离,并把它归到最近的质心的类,我们一般取欧几里得距离

3)重新计算已经得到的各个类的质心

4)迭代步骤(2)、(3)直至新的质心与原质心相等或迭代次数大于指定阈值,算法结束

算法实现

随机初始化k个质心,用dict保存质心的值以及被聚类到该簇中的所有data。

def initCent(dataSet , k):

N = shape(dataSet)[1]

cents = {}

randIndex=[]

#随机生成k个不重复的索引

for i in range(k):

rand = random.randint(0,N)

while rand in randIndex:

rand = random.randint(0, N)

randIndex.append(rand)

#按索引取dataSet中的data作为质心

for i in range(k):

templist = []

templist.append(dataSet[randIndex[i]])

templist.append([dataSet[randIndex[i]]])

cents[i] = templist

return cents

对dataSet中的所有数据进行一次聚类。返回值cents为dict类型的数据,int类型的key,list类型的value。其中cents[i][0]为质心位置,cents[i][1]为存储该簇中所有data的列表。

#计算两个向量的欧氏距离 def calDist(X1 , X2): sum = 0 for x1 , x2 in zip(X1 , X2): sum += (x1 - x2) ** 2 return sum ** 0.5 #聚类 def doKmeans(dataSet , k , cents): #清空上一次迭代后的簇中元素,只记录质心 for i in range(k): cents[i][1] = [] for data in dataSet: no = 0#初始化簇标号 minDist = sys.maxint#初始化data与k个质心的最短距离 for i in range(k): dist = calDist(data , cents[i][0]) if dist < minDist: minDist = dist no = i #找到距离最近的质心 cents[no][1].append(data) #更新质心 for i in range(k): for j in range(shape(dataSet)[0]): cents[i][0] = mean(cents[i][1],axis=0).tolist() return cents

k-means主方法

#判断两次聚类的结果是否相同 def isEqual(old , new): for i in range(len(old)): if(old[i] != new[i][0]): return 0 return 1 #主方法 def kmeans_main(dataSet,k): cents = initCent(dataSet, k) for x in range(1000): oldcents = [] #拷贝上一次迭代的结果 for i in cents.keys(): oldcents.append(cents[i][0]) newcents = doKmeans(dataSet, k , cents) #若相邻两次迭代结果相同,算法结束 if isEqual(oldcents , newcents)>0: break cents = newcents return cents

结果测试

数据集(虚构)

2 3 2.54

2 1 0.72

3 5 3.66

4 3 1.71

3.11 5.29 4.13

4.15 2 3.1

3.12 3.33 3.72

1.49 5 2.6

3 5 2.88

3.9 1.78 2.56

-2 3 5

3 1 0.4

-2 1 2.2

-3 0 1.7

-4 1 2

8 -1 0

2 3.2 7.1

1 3 5

2 4 3

0.1 2 5.4

2 0 5.54

2 1 1.72

3 5 2.66

1 8 1.71

5.11 1.29 4.13

7.15 2 7.1

1.12 5.33 4.72

6.49 4 3.6

4 8 6.88

1.9 5.78 6.56

-2 -3 2.5

1 -1 2.4

-2 1 3.2

-1 0 5.7

-2 3 2

1 -1 4

3 4.2 6.1

5 2 5

3 5.7 13

0.9 2.9 1.4

画图方法

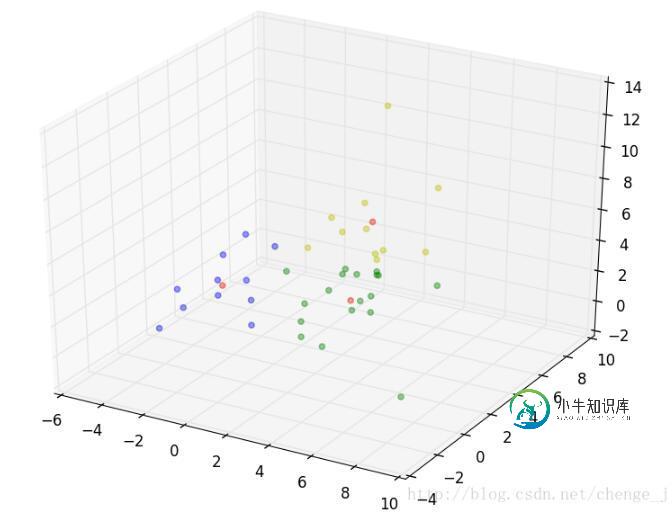

def draw(cents): color = [ 'y', 'g', 'b'] X = [] Y = [] Z = [] fig = plt.figure() ax = Axes3D(fig) for i in cents.keys(): X.append(cents[i][0][0]) Y.append(cents[i][0][1]) Z.append(cents[i][0][2]) ax.scatter(X, Y, Z,alpha=0.4,marker='o',color='r', label=str(i)) for i in cents.keys(): X = [] Y = [] Z = [] data = cents[i][1] for vec in data: X.append(vec[0]) Y.append(vec[1]) Z.append(vec[2]) ax.scatter(X, Y, Z, alpha=0.4,marker='o', color=color[i], label=str(i),) plt.show()

测试及结果展示(红点表示质心)

dataSet = loadDataSet("dataSet.txt")

cents = kmeans_main(dataSet , 3)

draw(cents)

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持小牛知识库。

-

本文向大家介绍k-means 聚类算法与Python实现代码,包括了k-means 聚类算法与Python实现代码的使用技巧和注意事项,需要的朋友参考一下 k-means 聚类算法思想先随机选择k个聚类中心,把集合里的元素与最近的聚类中心聚为一类,得到一次聚类,再把每一个类的均值作为新的聚类中心重新聚类,迭代n次得到最终结果分步解析 一、初始化聚类中心 首先随机选择集合里的一个元素作为第一个聚类中

-

使用k-means算法时需要指定分类的数量,这也是算法名称中“k”的由来。 k-means是Lloyd博士在1957年提出的,虽然这个算法已有50年的历史,但却是当前最流行的聚类算法! 下面让我们来了解一下k-means聚类过程: 我们想将图中的记录分成三个分类(即k=3),比如上文提到的犬种数据,坐标轴分别是身高和体重。 由于k=3,我们随机选取三个点来作为聚类的起始点(分类的中心点),并用红黄

-

本文会介绍一般的k-means算法、k-means++算法以及基于k-means++算法的k-means||算法。在spark ml,已经实现了k-means算法以及k-means||算法。 本文首先会介绍这三个算法的原理,然后在了解原理的基础上分析spark中的实现代码。 1 k-means算法原理分析 k-means算法是聚类分析中使用最广泛的算法之一。它把n个对象根据它们的属性分为k

-

算法介绍 K-Means又名为K均值算法,他是一个聚类算法,这里的K就是聚簇中心的个数,代表数据中存在多少数据簇。K-Means在聚类算法中算是非常简单的一个算法了。有点类似于KNN算法,都用到了距离矢量度量,用欧式距离作为小分类的标准。 算法步骤 (1)、设定数字k,从n个初始数据中随机的设置k个点为聚类中心点。 (2)、针对n个点的每个数据点,遍历计算到k个聚类中心点的距离,最后按照离哪个中心

-

聚类 聚类,简单来说,就是将一个庞杂数据集中具有相似特征的数据自动归类到一起,称为一个簇,簇内的对象越相似,聚类的效果越好。它是一种无监督的学习(Unsupervised Learning)方法,不需要预先标注好的训练集。聚类与分类最大的区别就是分类的目标事先已知,例如猫狗识别,你在分类之前已经预先知道要将它分为猫、狗两个种类;而在你聚类之前,你对你的目标是未知的,同样以动物为例,对于一个动物集来

-

k-means 算法,也被称为 k-平均 或 k-均值,是一种得到最广泛使用的聚类算法。 它把n个点(可以是样本的一次观察或一个实例)划分到k个聚类中,使得每个点都属于离他最近的均值(此即聚类中心)对应的聚类,以之作为聚类的标准。 相异度计算方法: 欧几里得距离 曼哈顿距离 闵可夫斯基距离 皮尔逊相关系数 优点 简单、快速,可并行计算 已经获得防范的应用 缺点 必须事先给出k(要生成的簇的数目),