《负载均衡》专题

-

将nginx公开为负载均衡器与入口控制器有什么区别?

我知道,当我们想用一个负载平衡器/公共IP公开多个服务/路由时,可以使用入口。 现在我想公开我的Nginx服务器。我有两个选择 设置瞧,我得到了公共IP 使用Nginx入口控制器 现在我可以用选项1完成我的工作了,我什么时候或者为什么要选择选项2?使用带有入口的nginx而不使用入口有什么好处?

-

如果没有外部IP,Google Cloud HTTP负载均衡器健康检查失败

场景:我有一个Google Compute Engine实例,通过HTTP端口80公开了一个web应用程序,我可以使用外部IP地址直接访问它。 然后,我添加了一个带有运行状况检查的HTTP负载平衡器,之后,我可以通过负载平衡器访问web应用程序而没有任何问题。 现在,如果删除计算实例的外部IP地址,负载平衡器的健康检查就会开始失败。我阅读了[1]并添加了防火墙规则,允许运行状况检查探测来自130.

-

修复了aws应用程序负载均衡器背后服务的IP地址

我们公司刚搬到一个新办公室,因此也有了新的网络设备。事实证明,我们的新防火墙不允许在VPN上推送路由,它首先必须查找ip地址。 众所周知,amazon aws不允许其应用程序负载平衡器使用静态ip地址。 因此,我们的想法是简单地将网络负载平衡器放在应用程序负载平衡器的前面(aws本身描述了一种非常黑客的方式(https://aws.amazon.com/blogs/networking-and-c

-

为什么负载均衡器不能使用Eureka找到所需的微服务?

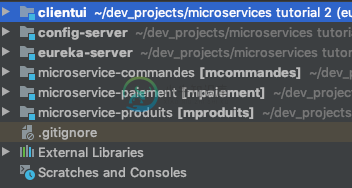

为什么负载均衡器不能使用Eureka找到所需的微服务?clientui使用来自3个微服务的数据服务网页。 我成功地设置了ribbon,以便在“微服务生产”的两个实例之间实现负载平衡。当我在ClientUI的application.properties中有一行时,它就可以工作了。 现在我想让它工作,而不必硬编码微服务URL。 我尝试在application.properties中添加fetchRegistry行,并在(clientui)pom.xml中

-

如何将Apache ZooKeeper与Spring云服务发现和负载均衡结合使用?

我是Apache ZooKeeper概念的新手,它使用netflix ribbon客户端实现服务发现和负载平衡。我在github中看到了一些示例(https://github.com/spring-cloud/spring-cloud-zookeeper ). 有人能帮助我了解如何在应用服务实例上设置ZooKeeper和服务发现实现吗。我很想知道这个概念。 提前感谢…,

-

liberty中启动时的负载负值

我目前正在将我的应用程序从WAS 8迁移到WAS Liberty,我遇到了以下问题。在我的一个模块网页中。xml文件中,servlet启动时的加载值为-1。在Liberty中运行时,不会调用特定的servlet。有人能帮我吗?请从我的web.xml<code>中找到以下代码片段

-

负载测试相同的APIendpoint时,平均响应时间差异很大,使用Jeter进行相同负载的测试

我正在使用 JMeter 来测试 API endpoint的性能。应用的线程数(用户)为 100。当我第一次执行测试时,平均响应时间为 35345 毫秒,对于同一 API 终结点上具有相同线程数的所有后续测试,平均响应时间约为 4705 毫秒。 平均响应时间差异如此之大的原因是什么?JMeter 是否在第一次测试中缓存任何文件,并在所有后续测试中使用相同的缓存文件?如果是,我该如何避免这种情况?

-

Spark性能:本地比集群快(执行器负载非常不均匀)

Spark性能:本地比集群快(执行器负载非常不均匀)让我先说我对spark相对来说是新手,所以如果我说了一些没有意义的话,请纠正我。 总结一下这个问题,不管我做什么,在某些阶段,一个执行器做所有的计算,这使得集群执行比本地的单处理器执行慢。 完整故事:我编写了一个Spark1.6应用程序,它由一系列映射、过滤器、连接和一个简短的graphx部分组成。该应用程序只使用一个数据源-csv文件。出于开发的目的,我创建了一个由100,000行7MB组成的模

-

将外部HTTPS负载均衡器与暴露为区域NEG的NGINX入口连接

我正在尝试将外部HTTPS(L7)负载平衡器与公开为区域网络endpoint组(NEG)的NGINX入口连接起来。我的Kubernetes集群(在GKE中)包含两个web应用程序部署,我将其公开为ClusterIP服务。 我知道NGINX Inete对象可以直接公开为TCP负载均衡器。但是,这不是我想要的。相反,在我的架构中,我想使用外部HTTPS负载均衡器来负载平衡HTTPS请求。我希望这个外部

-

是否可以通过GKE入口配置Google Cloud内部TCP/UDP负载均衡器?

我正在使用谷歌GKE。我需要一个内部tcp直通负载平衡器来公开我的服务。后端服务可以终止TLS通信。我可以手动配置tcp负载平衡器。但是,我想通过入口管理loadbalancer。google云文档只谈到通过入口创建HTTP(S)L7负载平衡器。 是否可以通过GKE入口配置Google Cloud内部TCP/UDP负载均衡器?

-

如何使用kubernetes服务从Google网络负载均衡器获取客户端IP

我在GKE中创建了一个类型为LoadBalancer的kubernetes服务。 这是一个nginx服务,尝试获取源客户端IP。喜欢 但结果将是: 就像在kubernetes IP中一样。 $http_x_forwarded_for为空。 我不知道为什么这和文件上说的不一样。 https://cloud.google.com/load-balancing/docs/network 网络负载平衡是一

-

处理Terraform重新创建带有负载均衡器的AWS子网,导致死锁

所以我有两个项目,彼此分离,使用单独的terraform状态文件来管理自己。 项目A:专有网络、网络、子网、eip、gw层。此项目是我工作组中所有项目的共享专有网络。我们在同一专有网络内启动所有项目 项目B:应用程序、负载均衡器、安全组、ecs容器、api网关。这个项目就是应用程序本身,您可以相应地配置负载均衡器,使用允许任何端口的安全组,并在ecs上运行软件。 问题是:当我想更改VPC配置中的一

-

代理协议可以与AWS应用程序负载均衡器一起使用吗?

AWS较旧的“经典”负载平衡器能够设置代理协议策略,该策略将请求的外部IP地址添加到内部请求的HTTP标头中。 AWS较新的应用程序负载均衡器似乎没有相同的功能。这是正确的,还是可以启用的? 如果它不是一个选项,那么是否建议恢复到经典的负载平衡器?我觉得有必要使用较新的负载平衡器类型,因此对经典方法如此执着是不明智的。

-

在负载均衡器中配置HTTPS后,无法访问Elastic Beanstalk上的HTTPS站点

null 我是否需要做任何额外的配置来让服务器在HTTPS上响应?我假设在应用程序级别不需要配置,因为SSL在负载均衡器终止,应用程序将继续使用HTTP是正确的吗?

-

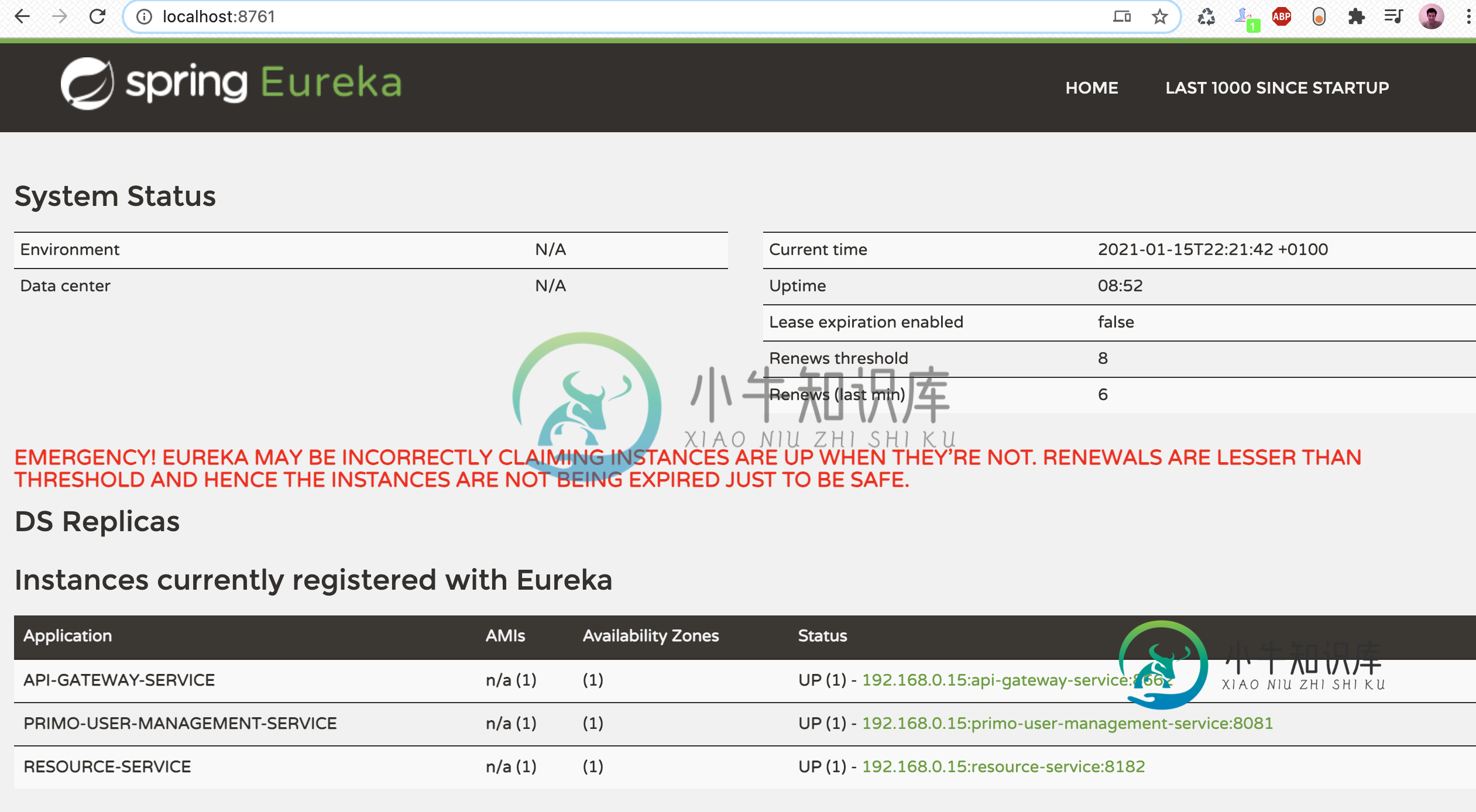

Zuul转发错误,负载均衡器没有可用于客户端的服务器

Zuul转发错误,负载均衡器没有可用于客户端的服务器我正在尝试以下教程:使用Eureka的Spring Boot微服务和使用Feign Client的Zuul代理。 我创建了3个微服务:一个使用Zuul的Api网关,一个使用Feign的资源服务,一个使用Eureka的发现服务,以及另一个包含前端应用程序的业务逻辑的微服务PRIMO用户管理服务。 当我试图从API网关调用URL时,我面临一个错误“转发错误”:http://localhost:8662