《负载》专题

-

kubectl通过负载平衡器

kubernetes集群与api服务器(https://192.168.0.10:6443) 想法: 从我的笔记本电脑,我想运行kubectl,指向负载均衡器,在那里牧师代理将把我重定向到api服务器。 步骤: -我将kubeconfig(笔记本电脑上)文件中的服务器ip更改为LB的ip:https://192.168.0.10:6443是http://10.10.0.2:8080/ -我这样配置

-

提取转换负载到MySql

我基本上来自微软背景,在SSIS for ETL项目上工作很多。 现在我手头有另一个项目来处理将. csv文件加载到MySql数据库中。在加载这些表的过程中,数据必须经过一些转换,然后进入目标表。这是ETL项目的一部分。 客户端没有SSIS(BIDS)并且被迫使用开源工具。 我做了一些研究,发现Talend数据集成工具最适合我的情况。 由于我是这个环境的新手,而且我确信这方面有专家,所以我需要一些

-

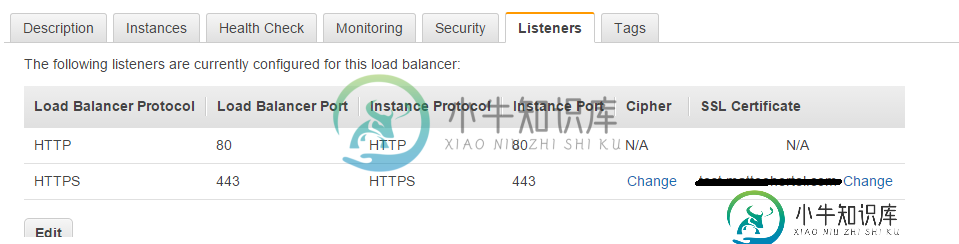

AWS-SSL/HTTPS负载均衡器

AWS-SSL/HTTPS负载均衡器我在将https添加到我的EC2实例时遇到了一个问题,也许你们可以找到让它工作的答案。 我有一个负载平衡器,它正在将连接转发到我的EC2实例,我已将SSL证书添加到负载平衡器,一切正常,我已将侦听器添加到端口443,该端口将转发到我的实例的端口443,我已将Apache配置为在端口443和80上侦听,现在这里是我的负载平衡器的屏幕截图: SSL证书有效,在端口80(HTTP)上一切正常,但如果我尝

-

POD 之间的负载平衡

是否有一种方法可以在微服务的两个pod之间进行主动和被动负载平衡。假设我有两个运行微服务的实例(pod),它是使用K8s服务对象公开的。是否有一种方法来配置负载平衡,使一个pod始终获得请求,当该pod停机时,另一个po将开始接收请求? 我在该服务的顶部还有一个ingress对象。

-

Servlet/WebApp抛出负载()异常

是这样发生的还是我错过了什么?

-

入口与负载均衡器

负载均衡器的作用是将流量转发到主机。在这方面,ingress与负载均衡器有何不同?另外,与Amazon ELB和ALB相比,kubernetes内部的负载均衡器是什么概念?

-

gRPC客户端负载平衡

我在kubernetes pods中使用带有Python的gRPC作为客户端/服务器......我希望能够启动多个相同类型的pod(gRPC服务器)并让客户端(随机)连接到它们。 我调度了10个服务器吊舱,并设置了一个“服务”来瞄准它们。然后,在客户端,我连接到服务的DNS名称——这意味着kubernetes应该进行负载平衡,并将我指向一个随机服务器pod。实际上,客户机调用gRPC函数(这很有效

-

MongoDB副本设置CPU负载

主程序的日志文件包含大量的getmore oplog查询-我猜主程序上的任何操作都会创建一个oplog查询。在我看来,这是太多的复制开销,但我没有任何关于MongoDB负载的经验,也没有任何关键数据。 由于安装程序将不得不容忍更多的生产负载,我的问题是,复制开销是否是预期的,即使是在次要服务器上,CPU负载增加这么高是否正常,还是我遗漏了什么?

-

NodeJS路由器负载过大

我正在我的nodejs应用程序中创建restendpoint,如下所示: 在我的服务器上。我有以下代码: 我还尝试了下面的代码,而不是像在潜在重复问题上建议的那样使用express.json和expres.urlencoded。 在我的APIRoutes文件中,我有以下代码: 我尝试了不同的组合和订单来设置更高的限制。但是目前每次我发送2kb的有效载荷,我都会得到一个413“(有效载荷太大)”的错

-

带Zookeeper的负载平衡器

这意味着Zookeeper将负载均衡器理解为一个客户机,并与之建立联系。但是负载均衡器只是ping TCP2181就出来了。

-

12. 作为负载均衡器

1. 介绍 众所周知,nginx是以高并发和内存占用少出名,它是一个http服务器,也是反向代理服务器,它更是负载均衡器。作为负载均衡器,在版本1.9之前,它只能作为http的负载均衡,也就是在网络模型的第七层发挥作用,1.9之后,它可以对tcp进行负载均衡,比如redis,mysql等。 nginx的负载均衡是出了名的简单,它跟反向代理的功能是紧密结合在一起的。比如下面是我网站上的一段配置: u

-

LBaaS(负载均衡即服务)

负载均衡即服务(Load Balance as a Service,LBaaS)是一项网络高级服务。 顾名思义,它允许租户动态的在自己的网络创建一个负载均衡设备。 负载均衡,可以说是分布式系统中比较基础的组件,它接收前端过来的请求,然后将请求按照某种均衡的策略转发给后端资源池中的某个处理单元,以完成处理。进而可以实现高可用性和横向的扩展性。 OpenStack Neutron 通过高级服务扩展的形

-

Camel 负载平衡中间件

Camel 负载平衡中间件Camel 是大众点评开发的软负载一体解决方案,承担了F5四层硬负载后的软负载工作。Camel已成为大众点评网络流量中必不可缺的一层。

-

3. Linux网络 - 负载均衡

lvs Linux Virtual Server (lvs) 是Linux内核自带的负载均衡器,也是目前性能最好的软件负载均衡器之一。lvs包括ipvs内核模块和ipvsadm用户空间命令行工具两部分。 在lvs中,节点分为Director Server和Real Server两个角色,其中Director Server是负载均衡器所在节点,而Real Server则是后端服务节点。当用户的请求到

-

AWS将经典负载平衡器迁移到应用程序负载平衡器

我希望在现有的服务器设置中集成WAF,因为我有经典的负载平衡器(带有EC2实例),它不支持WAF,我需要迁移到应用程序负载平衡器。 是否可以在不更改DNS(记录)的情况下将现有的经典负载平衡器迁移到应用程序负载平衡器?