《kafka》专题

-

无法连接在docker中运行的Kafka

我在docker compose yml文件中为广告侦听器配置了以下配置 警告O.apache.kafka.clients.networkclient-获取相关id为1的元数据时出错:{foo=leader_not_available} 主机可以从我的机器ping,因为它都在同一个网络中,没有防火墙问题。在docker容器中使用命令时,可以看到相同的主机名。我是不是漏掉了什么?

-

Kafka客户端无法接收消息

我在远程机器上设置了Kafka和动物园管理员。在那台机器上,我可以看到下面使用官方网站上的测试方法工作。 但是当我使用本地消费者脚本时,它就不起作用了: 我试着把它改成: 然后运行客户端使用者脚本,它会给出错误: [2017-08-11 15:49:01,591]获取相关id为3的元数据时警告错误:{listings-incoming=leader_not_available}(org.apach

-

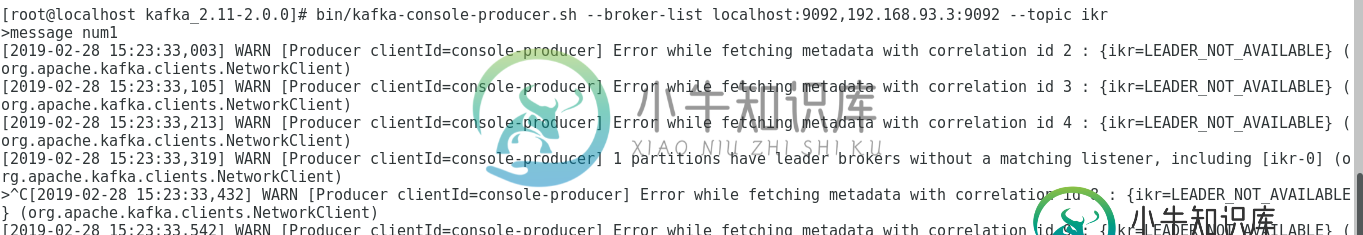

多节点中的Kafka集群配置

多节点中的Kafka集群配置我需要在不同的机器上配置一个Kafka集群,但它不起作用,当我启动生产者和消费者时,将显示以下错误: 你能帮帮我吗。

-

在码头化的环境中无法从烧瓶连接到Kafka

我试图建立一个Flask应用程序,有Kafka作为一个界面。我使用了一个Python连接器,kafka-python和一个用于Kafka的Docker图像,Spotify/KafkaProxy。 下面是docker-compose文件。 我能够从烧瓶容器运行,并从Kafka容器获取数据包。 当我在本地运行Flask应用程序时,试图通过设置连接到Kafka容器,它可以正常工作。

-

阿尔帕卡Kafka消费者抵销

但是,consumer只从主题中第一个未提交的消息开始轮询。我希望总是从偏移量0开始,不管提交的消息是什么。使用Alpakka消费者,如何手动指定偏移量?

-

利用kafka和cassandra进行事件来源的类别预测

> 聚合命令处理程序基本上是一个kafka使用者,它使用与某一主题相关的消息: 1.1当它接收到命令时,它会加载聚合的所有事件,并为每个事件重放聚合事件处理程序,以使聚合达到当前状态。 1.2根据命令和businiss逻辑,它将一个或多个事件应用到事件存储区。这涉及到将新事件插入到Cassandra中的事件存储表中。事件被标记为聚合的版本号--对于新的聚合,从版本0开始,这使得预测成为可能。此外,

-

kafka消息的节俭序列化-每个结构单主题

我计划使用kafka作为事件来源的持久日志,目前正在研究不同的序列化选项。我目前的重点是使用thrift对我将存储在Kafka中的消息进行序列化和反序列化。

-

作为Spring云数据流的一部分部署的Spring云函数应用程序的Kafka主题名称错误

我有一个简单的SCDF流,如下所示: http--端口=12346 | mvmn转换|文件--名称=tmp。txt--目录=/tmp mvmn变换是一个简单的自定义变压器,如下所示: 这很好用。 但我读到,Spring云函数应该允许我实现这样的应用程序,而无需指定绑定和转换器注释,所以我将其更改为: 现在我有一个问题-Spring云函数显然忽略了SCDF源和目标主题名称,而创建了主题和。 SCDF

-

基于Kafka的事件源并发写

我一直在考虑使用Apache Kafka作为事件源配置中的事件存储。发布的事件将与特定的资源相关联,传递到与资源类型相关联的主题,并按资源ID分片到分区中。因此,例如,创建类型为Folder和id 1的资源将产生一个FolderCreate事件,该事件将通过在主题中的分区总数中对id 1进行分片来传递到给定分区中的“Folders”主题。即使我不知道如何处理使日志不一致的并发事件。 最简单的场景是

-

Apache Kafka中的Eventsourcing

但是对于事件源,您很可能希望读取给定实体/聚合ID的事件。当然,您可以使用分区,但这似乎滥用了这个概念,而且很难实际添加新实体,因为分区计数更多的是静态的,即使您可以更改它。有什么明智的解决办法吗?Apache Kafka文档本身只简单地提到了事件来源。

-

kafka作为事件源系统中的事件存储库

这个问题类似于将Kafka用作CQRS EventStore。好主意?,但更具体的实现。当我有数千个事件“源”(DDD中的聚合根)时,如何使用kafka作为事件存储?正如我在链接问题和其他一些地方读到的,我会有每个来源的主题的问题。如果我将事件按类型拆分到主题中,它将更容易使用和存储,但我需要访问特定源的事件流。如何用Kafka做事件来源?

-

kafka中每个聚合根事件的单个或多个主题(流)

-

Apache Kafka持久化所有数据

我见过(旧?),我一直在考虑使用压缩键,但是对于kafka来说,是否有一个简单的选项可以永远删除消息? 或者最好的选择是给保留期一个可笑的高值?

-

Apache Kafka:在主题中重播消息

-

Kafka connect是否必须使用架构注册表?

当我尝试在没有模式注册表的情况下运行Kafka时, 我遇到一个错误,如需要CONNECT\u VALUE\u CONVERTER\u SCHEMA\u REGISTRY\u URL。命令[/usr/local/bin/dub sure CONNECT\u VALUE\u CONVERTER\u SCHEMA\u REGISTRY\u URL]失败! 设置kafka connect是否必须使用架构注