《stream》专题

-

需要关于Spring Boot Kafka Stream Binder应用程序错误的建议

我试图运行一个Spring boot Kafka流示例https://cloud.spring.io/spring-cloud-stream-binder-kafka/spring-cloud-stream-binder-kafka.html#_usage_2地点 我能够成功地构建它。但在运行时,出现如下所示的错误(java.lang.IllegalStateException:org.sprin

-

如何更改@KafkaStreamsStateStore kafka Stream Cloud的默认服务器

如何更改@kafkastreamssstatestore的默认serdes?我知道,在Kafka流云的新版本3.0.1中,方法如下所述:https://cloud.spring.io/spring-cloud-static/spring-cloud-stream-binder-kafka/3.0.1.RELEASE/reference/html/spring-cloud-stream-binder

-

如何将“Kafka Streams Binder”与“Functional Style”和DI结合使用?

https://cloud.spring.io/spring-cloud-static/spring-cloud-stream-binder-kafka/3.0.0.M3/reference/html/spring-cloud-stream-binder-kafka.html#_programming_model显示了一个示例,其中可以使用属性设置输入主题。 现在我想使用依赖注入,例如。 启动应用

-

使用Spring Cloud Streams时如何在代码中设置Kafka Streams属性?

在使用Kafka的Spring Boot中,我可以如下设置ConsumerFactory的属性: } 使用Kafka Streams,我可以在代码中设置属性,如下所示: 使用Spring Cloud Streams和Kafka Streams时,所有属性似乎仅通过应用程序输入。属性或应用程序。资源文件夹中的yml文件,如 在将Spring Cloud Streams与Kafka Streams一起

-

以编程方式暂停Spring Cloud Stream Kafka活页夹

我在Spring Boot应用程序上工作,它使用Spring Cloud Stream与Kafka集成。 我需要以编程方式暂停接收来自Kafka的消息。我知道通过执行器endpoint(文档)管理绑定生命周期的可能性。所以我可以自动装配并使用它的公共方法。但在我看来有点奇怪... 是否有更好的方法以编程方式管理绑定的生命周期?

-

如何实现Kafka消费者使用Spring-cloud-stream按需处理事件?

我正在尝试实现一个PollableConsumer,当我在SpringBoot应用程序中遇到endpoint时,它会在特定条件下开始轮询来自Kafka的消息。 在特定条件下,我尝试了多种触发民意调查的方法,但显然,只有当它不断地从Kafka主题进行民意调查时,它才会起作用。(就像spring cloud stream文档中的所有示例一样) 我正在寻找这样的东西: 当我碰到这样的endpoint时可

-

如果在处理步骤中出现故障,如何使Spring cloud stream Kafka streams binder重试处理消息?

我正在使用Spring Cloud Stream制作Kafka流。在消息处理应用程序中,可能会产生错误。因此,不应再次提交和重试消息。 我的申请方法- 这里,如果DAO insert方法失败,则不应将消息发布到输出主题,并应重试处理同一消息。 我们如何配置kafka streams binder来执行此操作?。非常感谢您的帮助。

-

执行器指标中未显示Spring Cloud stream kafka指标|Springboot2.2.2|SpringCloud Hoxton. SR4

我没有看到使用执行器的kafka消费者/生产者指标 /actuator/metrics.只显示了基本的jvm指标。 我的应用程序工作正常,绑定看起来也可以,在 /actuator/bindings.可见 下面是我的流配置 下面是我的配置。yml公司 我使用的是SpringBoot 2.2.2。发布,SpringCloud Hoxton。SR4和spring cloud stream活页夹kafka

-

如何通过YAML中的Spring Cloud Stream提供Kafka Streams属性?

我想移动在下-这可能吗?我想到了类似于或,但它不起作用。

-

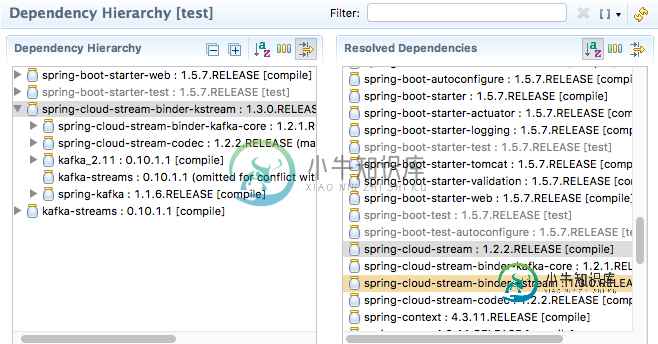

sping-cloud d-stream-binder-kstream-1.3.0: IllegalAccessError无法访问其超级接口

sping-cloud d-stream-binder-kstream-1.3.0: IllegalAccessError无法访问其超级接口尝试使用spring-cloud-stream-binder-kstream 1.3.0。发布版本 pom。xml: 日志跟踪: 配置类: application.properties: 附注:注意同样的事情适用于1.0.0。BUILD-SNAPSHOT在此存储库中共享https://github.com/mbogoevici/spring-cloud-stream-binder-kstream

-

获取使用StreamBridge处理kafka消息的分区和偏移量

我需要打印/记录/存储处理消息的kafka分区和偏移量。我如何才能做到这一点?我使用StreamBridge从制作人那里发送消息,还使用功能性spring kafka streams方法

-

Spring-kafka和Apache-Kafka-Streams-Binder在与Kafka Stream API的交互方面有什么区别?

我的理解是spring-kafka是为了与Kafka Client API交互而创建的,后来,spring-cloud-stream项目是为了“构建与共享消息系统连接的高度可扩展的事件驱动微服务”而创建的,该项目包括几个绑定器,其中一个是允许与Kafka Stream API交互的绑定器: 所以我很清楚,如果我想与Kafka流API交互,我将使用Spring-Cloud-Stream方法和适当的绑

-

Spring Cloud Stream Kafka活页夹配置在运行时更新

我正在使用Spring云流和Kafka绑定器使用SASL连接到Kafka集群。SASL配置如下所示: 我想以编程方式/在运行时更新用户名和密码,如何在Spring Cloud Stream中使用Spring Kafka binders做到这一点? 旁注:使用BinderFactory,我可以在其hashmap中看到这些配置,但我想知道如何在运行时更新配置,以便这些更改也反映在连接中?

-

Spring Cloud Stream Rabbit Binder,单消息源,具有分布在数据中心的云代工实例

我正在使用Spring Cloud stream发布者将分区的Rabbit MQ队列设置为30个分区。消费者部署在Cloud-oundry中。 这需要30个云铸造中的消费者应用程序实例,我想将这些实例分布到2个数据中心。所以我在一个数据中心启动了15个实例,在第二个数据中心启动了其他15个实例 我期望每个实例连接到0-29分区(一个分区得到一个实例),但2个实例(每个数据中心各一个)连接到0到14

-

Spring cloud stream kafka在生产者端的交易

我们有一个使用Kafka的Spring-Cloud-Stream应用程序。要求是在生产者端,消息列表需要放在事务的主题中。同一应用中的消息没有消费者。当我使用spring启动事务时。云流动Kafka。粘合剂交易事务id前缀,我面临的错误是调度程序没有订阅服务器,并且从主题获得的分区总数少于配置的事务。应用程序无法在事务模式下获取主题的分区。你能告诉我是否遗漏了什么吗。明天我会发布详细的日志。 谢啦