《nginx》专题

-

AWS EKS上nginx入口控制器的多个副本

是否有任何问题要扩展到用于nginx-ingress-控制器部署? 所以控制器已经创建了具有许多副本的AWS Classic ELB-我们将拥有相同的(单个ELB)还是每个POD一个(因为PODS的数量会增加)? 我这样问的原因是,我正在基于EC2spot的AWS EKS集群内运行控制器,当EC2spot实例被AWS中断时,我会停机。

-

AWS EKS上kubernetes上的Nginx Ingress问题

AWS EKS上kubernetes上的Nginx Ingress问题我在EKS上运行服务已经有一段时间了,今天无意中删除了nginx入口。现在,当我尝试使用以下url中的入口控制器模板设置入口时,只需稍加修改: https://raw.githubusercontent.com/kubernetes/ingress-nginx/controller-v0.34.1/deploy/static/provider/aws/deploy-tls-termination.

-

Nginx入口控制器如何在库伯内特斯上工作?

具体来说,当我按照谷歌网站上的指示在GKE上设置nginx ingress时,为什么最终会有两个外部IP地址? 这两个IP地址用于LoadBalancer类型的入口资源和服务资源: 以下是我的想法: 这基本上就是我链接到的教程页面上的图表。因此,我希望负载平衡器是L4类型的,并且有一个外部IP(并且不需要花费任何金钱来使用!)。我希望入口(尽管其名称)没有外部IP,因为我用注释标记了它 谷歌应该承

-

如何通过云管理的kubernetes公开nginx,而不使用负载平衡器、helm等?

我正在尝试学习Kubernetes的基础知识,虽然我在本地玩过kubectl和minikube,但我想通过互联网在我可以访问的域上(例如,使用DigitalOcean管理的Kubernetes)展示基本的nginx docker映像。我的绊脚石似乎是所有与网络相关的(服务和入口控制器)。 然而,我也希望避免不得不增加大量的云资源,并且不需要使用太多的依赖项来从我这里抽象出问题,所以请不要使用负载平

-

EKS Ingress Nginx负载平衡器与WAF集成

我已经在AWS EKS集群上部署了Ingress Nginx。入口控制器和服务作为组件部署。因此,为Ingress Nginx控制器提供了AWS网络负载平衡器 流量通过入口控制器终止的NLB和TLS。 我想做的是将AWS WAF与入口集成。AWS ALB有一种方法,但是否有方法集成上述配置的WAF?

-

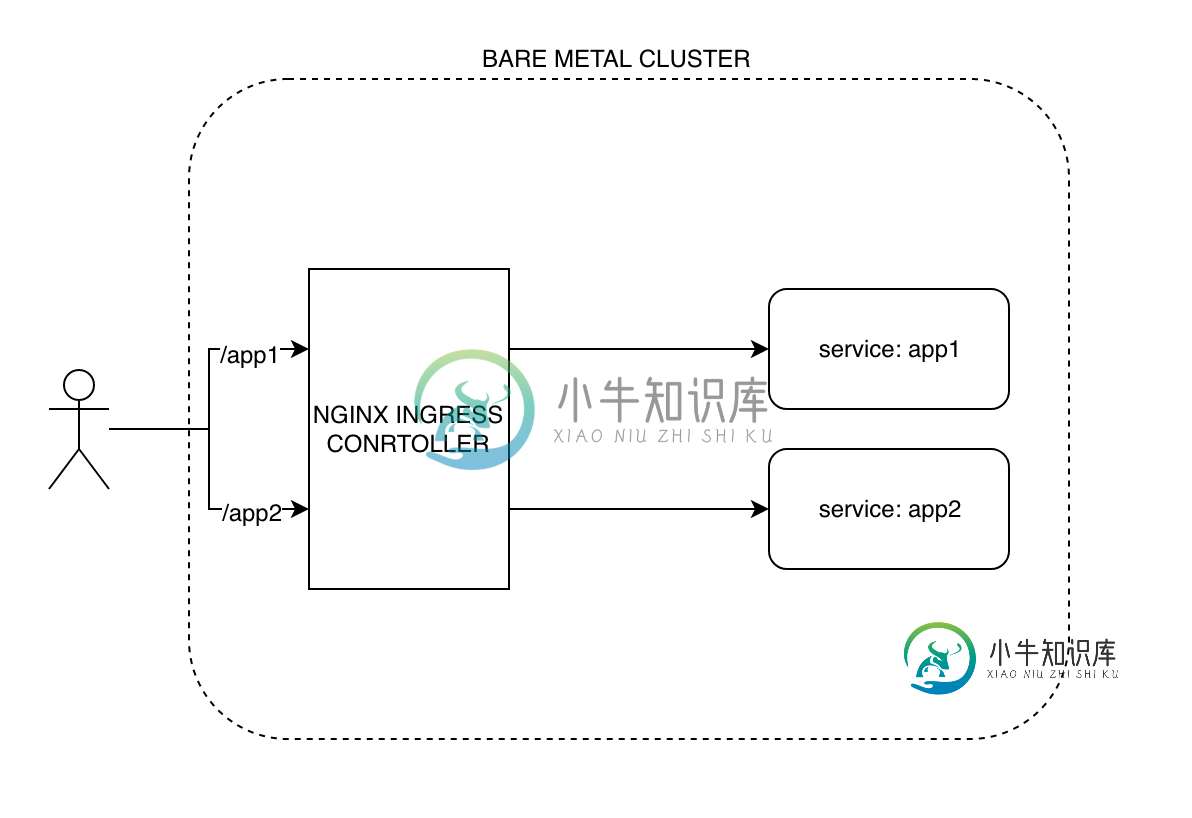

在ingress nginx控制器前使用负载平衡器

我很难理解与Ingress Nginx一起使用时负载平衡器的作用。 我知道负载平衡器在多个节点上分发请求。 i、 假设我有两个节点A和B,它们负责处理示例中的请求。com。 因此,负载均衡器将接受对的请求,并在定义的算法的帮助下在它们之间分配。 我也了解什么是API网关, i、 例如,我有一个订单服务和另一个支付服务,这样API网关将获得示例的请求。com,它将把订单请求移交给服务部门,将付款移交

-

如何使用nginx入口将流量从route53中的域转发到pod?

我用头盔部署了格拉法纳,现在它正在吊舱中运行。我可以访问它,如果我代理端口3000到我的笔记本电脑。我试图指向一个域,以便我可以从外部访问该pod。我在route53中有一个域,可以连接到负载平衡器(应用程序负载平衡器、网络负载平衡器、经典负载平衡器)。该负载平衡器可以将流量从端口80转发到端口80,再转发到一组节点(让我们稍后保留端口443)。我真的很难设置这个。我肯定少了些什么,但我不知道是什

-

为什么nginx入口控制器部署为容器(pod)?

我的自然想法是,如果nginx只是k8s节点上的守护进程,而不是k8s集群中的pod(容器),那么它看起来仍然可以填充入口控制器作业。因为:如果它是一个进程,因为它位于k8s节点上,它仍然可以与apiserver对话以获取服务后端POD信息,如IP地址,因此它仍然可以用作http代理服务器,将流量定向到不同的服务。 所以2个问题, 为什么nginx入口控制器必须是一个pod? 为什么nginx入口

-

更改Kubernetes nginx入口控制器端口

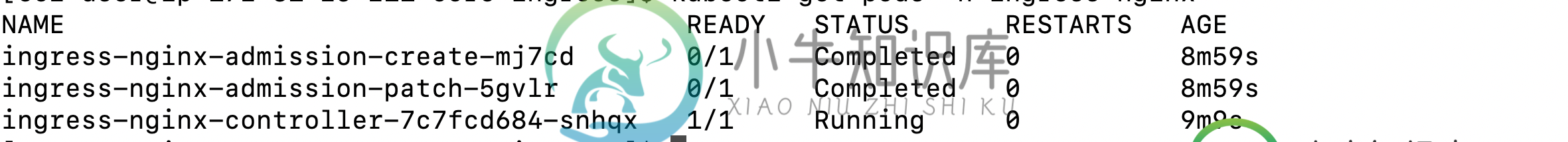

我在RedHat EC2实例上安装了Minikube v1.3.1以进行一些测试。 由于nginx-ingress-控制器默认使用的端口已经在使用中,我正在尝试在部署中更改它们,但没有结果。有人能建议如何做吗? 如何知道端口已在使用? 当我使用命令kubectl-n kube system get deployment | grep nginx列出系统吊舱时,我得到: nginx入口控制器0/1

-

组织会议的最佳方式是什么。在kubernetes集群内使用nginx反向代理的net core应用程序?

我想部署一个。在Azure库伯内特斯服务上使用NGINX反向代理的NET Core应用程序。组织pod和容器的最佳方式是什么? > 两个单容器吊舱,一个用于nginx,一个用于应用程序(.net core/kestrel),因此每个吊舱都可以独立扩展 一个多容器吊舱,这个吊舱有两个容器(一个用于nginx,一个用于app) 一个单集装箱吊舱,一个同时运行nginx和的集装箱。net应用程序 我会选

-

库伯内特斯-如何使用NodePort服务从集群外部访问nginx负载平衡

我有一个Kubernetes群集,它有一个主节点和两个其他节点: 它们中的每一个都在VirtualBox Ubuntu VM上运行,可从来宾计算机访问: 我部署了一个带有两个副本的nginx服务器,每个kubernetes-node-x有一个pod: 接下来,我将nginx部署的服务公开为节点端口,以便从集群外部访问它: 我可以直接使用节点IP访问节点中的每个pod 但是,我认为K8s提供了某种外

-

为什么要将负载平衡器类型的服务放在Nginx入口之前

我发现k8s在生产中的一些用法,这些用法与公共云一起使用,将负载均衡器类型的服务放在Nginx入口之前。(您可以从下面的yaml中找到一个示例。) 如我所知,入口可用于向公众公开内部服务,那么在入口前面放置负载均衡器有什么意义呢?我可以删除该服务吗?

-

如果我们使用的是nginx入口控制器,那么外部负载平衡器的作用是什么?

我已经将我的应用程序部署在一个由3个节点组成的集群中。现在为了使这个应用程序可以外部访问,我遵循了这个留档和集成的nginx入口控制器。 现在,当我查看我的Google负载平衡器控制台时,我可以看到一个新的负载平衡器被创建了,一切正常。但奇怪的是,我发现我的两个节点不健康,只有一个节点正在接受连接。然后我发现了这个讨论,并了解到运行nginx入口控制器pod的唯一节点对于负载平衡器来说是健康的。

-

K8S裸机nginx入口控制器

K8S裸机nginx入口控制器操作系统:RHEL7|k8s版本:1.12/13|kubes祈祷|裸机 我部署了一个标准的kubespray裸机集群,我正在尝试了解部署nginx ingress controller的最简单推荐方法是什么,它将允许我部署简单的服务。没有提供负载平衡器。我希望我的主公共IP作为我的服务的endpoint。 Github k8s ingress nginx建议将节点端口服务作为“强制”步骤,这似乎不

-

可能同时拥有l4和l7入口-nginx?

是否可以让ingress nginx使用一个ELB同时为l4和l7提供服务?我假设它不是基于以下注释: 我希望有人告诉我我错了;)