《提前批真的不会影响正式批吗》专题

-

C#批量插入数据到Sqlserver中的三种方式

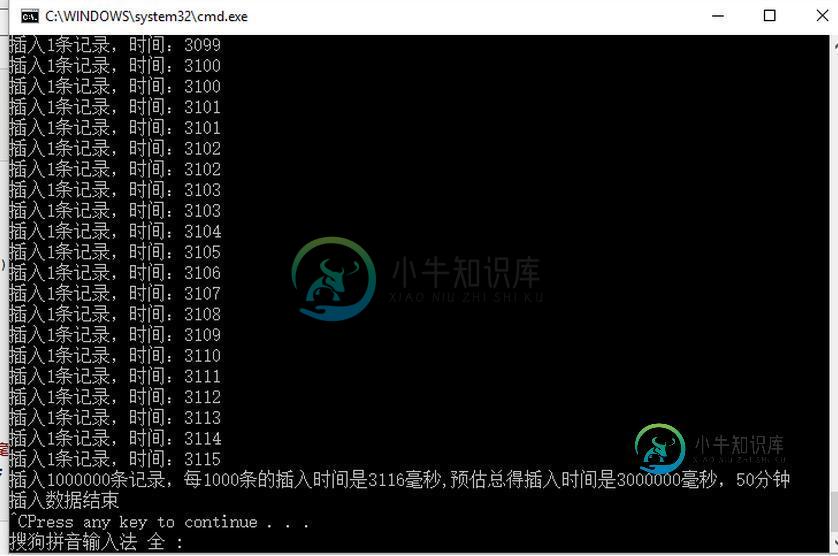

C#批量插入数据到Sqlserver中的三种方式本文向大家介绍C#批量插入数据到Sqlserver中的三种方式,包括了C#批量插入数据到Sqlserver中的三种方式的使用技巧和注意事项,需要的朋友参考一下 本篇,我将来讲解一下在Sqlserver中批量插入数据。 先创建一个用来测试的数据库和表,为了让插入数据更快,表中主键采用的是GUID,表中没有创建任何索引。GUID必然是比自增长要快的,因为你生成一个GUID算法所花的时间肯定比你从数据表

-

批量模式下春云流Kafka中的错误处理

我正在使用Spring Cloud Stream和Kafka Binder批量消费来自一个Kafka主题的消息。我正在尝试实现一个错误处理机制。根据我的理解,我不能在批处理模式下使用Spring Cloud Stream的< code>enableDLQ属性。 我找到了和,以重试并从spring-kafka文档发送失败消息。但我无法理解如何按照功能编程标准将记录发送到自定义DLQ主题。我看到的所有

-

使用python-pptx包批量修改ppt格式的实现

本文向大家介绍使用python-pptx包批量修改ppt格式的实现,包括了使用python-pptx包批量修改ppt格式的实现的使用技巧和注意事项,需要的朋友参考一下 最近实习需要对若干ppt进行格式上的调整,主要就是将标题的位置、对齐方式、字体等统一,人工修改又麻烦又容易错。 因此结合网上的pptx包资料,使用python脚本完成处理。 主要的坑点在于,shape的text_frame不能直接修

-

块处理模式下的Spring批处理事务回滚

-

azure宇宙图数据库批量导入的Json格式

我们计划将数据库迁移到Azure cosmos graph数据库。我们正在使用此批量导入工具。 它没有提到Json输入格式。 批量导入Azure cosmos graph db的Json格式是什么 https://github.com/Azure-Samples/azure-cosmosdb-graph-bulkexecutor-dotnet-getting-started azure 批量导入映

-

可靠的事件日志(不是真正的事件源)

我正在实现一个系统,它应该以一致的方式存储所有事件,但同时我希望通过使用某种混合方法来保持一致性。尽管事件来源的想法非常清楚--所有的突变都进入ES日志,然后消费者创建实体视图,但我最讨厌的是最终的一致性,因为系统现在是全系统异步的。 CQRS+ES方法建议在UI级别解决这个问题,要求客户机等待。假设,我有一些接近stackoverflow的东西。当我完成这个问题时,我会点击“发布你的问题”按钮,

-

标准化数据库会对资源产生什么影响?

问题内容: 从相对不规范的形式获取数据库并将其规范化时,人们可能期望资源利用率 发生 什么 变化 (如果有)? 例如,规范化通常意味着可以从更少的表中创建更多的表,这意味着数据库现在具有更多的表,但是其中许多表都非常小,可以使经常使用的表更好地适合内存。 表的数量越多,意味着(潜在地)需要更多的联接才能获取抽象出的数据,因此,人们可能会期望系统需要执行的联接数量越多,就会产生某种影响。 那么,标准

-

数据库(最大)字段长度是否会影响性能?

问题内容: 在我的公司中,我们有一个包含各种表的遗留数据库,因此包含许多字段。 许多字段似乎都有从未达到的大限制(例如:)。 是否将字段的最大宽度设置为最大宽度或比通常输入的字段大2到3倍会对性能产生负面影响? 一个应如何在性能与字段长度之间取得平衡?有平衡吗? 问题答案: 这个问题有两个部分: 在VARCHAR上使用NVARCHAR是否会损害性能?是的,将数据存储在unicode字段中会使存储需

-

Keras/TensorFlow批次标准化正在标准化什么

我的问题是批处理规范化(BN)正在规范化什么。 我在问,BN是单独标准化每个像素的通道还是一起标准化所有像素的通道。它是在每张图像的基础上还是在整个批次的所有通道上进行的。 具体而言,BN在X上运行。比如说,。因此,当轴=3时,它在“c”维度上运行,即通道数(对于rgb)或特征图数。 因此,假设X是rgb,因此有3个通道。BN是否做到了以下几点:(这是BN的简化版本,用于讨论维度方面。我知道gam

-

开始真正编程

通过对四则运算的学习,已经初步接触了Python中内容,如果看官是零基础的学习者,可能有点迷惑了。难道在IDE里面敲几个命令,然后看到结果,就算编程了?这也不是那些能够自动运行的程序呀? 的确。到目前位置,还不能算编程,只能算会用一些指令(或者叫做命令)来做点简单的工作。并且看官所在的那个IDE界面,也是输入指令用的。 列位稍安勿躁,下面我们就学习如何编写一个真正的程序。工具还是那个IDLE,但是

-

我的主要内容被页面上的某些东西影响了,不能正确地居中

在一个非常好的虽然是基本的教程之后,我的内容(页眉和页脚之间的文本)不会居中。 我尝试了很多关于响应图像框的教程(例如,连续3个,当调整到移动时,当你向下滚动时,它应该是1个1个),但我失败得很惨。直到现在,一切都很顺利,我感觉有更大的东西正在影响我的整个页面,我肯定这是很简单的很多人,但我哑然。 提前感谢任何能帮上忙的人,这简直要了我的命。 这是我的HTML(我正在为整个站点使用Dreamwea

-

python Django批量导入不重复数据

本文向大家介绍python Django批量导入不重复数据,包括了python Django批量导入不重复数据的使用技巧和注意事项,需要的朋友参考一下 本文为大家分享了python Django批量导入不重复数据的实现代码,供大家参考,具体内容如下 程序如下: 本文主要运用模型中exists()判断导入数据和数据库是否重复,如果不重复就用bulk_create批量导入数据库! 可对照参考我的另一篇

-

@PreAuthorize批注在Spring Security中不起作用

问题内容: 我发现了许多类似的问题,但都没有解决我的问题。我的问题是可以访问的功能 我的spring-security.xml代码如下。 当我添加 我的代码时显示找不到资源错误,并且当我删除我的代码时成功执行但可以访问函数 我的控制器功能是。 问题答案: 你应该有 如果您希望注释起作用。 回答评论: 看来您缺少依赖性。 如果您正在使用Maven,则需要: 如果没有,你可以从这里拿到罐子。

-

此位置不允许使用批注@EventListener

我已经编写了这个类以及EventListener注释和一个triggerMail方法—— 但是,在eclipse ide中,它给出了错误此位置不允许注释@EventListener和参数triggerMail的非法修饰符;只允许最终。 如何解决此问题?请帮助。

-

spring批处理不处理所有记录

我正在使用spring批处理使用RepositoryItemReader从postgresql DB读取记录,然后将其写入主题。我看到大约有100万条记录需要处理,但它并没有处理所有的记录。我已经将reader的pageSize设置为10,000并且与提交间隔(块大小)相同