《传音控股》专题

-

语音到文本大型音频文件[Microsoft语音API]

使用Microsoft语音API转录中/大型音频文件(每个文件约6-10分钟)的最佳方式是什么?比如批量音频文件转录? 我使用了https://docs.microsoft.com/en-us/azure/cognitive-services/speech-service/speech-to-text-sample中提供的代码,用于连续转录语音,但它在某个时候停止转录。转录有任何限制吗?我只使用免

-

音频分析:频率与音高

问题内容: 我正在设计一个简单的调谐器,所以我的目标是显示音符名称(A,B,F#)以及理论声音和实际输入之间的 距离( 以分为单位)。 我是音频和信号处理的新手,所以我做了一些研究,发现 了一个 叫做快速傅立叶变换 的东西 ,它可以分析字节并给我频率。另外,我发现了一些Java库,例如通用数学和JTransforms,所以我不会自己编写硬代码。 我相信就这样,因为每个范围的频率都可以以相同的气质直

-

Android5.1中的语音通话录音

我有一个应用程序whcih记录传入和传出语音呼叫,它在Marshmallow或更高版本的设备上运行良好versions.But当我尝试在android 5.1.1上运行它时,它给我错误,应用程序停止响应。 我用于录制语音通话的代码是 - 编辑-我按照下面的回答做了,但是错误仍然存在。通过稍微调整代码,调用状态现在只被调用一次,但应用程序仍然崩溃,甚至异常也是一样的。

-

在Xamarin.Forms中播放音频/声音

问一下Xamarin.Forms便携里面Xamarin.Forms的音频怎么播放 正如我所知,有依赖服务,我看到了一些示例,只有iOS和Android,但没有Windows Phone 8.1/Windows 8.1和UWP。

-

在ASP.NET文件上传控制上使用Selenium WebDrive C#自动化文件上传

我有一个ASP。NET文件上载控件,当您单击上载按钮选择要上载的文件时,该控件将打开一个窗口。但问题是,网络驱动程序无法识别窗口,因此无法选择要上载的文件。 我在stackoverflow中找到了许多使用sendkey输入文件路径的解决方案。我认为当你有html文件上传控制时,这是有效的。在我的情况下,我有ASP。NET文件上传控件,它没有文本框,我可以在其中使用sendkey输入文件路径。 我该

-

通过我自己的应用程序控制android音乐播放器

我想写一些应用程序来控制android音乐播放器:)例如,当我摇动手机时-

-

在Android Studio中发送开放声音控制(OSC),套接字错误

我尝试在android studio中使用OSC,随后在http://courses.ideate.cmu.edu/physcomp/f14/16-223/tutorial-android-osc-communication/.它使用来自Illposed的JavaOSC。 然而,当我创建一个新的OSCPortOut时,我遇到了一个套接字异常错误。你能告诉我这里发生了什么吗?如何解决这个问题。 An

-

从android应用程序发送OSC(开放式声音控制)消息

我正在写一个Android应用程序使用SDK为Android 4.0 我想知道android SDK中是否有用于发送OSC消息(开放声音控制)的API,或者我应该只使用java OSC SDK。 我试着浏览网页http://opensoundcontrol.org/introduction-osc在实现中,我发现了以下几点:http://www.illposed.com/software/java

-

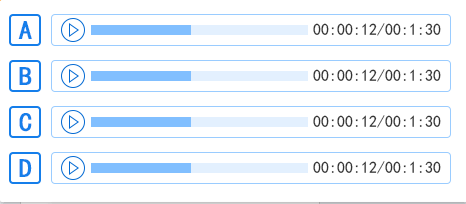

有没有其他方法实现特定样式的音频控件?

有没有其他方法实现特定样式的音频控件?audio的样式是否能改成这样的? 有没有别的办法可以改成这种样式的音频控件,audio好像没法改成这中,有别的方法吗

-

流式传输音频时UDP数据包大小/延迟权衡?

我正在构建一个通过udp在线传输实时音频的应用程序,我希望最小化延迟。音频以其生成的速度发送,这意味着生成一秒钟的音频需要一秒钟,发送速度不能超过音频速率。 我最初的想法是发送压缩音频的小数据包,以便客户端可以尽快开始播放。使用Opus编解码器,我应该能够发送5毫秒的音频数据包(最低2.5毫秒),这意味着用户可以很快开始播放,比如说在发送了2个这样的数据包之后。 然而,当使用如此小的分组大小时,会

-

将录制的音频从浏览器流传输到服务器

问题内容: 我想将录制的音频从浏览器实时流传输到服务器并播放。该服务器最终将成为播放这些音频流的嵌入式设备。 到目前为止,我已经成功地录制了音频并将其编码为WAVE文件,并使用网络音频API并按照本教程在浏览器上播放。 现在,我有了.WAV编码的Blob流。我试图找到通过Web套接字连接将其流式传输到Node.js后端并使用npm模块播放它们的方法。但是我没有运气。 有人知道我应该遵循的任何资源或

-

我想通过视频js流式传输. m3u8格式的音频

我正在开发一个可以流式传输. m3u8播放列表(HLS播放)中的音频流的项目。我正在为上述目的使用Videojs。当我使用. m3u8和(. ts)格式的视频时,一切都很顺利。这些流在所有主要浏览器中播放。代码如下: 和html格式 该代码适用于包含<代码>位的HLS。ts视频流。 现在,我的流提供程序通过给我

-

在外部蓝牙设备和Android手机之间传输音频

我正在考虑构建一个Android应用程序,允许通过蓝牙将音频流式传输到Android手机。我以前在Stackoverflow上读过类似的问题,根据我的理解,A2DP不能用,因为Android不能成为A2DP接收器。 理论上,我认为HFP或HFP AG等配置文件应允许双向音频流。在Android API中,有没有办法强制蓝牙配对遵循此配置文件,或者操作系统是否决定使用哪种配置文件(例如仅当有电话呼叫

-

将动态json对象传递给C#MVC控制器

问题内容: 我正在使用.Net 4,MVC 3和jQuery v1.5做一些工作 我有一个JSON对象,它可以根据调用它的页面而改变。我想将对象传递给控制器。 我了解如果我创建一个自定义模型,例如 并在我的控制器中使用它,例如 并使用jQuery的.ajax方法传递对象,如下所示: 这工作正常,我的JSON对象已映射到我的C#对象。我想做的是通过一个可能更改的JSON对象。当它更改时,我不需要

-

ASP.NET MVC使用AJAX将模型传递给控制器

问题内容: 我试图通过ajax调用将模型传递给控制器。 我已经看过Laviak在以下问题中提供的答案,但无法使其正常工作。 运行ajax调用时,MODEL变量出现未定义的错误。我已经确认正在调用助手类,并且正在返回字符串。是否因为AJAX调用位于.js文件中?为什么未定义? 我的代码: Site.Master: 助手类: Javascript文件: 动作方法: 问题答案: 确保在主文件中定义变