node.js - Node.js MySQL2依赖包, 同步插入大量数据时为何只插入了部分数据且没有报错是什么情况?

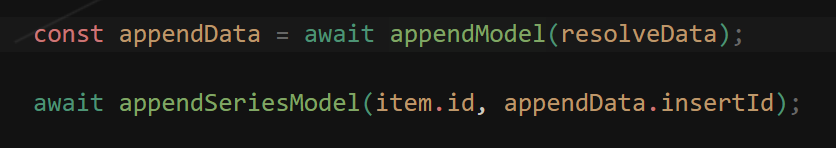

nodejs mysql2的依赖包, 5w数据, for 循环插入, 然后我需要获取插入的 成功的 自增id 来 进行另一个操作, 但是执行完 直插入了 2w不到, 也没有报错 是什么情况导致的? 我是 同步执行 插入的

查询网上 基本 都是 一次性插入 大量数据, 我主要想知道我这个情况是因为什么 这种方式有 优化方案吗

共有1个答案

在Node.js中使用MySQL2库进行大量数据的同步插入时,遇到只插入了部分数据且没有报错的情况,通常与以下几个因素有关:

- 数据库连接超时:如果数据库连接在长时间的操作中没有得到响应,可能会因为超时而被关闭。虽然MySQL2库默认有连接池管理,但在极端情况下(如网络延迟、数据库负载过高等),仍有可能发生。

- 事务超时或限制:如果你是在一个事务中执行这些插入操作,事务可能因为达到某个超时限制或资源限制而被中断。

- 内存限制:Node.js进程本身或MySQL服务器可能因为处理大量数据而耗尽内存,导致操作被中断或执行缓慢。

- 数据库锁:如果数据库表被其他操作锁定(如长时间运行的事务、锁表查询等),你的插入操作可能会被阻塞或延迟。

- 代码逻辑问题:虽然你提到是同步执行,但代码中可能存在逻辑错误,导致循环提前终止或数据未正确发送到数据库。

优化方案

批量插入:

使用批量插入(Bulk Insert)而不是单条记录插入。MySQL2支持通过执行一个包含多条INSERT语句的查询来批量插入数据。这可以显著减少网络往返次数和数据库操作次数。const sql = 'INSERT INTO table_name (column1, column2) VALUES ?'; const values = [ [value1a, value1b], [value2a, value2b], // 更多值... ]; connection.query(sql, [values], function (error, results, fields) { if (error) throw error; // 处理结果 });- 调整数据库配置:

增加数据库连接超时时间、事务超时时间等配置,确保不会因为超时而中断操作。 - 使用事务:

如果数据之间有依赖关系,确保使用事务来保持数据的一致性。但注意事务也可能因为资源限制而失败。 - 监控和日志:

增加日志记录,监控数据库操作的状态和性能,以便在出现问题时能够快速定位原因。 - 异步处理:

虽然你提到需要同步执行,但考虑到性能和资源利用,使用异步方式(如Promise.all或async/await)来并发处理多个插入操作可能更为合适。这可以减少主线程的阻塞时间,提高整体性能。 - 检查数据库锁:

确保没有其他操作(如长时间运行的事务)锁定了你的表或行。 - 分批处理:

如果数据量非常大,考虑将数据分批处理,每批处理一定数量的数据,并在每批处理完成后进行必要的检查和清理工作。

通过上述方法,你应该能够解决只插入了部分数据且没有报错的问题,并优化你的数据插入性能。

-

我创建了一个向MySql数据库插入数百万个值的程序。我读到过有关批插入的文章,它将优化我的程序并使其更快,但当我尝试这样做时,它以同样的方式工作。我没有将每个值插入数据库,而是每次将500个值保存在一个列表中,然后将它们插入一个大循环中,如下所示: 然后我删除列表中的所有值,并再次开始收集500个值。它不应该工作得更好吗? 我的插入代码是: 我有一些问题: 1。为什么当我批量插入时它不能更快地工作

-

问题内容: 在我的代码中,用户可以上传一个excel文档,希望其中包含电话联系人列表。作为开发人员,我应阅读excel文件,将其转换为dataTable并将其插入数据库。问题是某些客户拥有大量的联系人,例如说5000个和更多的联系人,而当我尝试将这种数据量插入数据库时,它崩溃了,并给了我一个超时异常。避免这种异常的最佳方法是什么?它们的任何代码都可以减少insert语句的时间,从而使用户不必等

-

我是cassandra db的新手,我试图将数据从csv文件导入到cassandra中,我执行了以下命令,要导入表,首先我使用 谢谢!非常感谢您的帮助!

-

在JPA中,是否有任何方法可以在DB中批量插入数据,并且只有在DB中不存在数据时才插入数据。当我尝试批量插入时,由于唯一键约束,它抛出异常。我想插入数据库中不存在的所有记录,其余的应该跳过。 组织。springframework。刀。DataIntegrityViolationException:无法执行语句;SQL[n/a];约束[reference_number_master_id_key];

-

我的数据库代码是这样的。 出现成功保存的消息,但在数据库中找不到该值。请告诉我为什么会这样?