如何让我的Google Cloud负载均衡器工作?

我遵循文档创建基于内容的负载平衡:https://cloud.google.com/load-balancing/docs/https/content-based-example

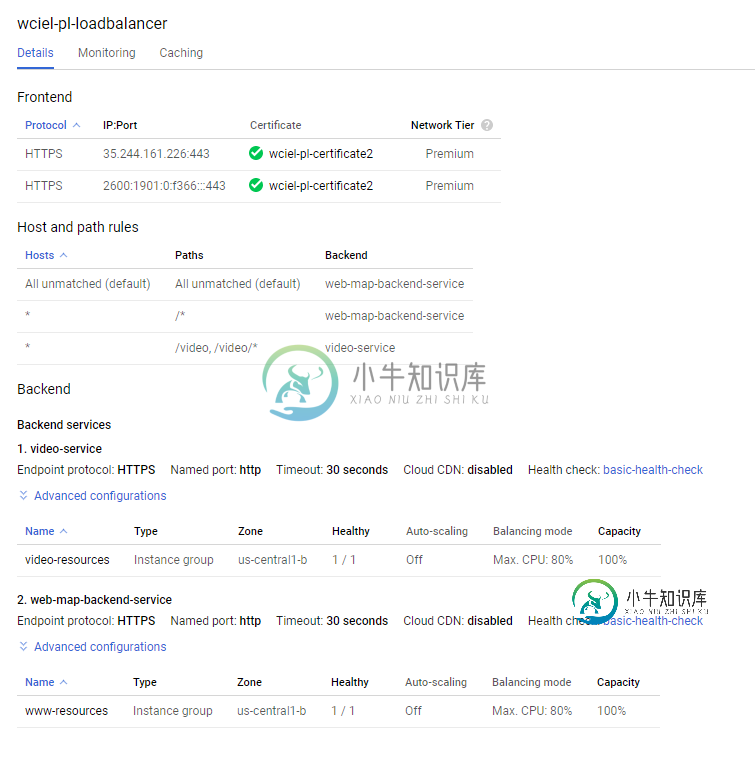

我想通过https访问外部地址。我希望负载平衡器使用简单的http连接到VM。

这两个虚拟机都按预期工作,并且在IP地址到达时返回正确的answet。LB的设置似乎很好。两个运行状况检查均通过,并且Google SSL证书处于活动状态。

然而,当我尝试访问负载平衡器的IP地址或域时,我得到502。

LB IP35.244.161.226wciel.pl

负载平衡器的日志显示状态详细信息:“failed\u to\u connect\u to\u backend”

我连接了我的谷歌云控制台的屏幕。

请给出建议。

me@machine:$ gcloud beta compute ssl-certificates list

NAME TYPE CREATION_TIMESTAMP EXPIRE_TIME MANAGED_STATUS

wciel-pl-certificate2 MANAGED 2019-08-11T03:20:15.971-07:00 2019-11-09T01:27:44.000-08:00 ACTIVE

www.wciel.pl: ACTIVE

共有1个答案

我认为后端服务配置不匹配。从web-map-backend-service的详细信息来看,您的服务似乎正在监听端口80。但是,当您配置后端服务时,您已经使用端口443配置了它。

如果您不需要LB到VM之间的安全通信,我建议您:

>

编辑后端端口号从443到80

保存并更新配置。

-

负载均衡(Load balancing)是一种计算机网络技术,用来在多个计算机(计算机集群)、网络连接、CPU、磁盘驱动器或其他资源中分配负载,以达到最佳化资源使用、最大化吞吐率、最小化响应时间、同时避免过载的目的。 使用带有负载均衡的多个服务器组件,取代单一的组件,可以通过冗余提高可靠性。负载均衡服务通常是由专用软体和硬件来完成。 负载均衡最重要的一个应用是利用多台服务器提供单一服务,这种方案有

-

负载均衡包括负载均衡实例、访问控制及证书。 实例 负载均衡实例是一个运行的负载均衡服务,通过设置的虚拟IP接收流量并将其转发分配给后端服务器。 访问控制 访问控制用于设置访问负载均衡的IP白名单或IP黑名单。 证书 当在负载均衡实例上配置HTTPS监听转发来自HTTPS协议的请求时,需要配置证书。

-

一个简单的负载均衡的示例,把www.domain.com均衡到本机不同的端口,也可以改为均衡到不同的地址上。> http { : upstream myproject { : server 127.0.0.1:8000 weight=3; : server 127.0.0.1:8001; : server 127.0.0.1:8002; : server 127.0.0.1:8003; : }

-

SOFARPC 提供多种负载均衡算法,目前支持以下五种: 类型 名称 描述 random 随机算法 默认负载均衡算法。 localPref 本地优先算法 优先发现是否本机发布了该服务,如果没有再采用随机算法。 roundRobin 轮询算法 方法级别的轮询,各个方法间各自轮询,互不影响。 consistentHash 一致性hash算法 同样的方法级别的请求会路由到同样的节点。 weightRou

-

我在ec2-Classic实例的前面有一个负载均衡器。我通过直接链接到我的负载均衡器的描述选项卡中列出的DNS名称值来检查负载均衡器是否正常工作。这给了我位于EC2实例上的网页主页。因此我的负载均衡器正在工作。我的负载均衡器和我的EC2实例在同一个可用区域。 我的负载平衡器设置了SSL证书,我有两个侦听器设置为将http(端口80)和https(端口443)作为http转发到实例端口80。我的EC

-

1. 介绍 众所周知,nginx是以高并发和内存占用少出名,它是一个http服务器,也是反向代理服务器,它更是负载均衡器。作为负载均衡器,在版本1.9之前,它只能作为http的负载均衡,也就是在网络模型的第七层发挥作用,1.9之后,它可以对tcp进行负载均衡,比如redis,mysql等。 nginx的负载均衡是出了名的简单,它跟反向代理的功能是紧密结合在一起的。比如下面是我网站上的一段配置: u