提取视频文件的h264部分(解混)

我正在尝试使用c中的ffmpeg将视频文件解复用到视频部分(h264、mpeg4、h265、vp8等)和音频部分(mp3、aac、ac3等)以及字幕部分(srt)中。

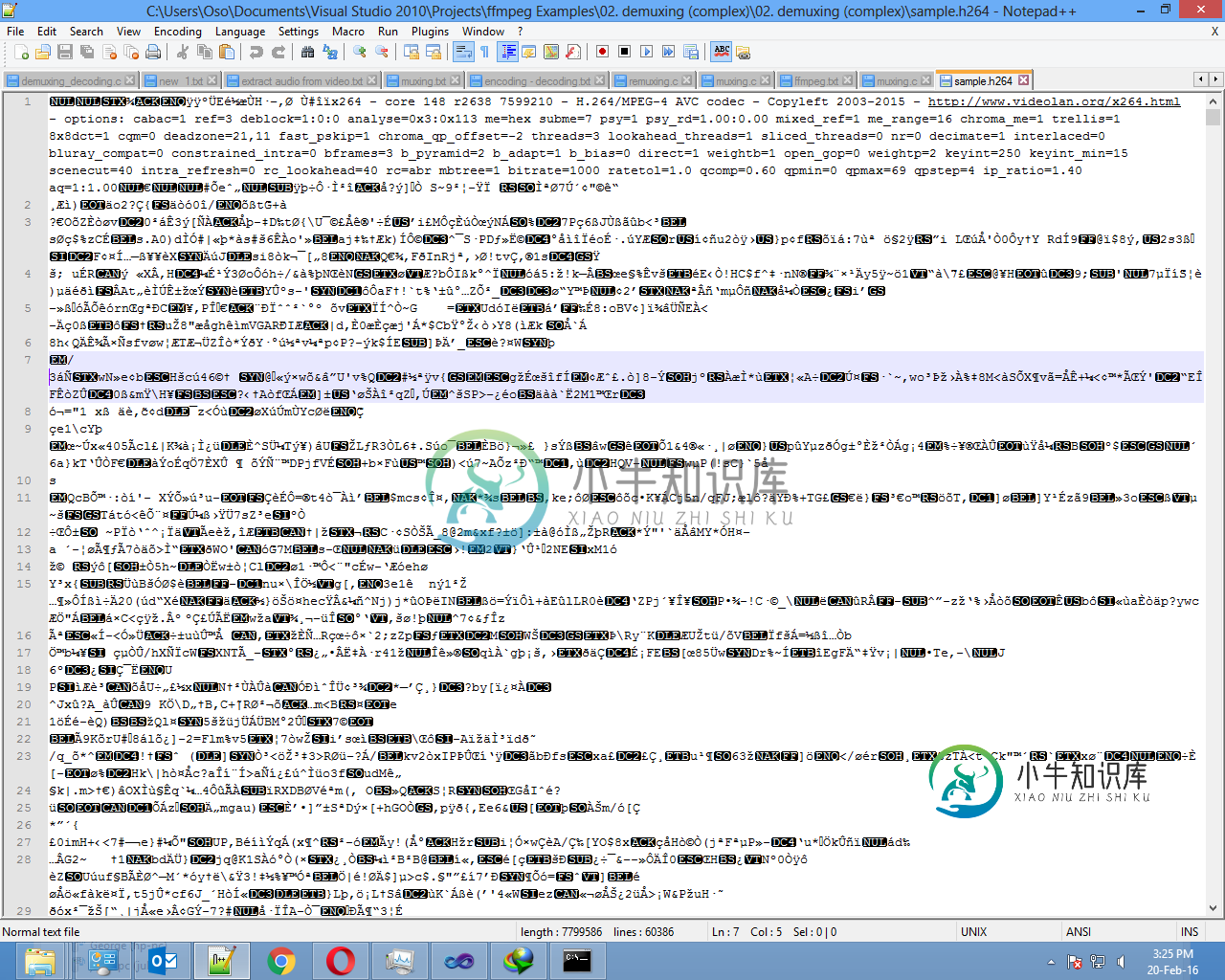

音频部分很好,并在我所有的媒体播放器上播放,字幕部分也一样。然而,视频部分没有出现错误,并保存到了。h264文件,但当我使用ffprobe检查它或ffplay播放它时,它总是给出错误“处理输入时发现无效数据”。

下面的代码

/* Separate a media file into audio, video and subtitle files (demuxing, complex) */

//TODO: mute error when subtitle is not present

#define __STDC_CONSTANT_MACROS

extern "C"

{

#include "libavformat/avformat.h"

}

int main()

{

//Input AVFormatContext and Output AVFormatContext

AVOutputFormat *ofmt_a = NULL, *ofmt_v = NULL, *ofmt_s = NULL;

AVFormatContext *ifmt_ctx = NULL, *ofmt_ctx_a = NULL, *ofmt_ctx_v = NULL, *ofmt_ctx_s = NULL;

AVPacket pkt;

int ret, i;

int videoindex=-1, audioindex=-1, srtindex=-1;

int frame_index=0;

//Input file URL

const char *in_filename = "sample.mp4";

//Output file URL

const char *out_filename_v = "sample.h264";

const char *out_filename_a = "sample.mp3";

const char *out_filename_s = "sample.srt";

av_register_all();

//Input

if ((ret = avformat_open_input(&ifmt_ctx, in_filename, 0, 0)) < 0) {

printf( "Could not open input file.");

goto end;

}

if ((ret = avformat_find_stream_info(ifmt_ctx, 0)) < 0) {

printf( "Failed to retrieve input stream information");

goto end;

}

//Output

avformat_alloc_output_context2(&ofmt_ctx_v, NULL, NULL, out_filename_v);

if (!ofmt_ctx_v) {

printf( "Could not create output context\n");

ret = AVERROR_UNKNOWN;

goto end;

}

ofmt_v = ofmt_ctx_v->oformat;

avformat_alloc_output_context2(&ofmt_ctx_a, NULL, NULL, out_filename_a);

if (!ofmt_ctx_a) {

printf( "Could not create output context\n");

ret = AVERROR_UNKNOWN;

goto end;

}

ofmt_a = ofmt_ctx_a->oformat;

avformat_alloc_output_context2(&ofmt_ctx_s, NULL, NULL, out_filename_s);

if (!ofmt_ctx_a) {

printf( "Could not create output context\n");

ret = AVERROR_UNKNOWN;

goto end;

}

ofmt_s = ofmt_ctx_s->oformat;

for (i = 0; i < ifmt_ctx->nb_streams; i++) {

//Create output AVStream according to input AVStream

AVFormatContext *ofmt_ctx;

AVStream *in_stream = ifmt_ctx->streams[i];

AVStream *out_stream = NULL;

if(ifmt_ctx->streams[i]->codec->codec_type==AVMEDIA_TYPE_VIDEO){

videoindex=i;

out_stream=avformat_new_stream(ofmt_ctx_v, in_stream->codec->codec);

ofmt_ctx=ofmt_ctx_v;

}

else if(ifmt_ctx->streams[i]->codec->codec_type==AVMEDIA_TYPE_AUDIO){

audioindex=i;

out_stream=avformat_new_stream(ofmt_ctx_a, in_stream->codec->codec);

ofmt_ctx=ofmt_ctx_a;

}

else if(ifmt_ctx->streams[i]->codec->codec_type==AVMEDIA_TYPE_SUBTITLE){

srtindex=i;

out_stream=avformat_new_stream(ofmt_ctx_s, in_stream->codec->codec);

ofmt_ctx=ofmt_ctx_s;

}

else{

break;

}

if (!out_stream) {

printf( "Failed allocating output stream\n");

ret = AVERROR_UNKNOWN;

goto end;

}

//Copy the settings of AVCodecContext

if (avcodec_copy_context(out_stream->codec, in_stream->codec) < 0) {

printf( "Failed to copy context from input to output stream codec context\n");

goto end;

}

out_stream->codec->codec_tag = 0;

if (ofmt_ctx->oformat->flags & AVFMT_GLOBALHEADER)

out_stream->codec->flags |= CODEC_FLAG_GLOBAL_HEADER;

}

//Dump Format------------------

printf("\n==============Input Video=============\n");

av_dump_format(ifmt_ctx, 0, in_filename, 0);

printf("\n==============Output Video============\n");

av_dump_format(ofmt_ctx_v, 0, out_filename_v, 1);

printf("\n==============Output Audio============\n");

av_dump_format(ofmt_ctx_a, 0, out_filename_a, 1);

/*printf("\n==============Output Subtitle============\n");

av_dump_format(ofmt_ctx_s, 0, out_filename_s, 1);*/

printf("\n======================================\n");

//Open output file

if (!(ofmt_v->flags & AVFMT_NOFILE)) {

if (avio_open(&ofmt_ctx_v->pb, out_filename_v, AVIO_FLAG_WRITE) < 0) {

printf( "Could not open output file '%s'", out_filename_v);

goto end;

}

}

if (!(ofmt_a->flags & AVFMT_NOFILE)) {

if (avio_open(&ofmt_ctx_a->pb, out_filename_a, AVIO_FLAG_WRITE) < 0) {

printf( "Could not open output file '%s'", out_filename_a);

goto end;

}

}

if (!(ofmt_a->flags & AVFMT_NOFILE)) {

if (avio_open(&ofmt_ctx_s->pb, out_filename_s, AVIO_FLAG_WRITE) < 0) {

printf( "Could not open output file '%s'", out_filename_s);

goto end;

}

}

//Write file header

if (avformat_write_header(ofmt_ctx_v, NULL) < 0) {

printf( "Error occurred when opening video output file\n");

goto end;

}

system("pause");

if (avformat_write_header(ofmt_ctx_a, NULL) < 0) {

printf( "Error occurred when opening audio output file\n");

goto end;

}

if (avformat_write_header(ofmt_ctx_s, NULL) < 0) {

printf( "Error occurred when opening audio output file\n");

goto end;

}

AVBitStreamFilterContext* h264bsfc = av_bitstream_filter_init("h264_mp4toannexb");

while (1) {

AVFormatContext *ofmt_ctx;

AVStream *in_stream, *out_stream;

//Get an AVPacket

if (av_read_frame(ifmt_ctx, &pkt) < 0)

break;

in_stream = ifmt_ctx->streams[pkt.stream_index];

if(pkt.stream_index==videoindex){

out_stream = ofmt_ctx_v->streams[0];

ofmt_ctx=ofmt_ctx_v;

printf("Write Video Packet. size:%d\tpts:%lld\n",pkt.size,pkt.pts);

av_bitstream_filter_filter(h264bsfc, in_stream->codec, NULL, &pkt.data, &pkt.size, pkt.data, pkt.size, 0);

}else if(pkt.stream_index==audioindex){

out_stream = ofmt_ctx_a->streams[0];

ofmt_ctx=ofmt_ctx_a;

printf("Write Audio Packet. size:%d\tpts:%lld\n",pkt.size,pkt.pts);

}

else if(pkt.stream_index==srtindex){

out_stream = ofmt_ctx_s->streams[0];

ofmt_ctx=ofmt_ctx_s;

printf("Write Subtitle Packet. size:%d\tpts:%lld\n",pkt.size,pkt.pts);

}

else{

continue;

}

//Convert PTS/DTS

pkt.pts = av_rescale_q_rnd(pkt.pts, in_stream->time_base, out_stream->time_base, (AVRounding)(AV_ROUND_NEAR_INF|AV_ROUND_PASS_MINMAX));

pkt.dts = av_rescale_q_rnd(pkt.dts, in_stream->time_base, out_stream->time_base, (AVRounding)(AV_ROUND_NEAR_INF|AV_ROUND_PASS_MINMAX));

pkt.duration = av_rescale_q(pkt.duration, in_stream->time_base, out_stream->time_base);

pkt.pos = -1;

pkt.stream_index=0;

//Write

if (av_interleaved_write_frame(ofmt_ctx, &pkt) < 0) {

printf( "Error muxing packet\n");

break;

}

//printf("Write %8d frames to output file\n",frame_index);

av_free_packet(&pkt);

frame_index++;

}

av_bitstream_filter_close(h264bsfc);

//Write file trailer

av_write_trailer(ofmt_ctx_a);

av_write_trailer(ofmt_ctx_v);

av_write_trailer(ofmt_ctx_s);

end:

avformat_close_input(&ifmt_ctx);

/* close output */

if (ofmt_ctx_a && !(ofmt_a->flags & AVFMT_NOFILE))

avio_close(ofmt_ctx_a->pb);

if (ofmt_ctx_v && !(ofmt_v->flags & AVFMT_NOFILE))

avio_close(ofmt_ctx_v->pb);

if (ofmt_ctx_s && !(ofmt_s->flags & AVFMT_NOFILE))

avio_close(ofmt_ctx_s->pb);

avformat_free_context(ofmt_ctx_a);

avformat_free_context(ofmt_ctx_v);

avformat_free_context(ofmt_ctx_s);

system("pause");

if (ret < 0 && ret != AVERROR_EOF) {

printf( "Error occurred.\n");

return -1;

}

return 0;

}

编辑2我认为“错误”与FFMPEG的“使用AVStream.codec.time_base作为混音器的时基提示已弃用。设置AVStream.time_base”错误。我恢复到较旧版本的FFMPEG,使用相同的代码,生成的h264文件是可以的!

共有1个答案

您需要将H.264比特流从长度前缀模式转换为起始代码前缀模式。这是某些流格式所必需的,通常是MPEG-2传输流格式(“mpegts”)。

看看https://www.ffmpeg.org/ffmpeg-bitstream-filters.html#h264_005fmp4toannexb

看402到424行和842到843行https://www.ffmpeg.org/doxygen/0.7/crystalhd_8c-source.html

我用它从mp4中提取h264。

//Use this filter on your first h264 input AVPacket

AVFormatContext *ifmt_ctx = NULL;

//...

//... //init input

//...

AVPacket *firstPacket;

//...

//... //get packet from stream

//...

uint8_t *dummy_p;

int dummy_int;

AVBitStreamFilterContext *filter = v_bitstream_filter_init("h264_mp4toannexb");

if (!filter)

{

printf("Can't open filter\n");

exit(1);

}

ret = av_bitstream_filter_filter(filter, ifmt_ctx->streams[videoindex]->codec, NULL,

&dummy_p, &dummy_int,

firstPacket->data, firstPacket->size, 0);

if( ret < 0 )

{

printf("Can't filter\n");

exit(1);

}

// use dummy_p to write to file, as first packet

-

使用Camtasia创建的视频可以通过导出TechSmith智能播放器的项目在网络上共享。该视频以“H264-MPEG-4 AVC(part10)(avc1)”编解码器导出,导出还包括TechSmith智能播放器使用的其他自定义XML、JavaScript和SWF文件。 这些自定义文件也会“烧录”到视频中。例如,在文本编辑器中打开MP4视频时,可以查看XML文件的内容。这允许其他服务在上传Camt

-

我正在尝试从视频文件中提取音频。我试过python中的moviepy、ffmpeg等库。提取的音频文件太大。对于大小为75 MB的音频文件,音频文件与moviepy的距离约为1.1 GB。即使比特率为16 kbps,采样率为16000 Hz,提取的文件大小也将达到200 MB。任何其他库或提取的音频文件大小至少相同或小于完整视频文件的方式。 我正在ffmpeg中使用上述命令。

-

我正在尝试获取关于h264位流中帧的信息。特别是宏块的运动矢量。我想,我不得不为它使用ffmpeg代码,但它真的很庞大,很难理解。那么,有没有人可以给我一些从h264流的单帧原始数据中进行部分解码的技巧或Exapms? 谢谢你。

-

应用程序创建的h264帧被发送到标准输出,在标准输出中,使用ffmpeg将该流重新复用为mp4,并将其传递给服务器,服务器根据请求将其传递给客户端。 这是个好办法吗?这甚至可能创建一个低延迟30fps视频流使用这种方法?

-

我在使用javascript MediaSource扩展API播放H264视频时遇到问题。 我将在下面详细描述这个场景。 我已经成功地实现了播放vp8、vp9、opus和vobis编解码器的音频和视频源的结果,也来自范围请求(如果服务器有能力,使用任何字节范围)或分块文件,使用shaka打包器完成的块。 当源是H264视频时,问题就来了,在我的例子中,详细的编解码器是avc1.64001e和mp4

-

我正在开发一个通过RTP接收H264编码数据的应用程序,但我无法让Android的MediaCodec输出任何内容。我正在按照https://stackoverflow.com/a/7668578/10788248对RTP数据包进行解包 在编码帧被重新组装后,我将它们输入到出列的输入缓冲区中。 当我对输入缓冲区进行排队时,我不会得到任何错误,但是解码器的回调从来不会调用onOutputBuffer