为什么在最后一个softmax层之前移除完全连接的层后,卷积神经网络的精度会提高?

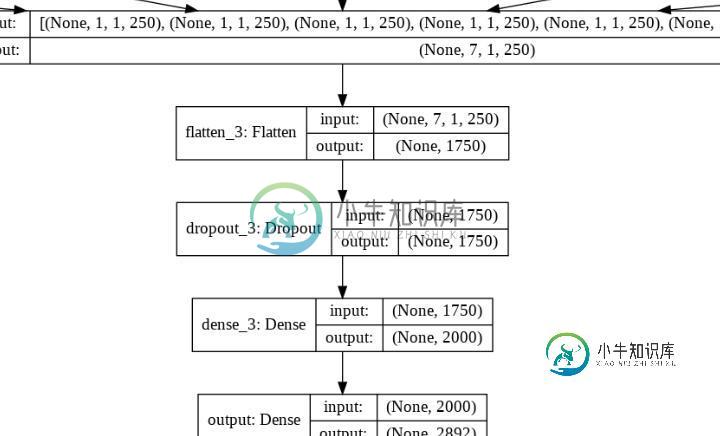

我设计了卷积神经网络(tf.Keras),该网络具有很少的具有不同核大小的并行卷积单元。然后,将该卷积层的每个输出结果馈送到另一个并行的卷积单元中。然后将所有输出串联起来。下一次展平完成。之后,我添加了完全连接的层,并连接到最终的softmax层进行多类分类。我对它进行了培训,并在验证测试中取得了良好的结果。

共有2个答案

消除密集层可以减少过度拟合的趋势。因此,只要模型的训练精度保持在高水平,您的验证损失应该会有所改善。或者,您可以添加一个额外的Dropout层。您还可以通过使用正则化器来减少过度拟合的趋势。相关文档在这里。

移除图层后,模型过度拟合训练集的可能性将降低。因此,通过使网络变浅,可以使模型对未知示例更加健壮,从而提高验证精度。

由于你的训练精度也在提高,这可能表明-

- 爆炸或消失渐变。您可以尝试使用仔细的权重初始化、适当的正则化、添加快捷方式或渐变剪裁来解决此问题

-

我正在强化学习训练无人机的自主导航。由于模拟环境和CNN:AlexNet,支持的问题是基于摄像头的自主导航。我想添加另外两个输入来优化导航:无人机的位置/方向和以3D矩阵形式移动的体积单位。神经网络的目的是预测无人机的下一步行动。 我想在卷积层之后添加这两个新输入,但我不知道如何集成它们。我打算展平3D矩阵,并在完全连接的层之前将其与位置/方向一起添加,但我不知道这是否是正确的方法。 整合这两种新

-

我正在构建一个卷积神经网络,它将包含一定数量的卷积和池层。问题是,我想在特征提取步骤(卷积池)之后添加一些额外的输入。 这个额外的输入将被添加到扁平化的特征映射(全连接层的第一层)。我想问一下是否有任何留档来实现这个,在tenorflow或(如果我幸运的话)在keras中。提前谢谢你,祝你愉快。

-

是否有方法按层(而不是端到端)训练卷积神经网络,以了解每一层对最终架构性能的贡献?

-

例如,有一个3乘3的图像, 有两个2x2滤波器的卷积神经网络卷积图像 最后,输出的维是2x2x2 我可以将上述程序视为以下内容吗? 由于2x2过滤器,在整个图像上滑动后,我得到了4个小图像 并使用这4幅小图像作为全连接神经网络的输入 最后我也能得到8个输出 我真的不知道CNN中的反向传播,所以我试图从经典的全连接神经网络中理解它。 通过输入一幅小图像,我们可以一次性更新全连接神经网络中的权重,这与

-

我对他们有严重的怀疑。任何人都可以举例说明和一些想法。

-

本文向大家介绍全连接层和卷积层的作用?相关面试题,主要包含被问及全连接层和卷积层的作用?时的应答技巧和注意事项,需要的朋友参考一下 全连接层是起到一个分类器的作用,卷积层是用来提取某些特征的层,参数量相对小很多,起到特征工程的作用,感受视野,将欲提取之外的数据的影响减弱,增强需要提取特征的那部分数据的影响