FASTAPI与Alembic一起运行,但autogen不会检测模型

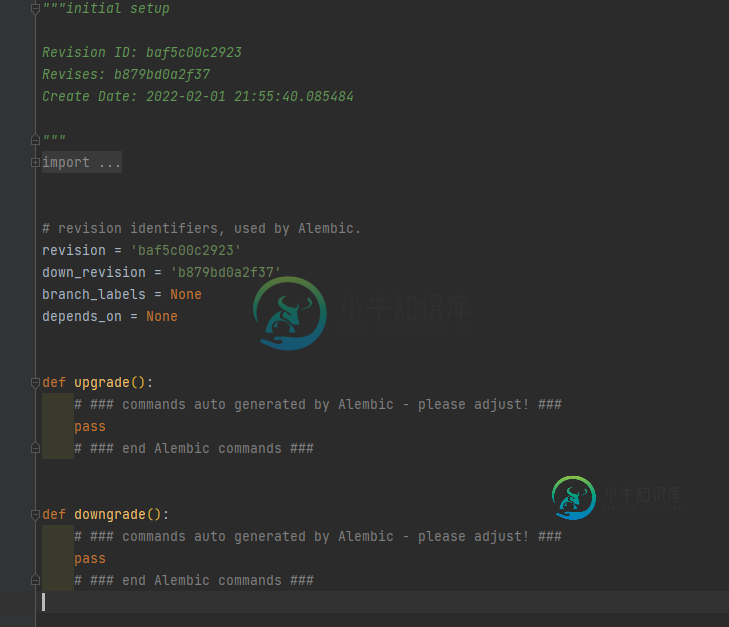

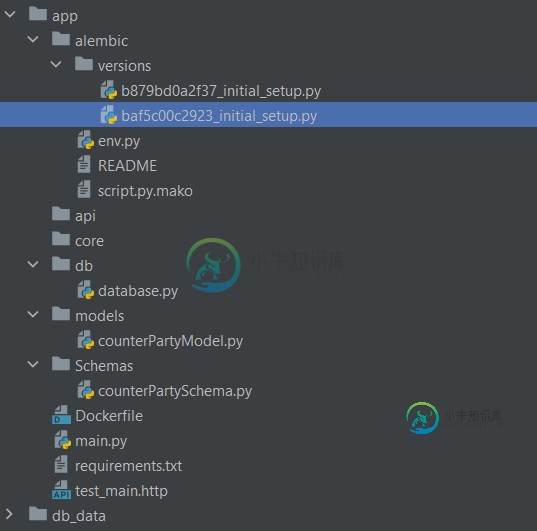

我对FASTAPI比较陌生,但决定与Postgres和Alembic建立一个项目。每次我使用自动迁移时,我都设法让迁移创建新版本,但由于某些原因,我没有从我的模型中获得任何更新,唉,它们保持空白。我有点迷失了方向。

主要的py公司

from fastapi import FastAPI

import os

app = FastAPI()

@app.get("/")

async def root():

return {"message": os.getenv("SQLALCHEMY_DATABASE_URL")}

@app.get("/hello/{name}")

async def say_hello(name: str):

return {"message": f"Hello {name}"}

数据库py公司

from sqlalchemy import create_engine

from sqlalchemy.ext.declarative import declarative_base

from sqlalchemy.orm import sessionmaker

import os

SQLALCHEMY_DATABASE_URL = os.getenv("SQLALCHEMY_DATABASE_URL")

engine = create_engine("postgresql://postgres:mysuperpassword@localhost/rodney")

SessionLocal = sessionmaker(autocommit=False, autoflush=False, bind=engine)

Base = declarative_base()

def get_db():

db = SessionLocal()

try:

yield db

except:

db.close()

我目前唯一的模型

from sqlalchemy import Integer, String

from sqlalchemy.sql.schema import Column

from ..db.database import Base

class CounterParty(Base):

__tablename__ = "Counterparty"

id = Column(Integer, primary_key=True)

Name = Column(String, nullable=False)

env.py(alembic)

from logging.config import fileConfig

from sqlalchemy import engine_from_config

from sqlalchemy import pool

from alembic import context

# this is the Alembic Config object, which provides

# access to the values within the .ini file in use.

config = context.config

# Interpret the config file for Python logging.

# This line sets up loggers basically.

fileConfig(config.config_file_name)

# add your model's MetaData object here

# for 'autogenerate' support

from app.db.database import Base

target_metadata = Base.metadata

# other values from the config, defined by the needs of env.py,

# can be acquired:

# my_important_option = config.get_main_option("my_important_option")

# ... etc.

def run_migrations_offline():

"""Run migrations in 'offline' mode.

This configures the context with just a URL

and not an Engine, though an Engine is acceptable

here as well. By skipping the Engine creation

we don't even need a DBAPI to be available.

Calls to context.execute() here emit the given string to the

script output.

"""

url = config.get_main_option("sqlalchemy.url")

context.configure(

url=url,

target_metadata=target_metadata,

literal_binds=True,

dialect_opts={"paramstyle": "named"},

)

with context.begin_transaction():

context.run_migrations()

def run_migrations_online():

"""Run migrations in 'online' mode.

In this scenario we need to create an Engine

and associate a connection with the context.

"""

connectable = engine_from_config(

config.get_section(config.config_ini_section),

prefix="sqlalchemy.",

poolclass=pool.NullPool,

)

with connectable.connect() as connection:

context.configure(

connection=connection, target_metadata=target_metadata

)

with context.begin_transaction():

context.run_migrations()

if context.is_offline_mode():

run_migrations_offline()

else:

run_migrations_online()

如果有人有任何想法,我将非常伟大。干杯!

共有2个答案

env.py文件找不到模型,因为您还没有导入它们。解决方法之一是,您只需将它们立即导入env.py文件中,如下所示:

从...模型导入*

但是,您需要在模型目录中有一个init.py文件,并在其中包含所有模型。

另一种方法(但不推荐):如果只有一个模型,则可以将其直接导入为:

从…起模型。交易对手模型导入

在我的例子中,我使用Transformer-BERT模型部署在FastApi上,但FastApi无法识别我的模型,也无法获取模型的输入和输出。我在案例中使用的代码:

from fastapi import FastAPI

from pydantic import BaseModel

class Entities(BaseModel):

text: str

class EntitesOut(BaseModel):

headings: str

Probability: str

Prediction: str

model_load = load_model('BERT_HATESPEECH')

tokenizer = DistilBertTokenizerFast.from_pretrained('BERT_HATESPEECH_TOKENIZER')

file_to_read = open("label_encoder_bert_hatespeech.pkl", "rb")

label_encoder = pickle.load(file_to_read)

app = FastAPI()

@app.post('/predict', response_model=EntitesOut)

def prep_data(text:Entities):

text = text.text

tokens = tokenizer(text, max_length=150, truncation=True,

padding='max_length',

add_special_tokens=True,

return_tensors='tf')

tokens = {'input_ids': tf.cast(tokens['input_ids'], tf.float64), 'attention_mask': tf.cast(tokens['attention_mask'], tf.float64)}

headings = '''Non-offensive', 'identity_hate', 'neither', 'obscene','offensive', 'sexism'''

probs = model_load.predict(tokens)[0]

pred = label_encoder.inverse_transform([np.argmax(probs)])

return {"headings":headings,

"Probability":str(np.round(probs,3)),

"Prediction":str(pred)}

上面的代码使用pydantic中的BaseModel,我为BaseModel创建了类,将文本:str作为输入,将标题、概率和预测作为实体输出类中的输出,然后通过模型进行识别,并用输出保存200个状态代码

-

我得堆栈: 想法2019.1.3 Springboot 2.1.6 Java 11 Maven 3.8.0 Groovy 2.5 史巴克1.3 JUnit jupiter 5.5.1 JUnit vintage 5.5.1 GMavenPlus插件2.7.1 我们想开始在Spock测试框架中编写测试。我跟着这个howto,但没有成功。当我尝试运行所有测试时,我的spock测试没有运行。 我能运行一

-

我在一个布局中使用了fab,但在运行时给出了以下错误:08-30 22:01:35.548 262 95-26295/? E/AndroidRuntime:致命异常:main process:com.example.ahr.a1000funnysms,pid:26295 Android.view.filflateException:二进制XML文件第30行:错误inflating类Android.

-

在我运行mongo恢复后,mongo服务无法自动启动,但如果我打开终端并运行monstar,服务运行完美。如果我关闭终端,我得到。有什么建议吗? 错误:无法连接到服务器127.0.0.1 shell/mongo。js:79 当我运行mon神时,我得到: MongoDB启动:pid=1875 port=27017 dbpath=/data/db/64位周四25 12:16:40db version

-

我想启动一个反序列化动态创建的类的流。这个Bean是使用反射和URLCLassLOader创建的,参数为给定的字符串类,但是KafkaStreams API不识别我的新类。 流与预创建的Beans完美配合,但使用动态Beans时会自动关闭。反倾销者是和杰克逊一起创造的,也是单独工作的。 下面是类解析器代码 首先,我实例化接收类作为参数的serde 然后启动使用此Serdes的流拓扑 流拓扑应该正常

-

软件版本:alembic 1.0.5、SQLAlchemy 1.2.14、MySQL 5.7、Python 3.6.7 我试图使用alembic来保持MySQL数据库模式和Python ORM表示的一致性。 我看到的问题是,迁移总是有多余的外键删除和创建命令。autogenerate似乎认为有些东西是不同的,但实际上它们是相同的。 在重复调用命令时: ...将生成相同的拖放和创建命令。 stdou

-

我希望使用Maven在任何平台上使用JavaFX执行jar,无论主机上是否安装了JavaFX。