pyspark“Java网关进程在发送端口号前退出”错误

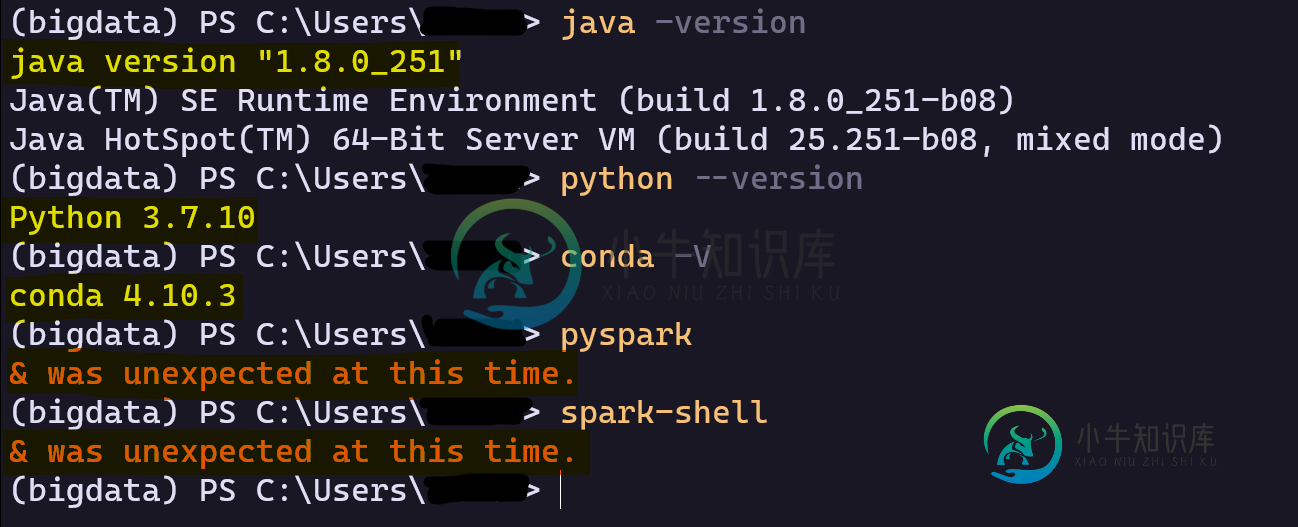

我在Spark 3.1.2和Hadoop 2.7中面临两个错误:

第一个是在python中导入'pyspark'并创建一个会话。

错误:'Java网关进程在发送端口号前已退出‘

我从GitHub上的存储库中为以下Hadoop版本下载了它们:[2.7.1,2.7.7]

试过了,都不起作用。

我的环境变量--就我所检查的而言--是正确的:

SPARK_HOME

HADOOP_HOME

JAVA_HOME

%SPARK_HOME%\bin

%HADOOP_HOME%\bin

- Windows 10

- Python:3.7.10

- 水蟒:4.10.3

- java:1.8.0_251

- 火花:3.1.2

- Hadoop:2.7

共有1个答案

在尝试了这个问题的多种解决方案后,我无法找出这个错误。所以,我重新设置了我的窗户,现在一切都正常了,这让我思考。在重置之前,我从Windows商店安装了Windows终端,并对其进行了一些调整。我不知道这与我的火花问题有什么关系,但似乎是这样。

-

我正在使用Pyspark运行一些命令在Jupyter笔记本,但它是抛出错误。我尝试了这个链接中提供的解决方案(pyspark:exception:Java gateway process在发送驱动程序端口号之前退出),并且尝试了这里提供的解决方案(比如将路径更改为c:Java、卸载Java SDK 10和重新安装Java8,但它仍然给我带来了同样的错误。 我试着卸载和重新安装pyspark,我试着

-

我运行Windows10,并通过Anaconda3安装了Python3。我在用Jupyter笔记本。我从这里安装了Spark(Spark-2.3.0-bin-Hadoop2.7.tgz)。我已经解压缩了这些文件,并将它们粘贴到我的目录d:\spark中。我已经修改了环境变量: 用户变量: 变量:SPARK_HOME 值:D:\spark\bin 我已经通过conda安装/更新了以下模块: 熊猫 皮

-

我在python环境中使用了pip安装pyspark,安装了java,但是当我尝试初始化spark会话时,我得到了一个java错误,java网关进程在发送端口号之前退出 运行时错误发布在上面,我在其他帖子中没有看到这种类型的错误

-

我使用以下方法安装了pyspark: 根据该示例的web,它应该刚好可以用以下代码执行: 但我有一个错误: 接着,要解决第二个问题,只需在控制面板中定义HADOOP_HOME和PATH环境变量,以便任何Windows程序都可以使用它们。

-

我正试图用Anaconda在我的Windows10中安装Spark,但当我试图在JupyterNotebook中运行pyspark时,我遇到了一个错误。我正在遵循本教程中的步骤。然后,我已经下载了Java8并安装了Spark 3.0.0和Hadoop 2.7。 我已经为SPARK_HOME、JAVA_HOME设置了路径,并在“path”环境中包含了“/bin”路径。 在Anaconda pyspa

-

尝试使用时我遇到了一个问题。我在我的用户路径中安装并添加了。但根据文档,它不需要任何其他依赖项。 我的问题是,我必须安装其他东西吗?像Spark本身或类似的东西? 我在中使用。