PySpark异常:Java网关进程在发送端口号前退出

我运行Windows10,并通过Anaconda3安装了Python3。我在用Jupyter笔记本。我从这里安装了Spark(Spark-2.3.0-bin-Hadoop2.7.tgz)。我已经解压缩了这些文件,并将它们粘贴到我的目录d:\spark中。我已经修改了环境变量:

用户变量:

变量:SPARK_HOME

值:D:\spark\bin

我已经通过conda安装/更新了以下模块:

熊猫

皮亚罗

皮斯帕克

PY4J

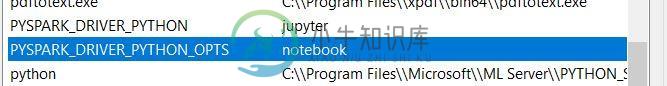

我不知道这是否相关,但在我的环境变量中会出现以下两个变量:

完成所有这些操作后,我重新启动并运行下面的代码,结果是一条错误消息,我将其粘贴在这里:

import pandas as pd

import seaborn as sns

# These lines enable the run of spark commands

from pyspark.context import SparkContext

from pyspark.sql.session import SparkSession

sc = SparkContext('local')

spark = SparkSession(sc)

import pyspark

data = sns.load_dataset('iris')

data_sp = spark.createDataFrame(data)

data_sp.show()

---------------------------------------------------------------------------

Exception Traceback (most recent call last)

<ipython-input-1-ec964ecd39a2> in <module>()

7 from pyspark.context import SparkContext

8 from pyspark.sql.session import SparkSession

----> 9 sc = SparkContext('local')

10 spark = SparkSession(sc)

11

C:\ProgramData\Anaconda3\lib\site-packages\pyspark\context.py in __init__(self, master, appName, sparkHome, pyFiles, environment, batchSize, serializer, conf, gateway, jsc, profiler_cls)

113 """

114 self._callsite = first_spark_call() or CallSite(None, None, None)

--> 115 SparkContext._ensure_initialized(self, gateway=gateway, conf=conf)

116 try:

117 self._do_init(master, appName, sparkHome, pyFiles, environment, batchSize, serializer,

C:\ProgramData\Anaconda3\lib\site-packages\pyspark\context.py in _ensure_initialized(cls, instance, gateway, conf)

296 with SparkContext._lock:

297 if not SparkContext._gateway:

--> 298 SparkContext._gateway = gateway or launch_gateway(conf)

299 SparkContext._jvm = SparkContext._gateway.jvm

300

C:\ProgramData\Anaconda3\lib\site-packages\pyspark\java_gateway.py in launch_gateway(conf)

92

93 if not os.path.isfile(conn_info_file):

---> 94 raise Exception("Java gateway process exited before sending its port number")

95

96 with open(conn_info_file, "rb") as info:

Exception: Java gateway process exited before sending its port number

我怎样才能让PySpark工作?

共有1个答案

我按照下面的说明解决了这个问题:https://changhsinlee.com/install-pyspark-windows-jupyter/

-

我在Spark 3.1.2和Hadoop 2.7中面临两个错误: 第一个是在python中导入'pyspark'并创建一个会话。 错误:'Java网关进程在发送端口号前已退出‘ 我从GitHub上的存储库中为以下Hadoop版本下载了它们:[2.7.1,2.7.7] 试过了,都不起作用。 我的环境变量--就我所检查的而言--是正确的: Windows 10 Python:3.7.10 水蟒:4.1

-

尝试使用时我遇到了一个问题。我在我的用户路径中安装并添加了。但根据文档,它不需要任何其他依赖项。 我的问题是,我必须安装其他东西吗?像Spark本身或类似的东西? 我在中使用。

-

代码在下面 获取错误异常:Java网关进程在发送其端口号之前退出

-

我正在使用Pyspark运行一些命令在Jupyter笔记本,但它是抛出错误。我尝试了这个链接中提供的解决方案(pyspark:exception:Java gateway process在发送驱动程序端口号之前退出),并且尝试了这里提供的解决方案(比如将路径更改为c:Java、卸载Java SDK 10和重新安装Java8,但它仍然给我带来了同样的错误。 我试着卸载和重新安装pyspark,我试着

-

我使用以下方法安装了pyspark: 根据该示例的web,它应该刚好可以用以下代码执行: 但我有一个错误: 接着,要解决第二个问题,只需在控制面板中定义HADOOP_HOME和PATH环境变量,以便任何Windows程序都可以使用它们。

-

我正试图用Anaconda在我的Windows10中安装Spark,但当我试图在JupyterNotebook中运行pyspark时,我遇到了一个错误。我正在遵循本教程中的步骤。然后,我已经下载了Java8并安装了Spark 3.0.0和Hadoop 2.7。 我已经为SPARK_HOME、JAVA_HOME设置了路径,并在“path”环境中包含了“/bin”路径。 在Anaconda pyspa