具有多个输出主题的Kafka流拓扑的并发

给定一个将消息发布到两个不同主题的Kafka流拓扑,是否可以保证在这两个分支中执行各个步骤的顺序,或者这些分支是完全分开并并行执行的?

KStream<..., ...> filteredStream = builder.stream("input-topic", ...).filter(...)...;

filteredStream.mapValues(this::mapOne).to("output-topic-one", ...);

filteredStream.flatMap(this::mapTwo).to("output-topic-two", ...);

在本例中,是否会在调用< code>mapTwo或向output-topic-two发布消息之前执行< code>mapOne并发布到output-topic-one?换句话说,能否保证在消息发布到output-topic-two之前完成< code>mapOne?

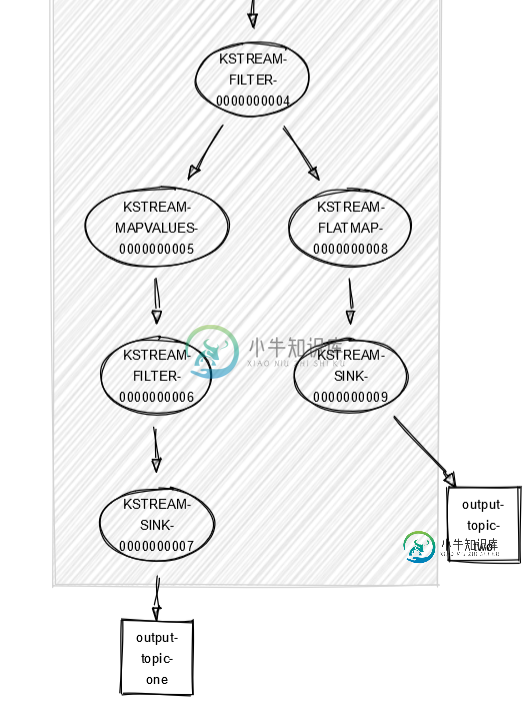

在查看拓扑描述的可视化时(请参阅底部;用 https://zz85.github.io/kafka-streams-viz/ 制成),您可以看到两个分支。但你也可以在每个气泡中看到这些数字,这也可能表明存在执行顺序(1-4,然后是5-6-7,然后是8-9)。

Topologies:

Sub-topology: 0

Source: KSTREAM-SOURCE-0000000000 (topics: [input-topic])

--> KSTREAM-FILTER-0000000001

Processor: KSTREAM-FILTER-0000000001 (stores: [])

--> KSTREAM-FILTER-0000000002

<-- KSTREAM-SOURCE-0000000000

Processor: KSTREAM-FILTER-0000000002 (stores: [])

--> KSTREAM-MAP-0000000003

<-- KSTREAM-FILTER-0000000001

Processor: KSTREAM-MAP-0000000003 (stores: [])

--> KSTREAM-FILTER-0000000004

<-- KSTREAM-FILTER-0000000002

Processor: KSTREAM-FILTER-0000000004 (stores: [])

--> KSTREAM-MAPVALUES-0000000005, KSTREAM-FLATMAP-0000000008

<-- KSTREAM-MAP-0000000003

Processor: KSTREAM-MAPVALUES-0000000005 (stores: [])

--> KSTREAM-FILTER-0000000006

<-- KSTREAM-FILTER-0000000004

Processor: KSTREAM-FILTER-0000000006 (stores: [])

--> KSTREAM-SINK-0000000007

<-- KSTREAM-MAPVALUES-0000000005

Processor: KSTREAM-FLATMAP-0000000008 (stores: [])

--> KSTREAM-SINK-0000000009

<-- KSTREAM-FILTER-0000000004

Sink: KSTREAM-SINK-0000000007 (topic: output-topic-one)

<-- KSTREAM-FILTER-0000000006

Sink: KSTREAM-SINK-0000000009 (topic: output-topic-two)

<-- KSTREAM-FLATMAP-0000000008

共有1个答案

Kafka流始终保证拓扑顺序。它总是在拓扑中传递消息,该拓扑具有边缘和节点。当您在应用程序中定义拓扑时,这些边和节点将添加到拓扑中。

在您的情况下,过滤流遍历拓扑中的map values分支,直到该路径结束(在您的案例中为sink-

然后它继续使用平面映射分支。直到下沉到主题二。

使用该 ID 正确排序。

0000000004-

0000000004-

有关更多信息,请查看Kafka源代码内部拓扑构建器

并参考这个

-

我试着把这个理论与缩放工人做比较。 但是,使用版本1.2.1时,storm Kafka spout在多个不同的拓扑中的行为并不像我预期的那样。 为单个主题的所有拓扑中的kafka spout使用者设置一个公共client.id和group.id,每个拓扑仍然订阅所有可用的分区和重复的元组,并在重新提交已提交的元组时抛出错误。 如果有人能解释一下 Kafka喷口的这种行为的实现逻辑是什么? 有解决此

-

我正在使用Spring Cloud Stream Kafka Binder。我有以下Kafka活页夹函数。 在yml中,我有: 如果我想从同一个功能向两个不同的主题发送数据,我需要做什么?

-

我们有一个kafka streams Spring Boot应用程序(使用spring-kafka),这个应用程序目前从上游主题读取消息,应用一些转换,并将它们写入下游主题,它不做任何聚合或联接或任何高级kafka streams功能。 代码当前类似于

-

我们在kafka代理日志中注意到,流应用程序试图描述不属于拓扑的主题。看起来它每10分钟周期性地发生一次。 为什么会发生这种情况?为什么streams需要了解不属于拓扑的主题?要阻止这一切吗?由于流应用程序没有权限描述这些主题,因此我们得到了一堆错误日志。 我们使用的是版本1.1.1

-

在准备拓扑优化时,我偶然发现了以下几点: 目前,Kafka Streams在启用时会执行两种优化: 1-源KTable将源主题重新用作变更日志主题。 2-如果可能,Kafka流会将多个重新分区主题压缩为单个重新分区主题。 这个问题是关于第一点的。我不完全明白这里发生了什么。只是为了确保我没有在这里做任何假设。有人能解释一下,以前是什么状态吗: 1-KTable使用内部变更日志主题吗?如果是,有人能

-

我有2个Kafka的主题流完全相同的内容从不同的来源,所以我可以有高可用性的情况下,其中一个来源失败。我正在尝试使用Kafka Streams0.10.1.0将2个主题合并为1个输出主题,这样我就不会错过任何关于失败的消息,并且当所有源都启动时没有重复的消息。 当使用KStream的方法时,其中一个主题可以毫无问题地关闭(次要主题),但是当主主题关闭时,将不会向输出主题发送任何内容。这似乎是因为,