未在kibana中为mongodb+logstash+ElasticSearch创建索引

我正在尝试使用logstash配置在kibana中可视化mongodb数据。下面是我的配置。我在终端中得到一些输出,它永远循环。我看不到由配置文件中提到的名称创建的任何索引,如果索引是生成的,也没有任何数据。在discover选项卡中没有匹配的结果。如何在Kibana中使配置可视化数据?

input {

mongodb {

uri => "mongodb+srv:@@@@@@@@@@@@@@@?retryWrites=true&w=majority"

placeholder_db_dir => "C:/logstash-mongodb"

placeholder_db_name => "logstash1_sqlite.db"

collection => "logs"

batch_size => 1

}

}

filter {

}

output {

stdout {

codec => rubydebug

}

elasticsearch {

action => "index"

index => "ayesha_logs"

hosts => ["localhost:9200"]

}

}

http://localhost:9200/ayesha_logs/_search?漂亮

终端日志:D,[2020-10-01T08:11:45.717000#2372]调试--:MONGODB range-api-test-cluster-shard-00-02.icqif.azure.MONGODB.net:27017请求:259 conn:1:1 sconn:231839共存-poc.listCollections STARTED{“listCollections”=>1,“cursor”=>{},“nameonly”=>true,“$db”=>“共存-poc”,“$clustertime”=>{“clustertime”“=>{”hash“=>

共有1个答案

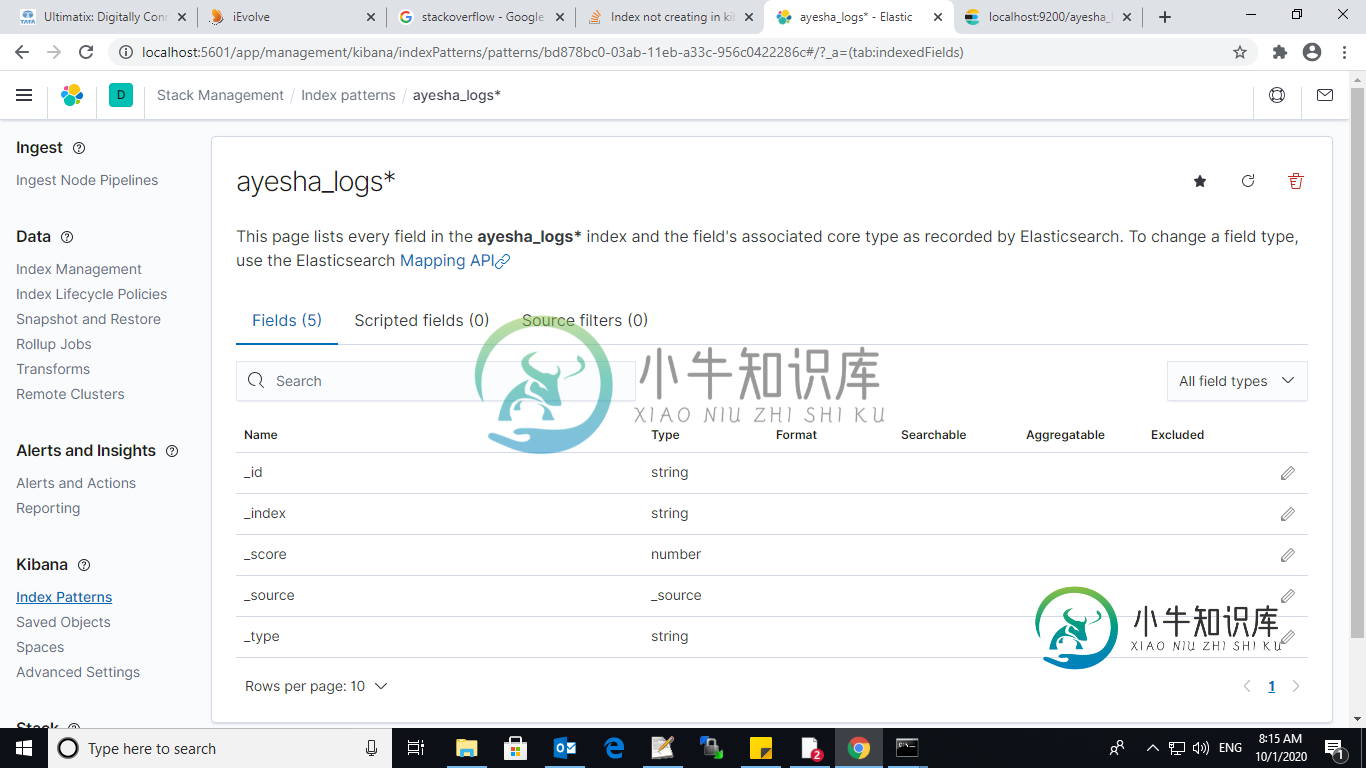

你创建了你的Kibana索引模式吗?如果没有,请转到菜单>堆栈管理>Kibana>索引模式

然后,您将能够在发现或可视化选项卡中使用索引。

-

问题内容: 我正在探索EKL堆栈并遇到问题。 我已经生成了日志,将日志转发到logstash,日志采用JSON格式,因此仅使用Logstash配置中的JSON过滤器将它们直接推入ES,连接并启动指向ES的Kibana。 Logstash配置: 现在,我已经为每天的日志创建了索引,而Kibana高兴地显示了来自所有索引的所有日志。 我的问题是:日志中有许多字段未启用/未在Kibana中进行过滤的索引

-

根据digitalocean教程,我用我的ELK节点作为RedHat服务器设置了ELK stack和filebeat。Kibana已启动并运行,但当我将索引模式配置为logstash-*时,我看不到任何logstash索引: 当我做卷曲以查看我的索引时,它们只是filebeat索引。Filebeat应该将数据推送到正在监听5044的logstash 您可以看到我只有filebeat索引。我检查了我

-

elasticsearch版本:elasticsearch-2.2.0。rpm logstash版本:logstash-2.2.2-1。诺奇。转速 我启动elasticsearch,然后使用具有基本标准输入/标准输出的 /etc/logstash/conf.d/logstash.conf进行logstash,但没有创建elasticsearch索引。如果我将以下内容添加到我的logstash输出配

-

问题内容: 我正在尝试使用mongodb- river使用以下命令在elasticsearch中为mongodb编制索引,但文档映射未生效。它仍然使用默认的分析器(标准)作为字段 Mongodb-river 该文档指定了索引的创建,但是没有有关如何提供自定义映射的文档。这就是我尝试过的。是否有其他文档可以找到如何在使用mongodb- river的过程中指定自定义分析器等。 如果我按全字词搜索,但

-

问题内容: 如何根据负载计划资源(我怀疑是Elasticsearch实例): 在负载下,我的意思是每分钟≈500K个事件,每个事件包含8-10个字段。 我应该转动哪些配置旋钮?我是这个堆栈的新手。 问题答案: 每分钟500,000个事件等于每秒8,333个事件,对于一个小型集群(3-5台机器)来说,这应该很容易处理。 问题在于将720M每日文档保留60天(43B文档)。如果10个字段中的每个字段均

-

我有3个节点的ElasticSearch集群和3个节点的MongoDb ReplicaSet。我正在尝试使用以下配置设置river: 此命令运行良好,但ElasticSearch不会尝试从MongoDb获取数据。我更新了记录,但没有帮助。 是否有特殊的配置来连接到副本集?我在单个ES和单个MongoDb上尝试过这种配置,效果很好。