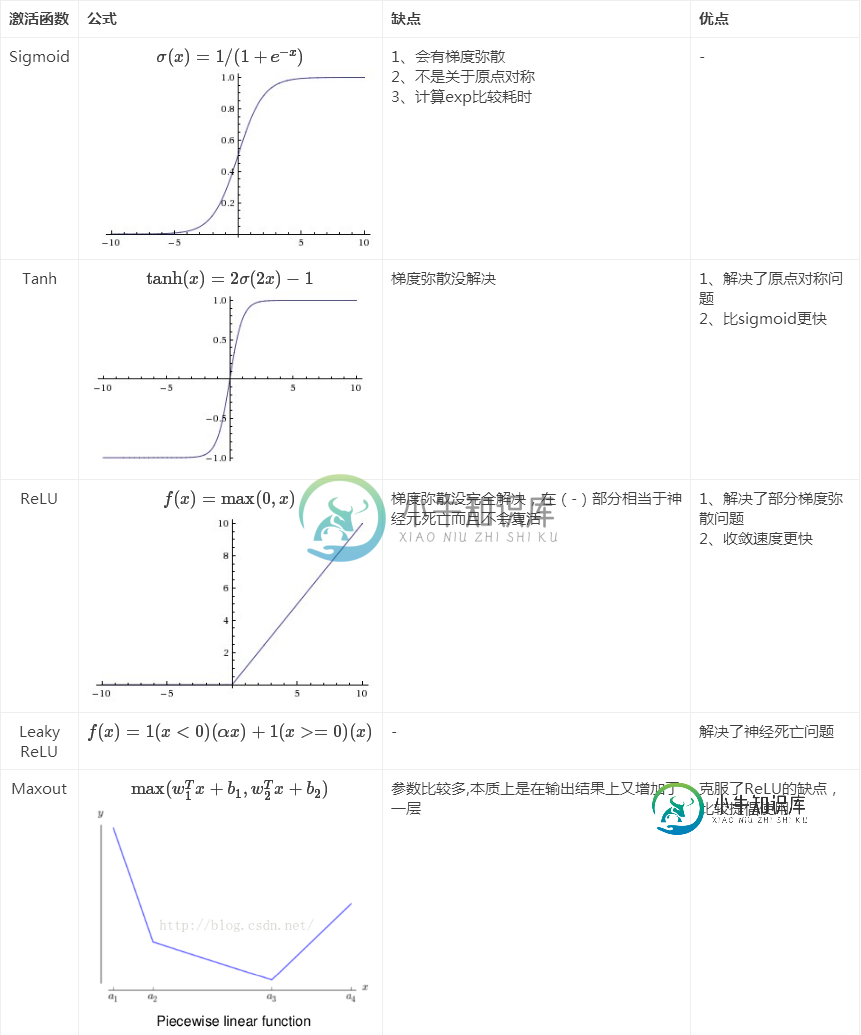

Sigmiod、Relu、Tanh三个激活函数的缺点和不足,有没有更好的激活函数?

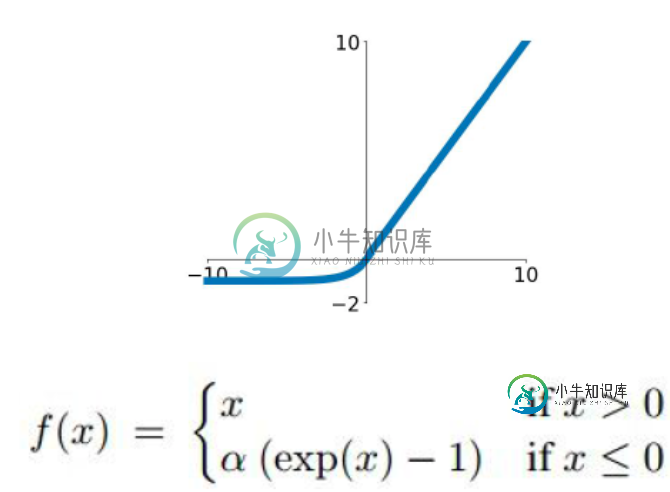

sigmoid、Tanh、ReLU的缺点在121问题中已有说明,为了解决ReLU的dead cell的情况,发明了Leaky Relu, 即在输入小于0时不让输出为0,而是乘以一个较小的系数,从而保证有导数存在。同样的目的,还有一个ELU,函数示意图如下。

还有一个激活函数是Maxout,即使用两套w,b参数,输出较大值。本质上Maxout可以看做Relu的泛化版本,因为如果一套w,b全都是0的话,那么就是普通的ReLU。Maxout可以克服Relu的缺点,但是参数数目翻倍。

-

激活函数给神经元引入了非线性因素,使得神经网络可以任意逼近任何非线性函数,这样神经网络就可以应用到众多的非线性模型中。 Sigmoid 也成为 S 形函数,取值范围为 (0,1)。Sigmoid 将一个实数映射到 (0,1) 的区间,可以用来做二分类。Sigmoid 在特征相差比较复杂或是相差不是特别大时效果比较好。 sigmoid 缺点: 激活函数计算量大(指数运算),反向传播求误差梯度时,求导

-

激活函数可以通过设置单独的激活层实现,也可以在构造层对象时通过传递activation参数实现。 from keras.layers import Activation, Dense model.add(Dense(64)) model.add(Activation('tanh')) 等价于 model.add(Dense(64, activation='tanh')) 也可以通过传递一个逐

-

激活函数可以通过设置单独的激活层实现,也可以在构造层对象时通过传递activation参数实现。 from keras.layers.core import Activation, Dense model.add(Dense(64)) model.add(Activation('tanh')) 等价于 model.add(Dense(64, activation='tanh')) 也可以通过

-

本文向大家介绍激活函数的作用相关面试题,主要包含被问及激活函数的作用时的应答技巧和注意事项,需要的朋友参考一下 参考回答: 激活函数是用来加入非线性因素的,提高神经网络对模型的表达能力,解决线性模型所不能解决的问题。

-

激活函数的用法 激活函数可以通过设置单独的 Activation 层实现,也可以在构造层对象时通过传递 activation 参数实现: from keras.layers import Activation, Dense model.add(Dense(64)) model.add(Activation('tanh')) 等价于: model.add(Dense(64, activation

-

在讲反向传播算法时,我们用均方差损失函数和Sigmoid激活函数做了实例,首先我们就来看看均方差+Sigmoid的组合有什么问题。 首先我们回顾下Sigmoid激活函数的表达式为:$$sigma(z) = frac{1}{1+e^{-z}}$$ $$sigma(z)$$的函数图像如下: 从图上可以看出,对于Sigmoid,当z的取值越来越大后,函数曲线变得越来越平缓,意味着此时的导数$$sigma