Pyspark py4j PickleException:“预期的零参数用于构造ClassDict”

该问题针对的是熟悉py4j的人员-可以帮助解决酸洗错误。我正在尝试向pyspark

PythonMLLibAPI添加一个方法,该方法接受namedtuple的RDD,进行一些工作,并以RDD的形式返回结果。

该方法是在PYthonMLLibAPI.trainALSModel()方法之后建模的,其类似的 现有 相关部分为:

def trainALSModel(

ratingsJRDD: JavaRDD[Rating],

.. )

用于建模新代码的 现有 python Rating类为:

class Rating(namedtuple("Rating", ["user", "product", "rating"])):

def __reduce__(self):

return Rating, (int(self.user), int(self.product), float(self.rating))

这是尝试,所以这里是相关的类:

新的 python类pyspark.mllib.clustering.MatrixEntry:

from collections import namedtuple

class MatrixEntry(namedtuple("MatrixEntry", ["x","y","weight"])):

def __reduce__(self):

return MatrixEntry, (long(self.x), long(self.y), float(self.weight))

___PythonMLLibAPI中的_ 新 方法foobarRDD:

def foobarRdd(

data: JavaRDD[MatrixEntry]): RDD[FooBarResult] = {

val rdd = data.rdd.map { d => FooBarResult(d.i, d.j, d.value, d.i * 100 + d.j * 10 + d.value)}

rdd

}

现在让我们尝试一下:

from pyspark.mllib.clustering import MatrixEntry

def convert_to_MatrixEntry(tuple):

return MatrixEntry(*tuple)

from pyspark.mllib.clustering import *

pic = PowerIterationClusteringModel(2)

tups = [(1,2,3),(4,5,6),(12,13,14),(15,7,8),(16,17,16.5)]

trdd = sc.parallelize(map(convert_to_MatrixEntry,tups))

# print out the RDD on python side just for validation

print "%s" %(repr(trdd.collect()))

from pyspark.mllib.common import callMLlibFunc

pic = callMLlibFunc("foobar", trdd)

结果的相关部分:

[(1,2)=3.0, (4,5)=6.0, (12,13)=14.0, (15,7)=8.0, (16,17)=16.5]

这表明输入rdd为“整个”。但是,酸洗不开心:

5/04/27 21:15:44 ERROR Executor: Exception in task 6.0 in stage 1.0 (TID 14)

net.razorvine.pickle.PickleException: expected zero arguments for construction of ClassDict

(for pyspark.mllib.clustering.MatrixEntry)

at net.razorvine.pickle.objects.ClassDictConstructor.construct(ClassDictConstructor.java:23)

at net.razorvine.pickle.Unpickler.load_reduce(Unpickler.java:617)

at net.razorvine.pickle.Unpickler.dispatch(Unpickler.java:170)

at net.razorvine.pickle.Unpickler.load(Unpickler.java:84)

at net.razorvine.pickle.Unpickler.loads(Unpickler.java:97)

at org.apache.spark.mllib.api.python.SerDe$$anonfun$pythonToJava$1$$anonfun$apply$1.apply(PythonMLLibAPI.scala:1167)

at org.apache.spark.mllib.api.python.SerDe$$anonfun$pythonToJava$1$$anonfun$apply$1.apply(PythonMLLibAPI.scala:1166)

at scala.collection.Iterator$$anon$13.hasNext(Iterator.scala:371)

at scala.collection.Iterator$$anon$11.hasNext(Iterator.scala:327)

at scala.collection.Iterator$class.foreach(Iterator.scala:727)

at scala.collection.AbstractIterator.foreach(Iterator.scala:1157)

at scala.collection.generic.Growable$class.$plus$plus$eq(Growable.scala:48)

at scala.collection.mutable.ArrayBuffer.$plus$plus$eq(ArrayBuffer.scala:103)

at scala.collection.mutable.ArrayBuffer.$plus$plus$eq(ArrayBuffer.scala:47)

at scala.collection.TraversableOnce$class.to(TraversableOnce.scala:273)

at scala.collection.AbstractIterator.to(Iterator.scala:1157)

at scala.collection.TraversableOnce$class.toBuffer(TraversableOnce.scala:265)

at scala.collection.AbstractIterator.toBuffer(Iterator.scala:1157)

at scala.collection.TraversableOnce$class.toArray(TraversableOnce.scala:252)

at scala.collection.AbstractIterator.toArray(Iterator.scala:1157)

at org.apache.spark.rdd.RDD$$anonfun$17.apply(RDD.scala:819)

at org.apache.spark.rdd.RDD$$anonfun$17.apply(RDD.scala:819)

at org.apache.spark.SparkContext$$anonfun$runJob$5.apply(SparkContext.scala:1523)

at org.apache.spark.SparkContext$$anonfun$runJob$5.apply(SparkContext.scala:1523)

at org.apache.spark.scheduler.ResultTask.runTask(ResultTask.scala:61)

at org.apache.spark.scheduler.Task.run(Task.scala:64)

at org.apache.spark.executor.Executor$TaskRunner.run(Executor.scala:212)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1145)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:615)

at java.lang.Thread.run(Thread.java:724)

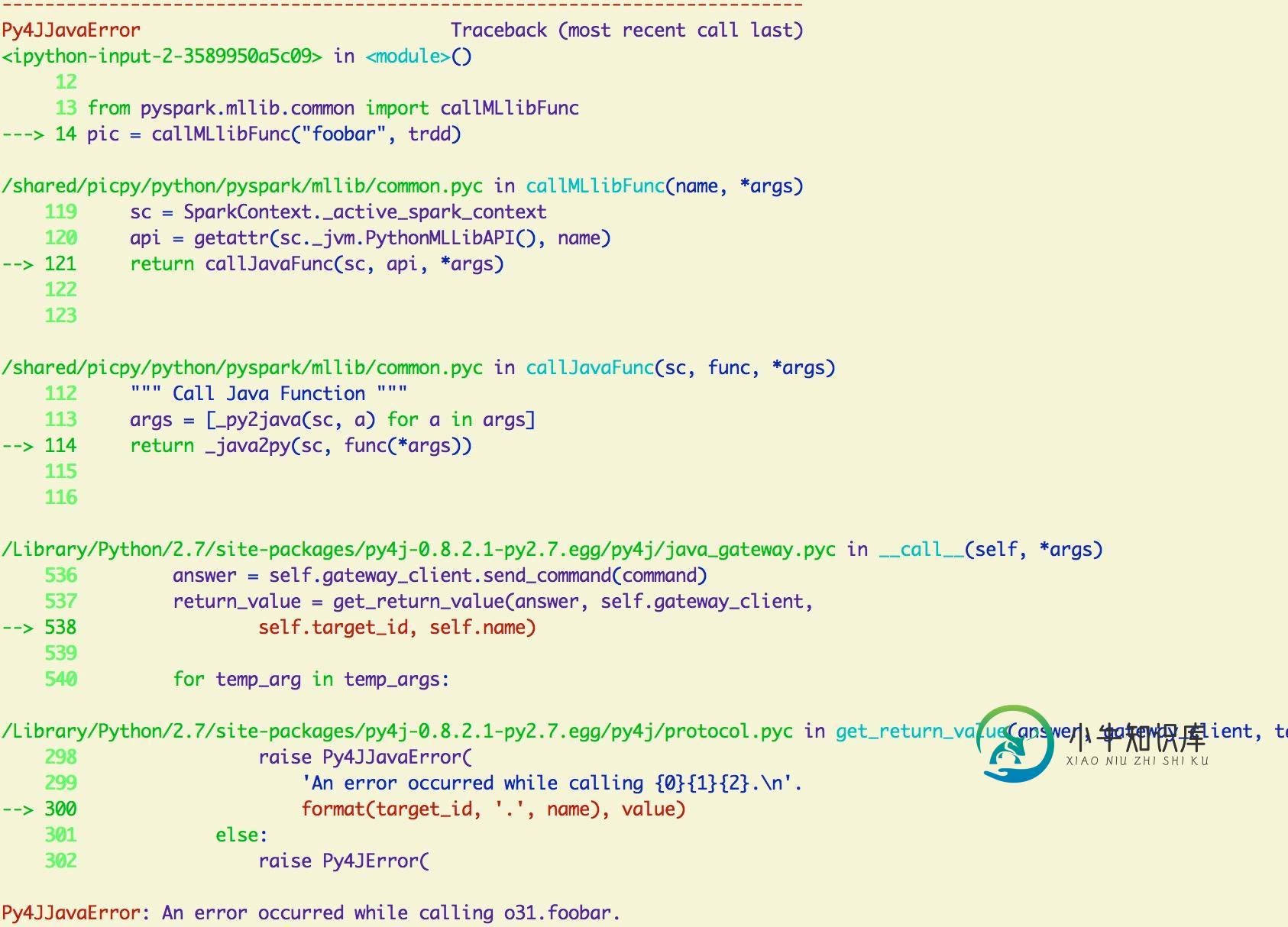

下面是python调用堆栈跟踪的视觉效果:

问题答案:

我遇到了与使用MLlib相同的错误,结果发现我在其中一个函数中返回了错误的数据类型。现在,在对返回值进行简单的强制转换之后,它就可以工作。这可能不是您要寻找的答案,但这至少是要遵循的方向的提示。

-

我正在尝试使用recyclerview和room库创建一个简单的ToDoList应用程序。在使用room和mvvm架构方面,我正在遵循android开发者代码实验室,我似乎遇到了困难。我已经设置了应用程序的每一层,但在尝试使用ViewModelProvider实例化ViewModel时出现了一个错误。下面是我的ViewModel类中的代码。 } 下面是我试图初始化ViewModel的main片段中

-

我是新的Android和Java,并试图使基于位置的应用程序。 编辑 我做了一个非常非常简单的测试代码,得到了同样的错误。这是java: 我也犯了同样的错误。以下是我的应用程序级构建中的依赖项。格雷德尔: 原帖 我试图使用ViewModel和LiveData来更新用户位置,因为我知道这是生命周期感知的最佳方式。我有一个默认的地图活动... 一个扩展LiveData以存储用户位置的类。。。 以及一个

-

我通过本文档了解LiveData和ViewModel。在文档中,ViewModel类具有构造函数, 但是,当我运行代码时,会出现异常: 原因:java.lang.运行时异常:无法创建类的实例UserViewModel原因:java.lang.实例异常:java.lang.类没有零参数构造函数

-

我正在使用并试图将我的导入我的类。 当使用ViewModel查看Google的hilt文档时,我们可以看到他们能够将注入到所述

-

我想启动一项服务,我使用: 启动它: 我的应用崩溃后,logcat返回: java.lang.Class 在 android.app.活动线程.handle上没有零参数构造函数创建服务(活动线程.java:3201) 在 android.app.活动线程.-wrap5(活动线程.java) 在 android.app.活动线程$H.handleMessage(活动线程.java:1586) 在 a

-

我手动将我的应用程序从dagger2迁移到了刀柄。我没有遇到任何编译或构建错误。但当我尝试运行我的应用程序时,它会在启动屏幕上崩溃: 它说它不能创建那个viewmodel的实例,因为它没有零参数构造函数,但是:1-我的viewmodel类是用hilt注入的(BaseViewModel是抽象的): 2-我的活动用Android Entry Point注释(Base活动是抽象的): 3-视图模型所依赖

-

我正在使用这段代码生成objects,但有时我会遇到这个错误(错误参数#-1到'addBody'(需要代理,得到零))知道为什么吗?

-

我试图在谷歌地图中显示一个位置地址,但当我为获取地址启动意向服务时,它将显示错误“无法实例化服务”。 我使用此链接显示位置地址。 这是我的代码: 在这里我开始意图服务: