Facebook 开源了 FBGEMM,一个针对服务器推理优化的高性能核心库。 与其他库不同,FBGEMM 最大程度优化了 CPU 性能,通过降低精度计算来加速深度学习模型。 目前 Facebook 已经在自己的服务中使用该库,与目前的生产基准相比,它带来了两倍的性能提升。

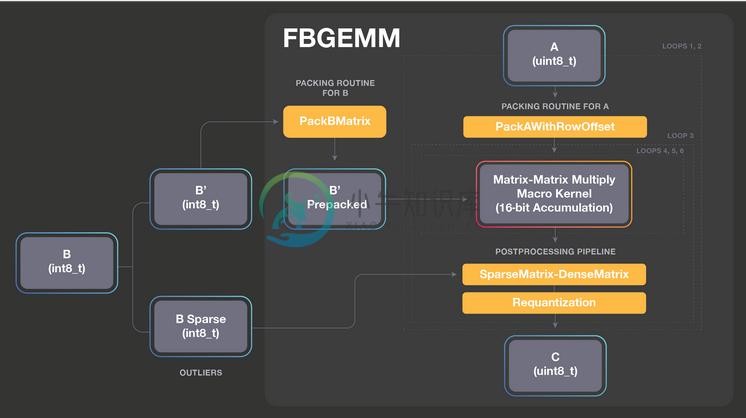

FBGEMM 的最大特点是优化低精度数据。 与科学计算中使用的传统线性代数库不同,FBGEMM 不使用 FP32 或 FP64 精度,可以为小批量提供有效的低精度通用矩阵乘法(GEMM)运算,并支持精确损失最小化技术,例如行式(Row-wise)量化和异常值感知量化。

FBGEMM 已在 Facebook 上大规模部署,加速了许多端到端人工智能服务,包括将英语翻译成西班牙语的速度提高 1.3 倍,减少了 40% 的推荐系统信息源动态内存带宽的使用 ,并将机器学习系统 Rosetta 的字符检测速度提升2.4倍(Rosetta 是 Facebook 用来理解文本,图像和视频内容的系统。)

-

7.5.1. 系统因素和启动参数的调节 7.5.2. 调节服务器参数 7.5.3. 控制查询优化器的性能 7.5.4. 编译和链接怎样影响MySQL的速度 7.5.5. MySQL如何使用内存 7.5.6. MySQL如何使用DNS 7.5.1. 系统因素和启动参数的调节 我们从系统级因素开始,因为必须尽早地进行部分决策以获得较大性能。在其它情况下,快速浏览该节就足够了。但是,了解一下更改该层次的

-

服务器端提供了比较多的关于推送的 API,包括广播,多播和单播方式的推送,还有超时,心跳,推送事件等设置。 Timeout 字段 该字段用于设置推送空闲超时。默认值为 120 秒,即 2 分钟。 当服务器发布了推送主题后(后面会专门介绍推送),客户端会跟服务器端保持一个长连接,如果达到超时时间,仍然没有任何消息推送给客户端,则返回 nil,此时,如果客户端仍然在线的话,则会立即再次发送获取推送主题

-

问题内容: 有没有比Cometd作为Java的长轮询框架更简单的方法?因为我需要的是客户端指定一些参数并将其发送到服务器。服务器处理它们并开始不停地将消息推回客户端(看起来像“每项服务线程”?)。客户端接收消息并显示它们。客户端可以停止监听,并实际上停止服务器的服务以发送消息。也许我太懒了,但是Cometd的名堂没有我想要的那么短而透明。 不基于HTML5。 问题答案: 使用SSE(服务器发送的事

-

我正在使用艺术工厂来托管大量的Python模块。有几次,https://pypi.python.org/pypi上的一个新的python模块将以相同的名称上传。当有人试图使用pip安装我的一个模块时,这会导致问题。默认情况下,pip首先查找公共包。 以下是我尝试过的: 1.我试过修改我的密码。pypirc文件, 有两个索引服务器的适当条目,但我相当肯定pip忽略了这些信息。 2.我尝试手动指定使用

-

客户端关于推送的方法只有两个,它们分别是: Subscribe 方法 Subscribe(name string, id string, settings *InvokeSettings, callback interface{}) (err error) Subscribe 方法的用处是订阅服务器端的推送服务。该方法有两种方式,一种是自动获取设置客户端 id,另一种是手动设置客户端 id。 参数

-

我正在开发一个基于云的后端HTTP服务,该服务将公开用于与一些on-prem系统的集成。客户机系统是由外部供应商定制的,它们是带有自己数据库的后端系统。这些系统部署在我们客户的公司中,我们无法访问它们,也无法控制它们。我们向供应商提供我们的API规范,他们实现客户机代码。 我的服务与客户交换的数据格式基于XML,并遵循一定的标准。供应商用不同的编程语言实现他们的客户机系统,随着时间的推移,新的供应