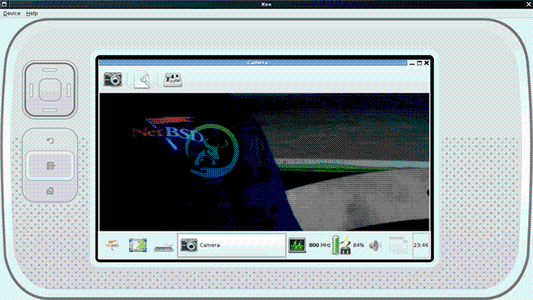

DeforaOS Camera 是个简单的网络摄像头,也是个相机捕捉应用程序。这也就意味着它可以像相机应用一样嵌入在手机设备中,作为一个视频捕捉设备,同时也可以在桌面环境使用。

-

一、简介 CameraDevice 是一个连接的相机设备代表,你可以把它看作为相机设备在 java 代码中的表现。类比于旧 API 中的 Camera 类。 官方文档链接:https://developer.android.google.cn/reference/android/hardware/camera2/CameraDevice 二、获取 CameraDevice 实例 通过 Camera

-

概述 Camera 可能是接下来个人想深入学习的课题,准备新起一个系列,从个人的角度总结阐述自己对于 Android Camera 的研究过程,希望也能够对其他想学习 Camera 的同学一些帮助。 本小节内容为 Android Camera 官方文档 的精要翻译,原文请参考: Android Camera: Camera API 正文 Android Framework 包括对设备上可用的摄像头

-

我们经常使用SurfaceView显示Camera预览画面,但画面基本都不清晰。主要是因为没有自动对焦,而自动对焦触发是通过mCamera.autoFocus(autoFocusCallback);这个函数,但是只会起一次作用,后面画面清晰度有一直这样,但是随着拍摄目标的距离变化,这个画面不在清晰,需要再次对焦。所以我这里主要通过循环自动对焦来完成。 SurfaceView如何显示Camera预览

-

Platform: RK3399 OS: Android 7.1 Kernel: v4.4.83 RK3288平台修改请参考 [RK3288][Android6.0] 调试笔记 — Camera动态热插拔支持 改动如下: CameraHal部分: /* */ diff --git a/CameraHal/CameraHal_Module.cpp b/CameraHal/CameraHal_Mo

-

我正在开发一个web应用程序,它可以浏览和拍摄本地照片,我还想通过相机拍摄图像。我使用下面的代码,我可以捕捉设备摄像头。 现在,我想获得图像和onchangeevent,转换为base64,并希望在该页面中显示。 好心帮我伙计们!

-

问题内容: 如何连续从摄像头捕获图像? 我想尝试对象识别(也许使用Java Media Framework)。 我当时正在考虑创建两个线程 一个线程: 节点1:捕获实时图像 节点2:将图片另存为“ 1.jpg” 节点3:等待5秒 节点4:重复… 其他线程: 节点1:等到捕获图像 节点2:使用“ 1.jpg”获取每个像素的颜色 节点3:将数据保存在数组中 节点4:重复… 问题答案: 此JavaCV实

-

问题内容: 我一直在尝试使用Python创建一个简单的程序,该程序使用OpenCV从我的网络摄像头获取视频供稿并将其显示在屏幕上。 我知道我之所以在这里,是因为创建了窗口,并且网络摄像头上的灯闪烁了,但是它似乎在窗口中什么都没有显示。希望有人可以解释我在做什么错。 在不相关的注释上,我注意到我的网络摄像头有时会在中更改其索引号,有时我需要输入0、1或2,即使我只连接了一个摄像头,也没有拔下插头(我

-

问题内容: 以前,我已经将可运行的网络摄像头代码放入我的应用程序中,但是现在当我更新到AngularJS v1.5.0时,它无法正常工作。我正在使用与v1.3.0完美配合的网络摄像头指令。 这是我的代码: 但是现在,AngularJS v1.5.0给出了以下错误: 我还尝试对AngularJS ng-Camera使用其他解决方案,但即使是演示页也不适用于我。 注意: 我知道问题在于我们无法从Ang

-

本文向大家介绍FFmpeg获取网络摄像头数据解码,包括了FFmpeg获取网络摄像头数据解码的使用技巧和注意事项,需要的朋友参考一下 对USB摄像头实时编码,在前面已经探讨过了。这次改变下思路,尝试去截取网络摄像头的H264码流,将其解码播放。 这里的测试代码,是在海康摄像头的基础上进行的。 解码的大致流程和以前的保持一致,只不过增加了部分函数。 FFmpeg打开媒体文件并查看媒体文件的信息,有三个

-

我知道这可能是一个相对通用的问题,但我正试图看看如何才能被指向正确的方向... 我试图用AWS Rekognition建立一个实时人脸识别应用程序。我对API很满意,并使用上传到S3的静态图像来执行面部识别。然而,我正试图找到一种将实时数据流到Rekognition的方法。在阅读了Amazon提供的各种文章和文档后,我发现了这个过程,但似乎无法克服一个障碍。 根据文档,我可以用Kinesis来完成

-

我目前正在做一个项目,从网络摄像头捕捉视频,并通过UDP发送编码流来做实时流。 有人说从cap.read得到的帧已经是解码帧,我不知道这是如何以及何时发生的。我想要的是编码的帧或流。我应该怎么做才能得到它?我应该再编码一次吗?

-

我正在尝试使用gstreamer 1.0将网络摄像头视频从树莓流到VLC播放器。现在,我对覆盆子有以下命令: 以及以下sdp文件,以使用vlc播放流: 当我运行gst-Launst-1.0命令时,我可以通过wireshark看到它正在发送udp数据包,但当我尝试使用vlc和sdp文件播放流时,我什么也没有得到。vlc日志说: 我不知道怎么了。我可能没有正确地构建管道,这就是为什么vlc不能将该流识