将网络摄像头数据放入kinesis视频流

我对Api非常陌生,我们的用例是将实时数据从网络摄像头流到kinesis视频流。步骤:在aws上创建ubuntu服务器并安装CPP SDK。在aws中创建了kinesis视频流,下载并在本地安装了Gstreamer。

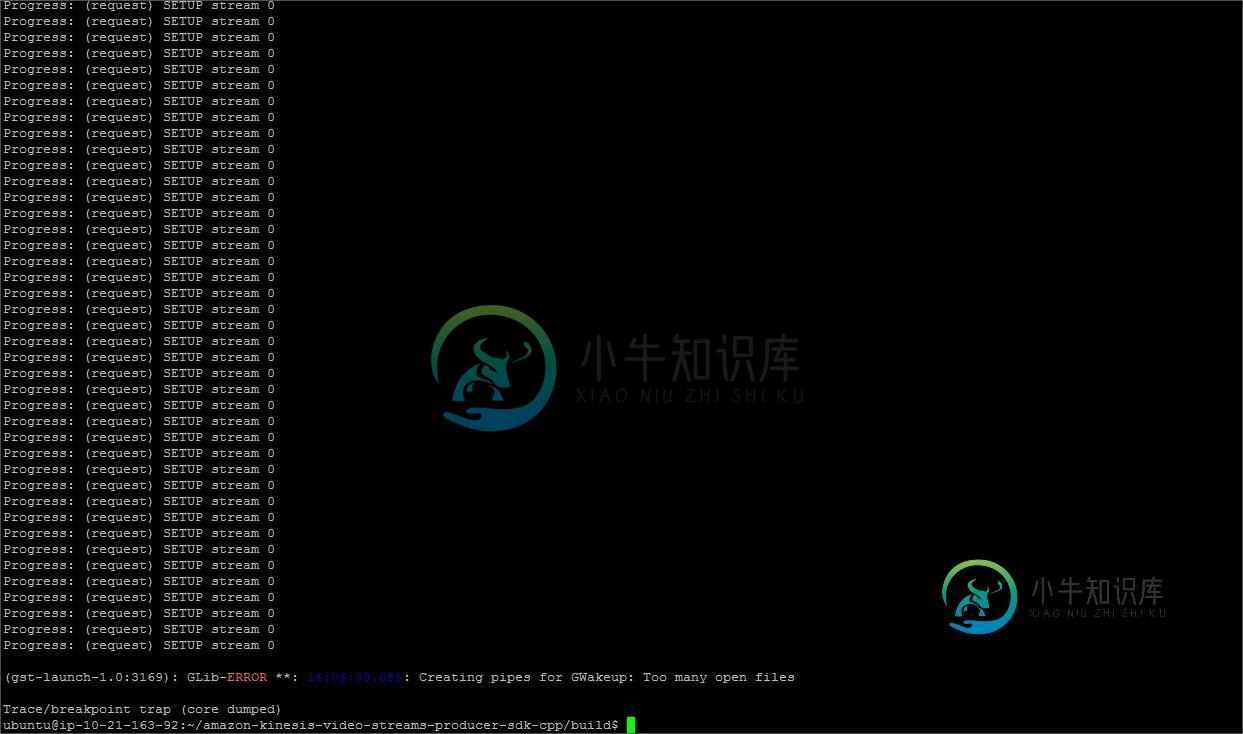

我试图将rtsp示例数据放到Ec2ubuntu服务器上的gstream中,我运行的查询$gst-launch-1.0rtspsrc location=“rtsp://yourcamerartspurl”short-header=true!rtph264depay!视频/X-H264,格式=AVC,排列=AU!kvssink stream-name=“yourstreamname”storage-size=512 access-key=“youraccesskey”secret-key=“yoursecretkey”aws-region=“yourawsregion”

谢谢

共有1个答案

如果您使用macOS,您可以将您的网络摄像头流到Kinesis视频流中,就像下面设置fps 1的命令一样;

AWS_ACCESS_KEY_ID=<YOUR_AWS_ACCESS_KEY_ID>

AWS_SECRET_ACCESS_KEY=<YOUR_AWS_SECRET_ACCESS_KEY>

AWS_REGION=<YOUR_AWS_REGION>

STREAM_NAME=<YOUR_STREAM_NAME>

gst-launch-1.0 -v avfvideosrc \

! clockoverlay font-desc="Sans bold 60px" \

! videorate \

! video/x-raw,framerate=1/1 \

! vtenc_h264_hw allow-frame-reordering=FALSE realtime=TRUE max-keyframe-interval=2 bitrate=512 \

! h264parse \

! video/x-h264,stream-format=avc,alignment=au \

! kvssink stream-name="${STREAM_NAME}" storage-size=512 \

access-key="${AWS_ACCESS_KEY_ID}" \

secret-key="${AWS_SECRET_ACCESS_KEY}" \

aws-region="${AWS_REGION}" \

frame-timecodes=true \

framerate=1

-

我知道这可能是一个相对通用的问题,但我正试图看看如何才能被指向正确的方向... 我试图用AWS Rekognition建立一个实时人脸识别应用程序。我对API很满意,并使用上传到S3的静态图像来执行面部识别。然而,我正试图找到一种将实时数据流到Rekognition的方法。在阅读了Amazon提供的各种文章和文档后,我发现了这个过程,但似乎无法克服一个障碍。 根据文档,我可以用Kinesis来完成

-

本文向大家介绍FFmpeg获取网络摄像头数据解码,包括了FFmpeg获取网络摄像头数据解码的使用技巧和注意事项,需要的朋友参考一下 对USB摄像头实时编码,在前面已经探讨过了。这次改变下思路,尝试去截取网络摄像头的H264码流,将其解码播放。 这里的测试代码,是在海康摄像头的基础上进行的。 解码的大致流程和以前的保持一致,只不过增加了部分函数。 FFmpeg打开媒体文件并查看媒体文件的信息,有三个

-

如题所示,纯前端可以播放回放吗

-

我的jfreeChart来自网络摄像头的帧。我通过这个框架,它生成一个图形的R,G和B颜色的这个框架。我想这个图表做自动更新,因为我通过帧。我什么都试过了,但都没用。 }

-

我正在开发一个web应用程序,它可以浏览和拍摄本地照片,我还想通过相机拍摄图像。我使用下面的代码,我可以捕捉设备摄像头。 现在,我想获得图像和onchangeevent,转换为base64,并希望在该页面中显示。 好心帮我伙计们!

-

官方的游戏示例 webcam-transfer-learning,建议玩一玩,是基于 MobileNet 的一个迁移学习的例子。 Transfer learning - Train a neural network to predict from webcam data Before we begin, we highly recommend playing with the demo. Try