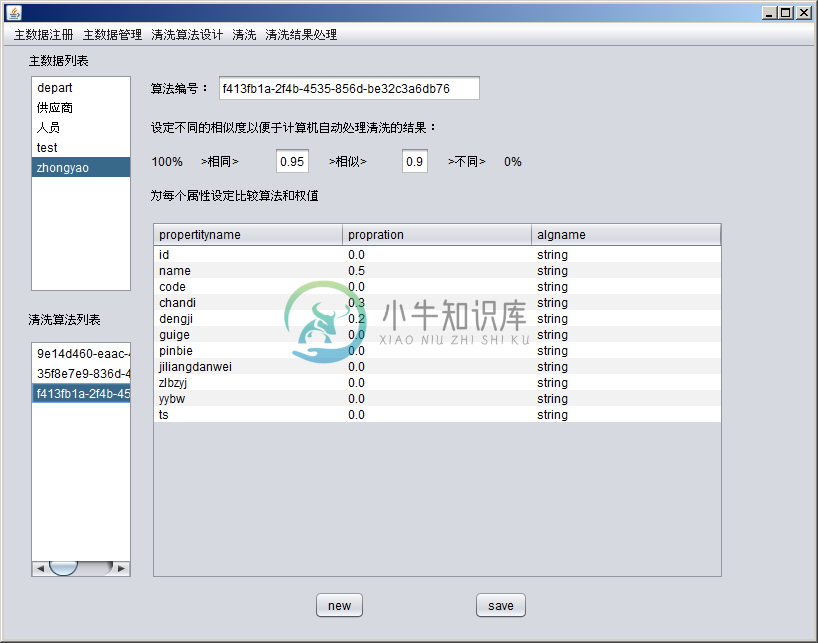

一个好用的数据查重引擎。包含了数据建模,清洗算法设计,查重,结构导出等功能。查重的算法中对数据每个属性均可以设定权重和灵活选择比对算法。使用的中文分词引擎对较长中文句子进行分司和比对。

-

select count(*) from test_no_1 where test_not in (select test_not from test_no_1 group by test_not having count(*)>1); test_no_1 是table_name test_not是列名

-

至少在现阶段内存和CPU的执行效率在固定时间内是有限的,大量的数据的查重和去重处理不可能同时在内存中进行。就像外部排序算法和内部排序算法差别很大,遇到此类大量数据查重问题对算法进行设计是有必要的。 ConcurrentHashMap 数据量不大的时候可以采用concurrentHashMap来操作,在内存中对数据进行同步的CRUD操作。 这种做法的好处是很明显的,逻辑处理很简单易懂。但是会产生

-

#查重: Select * From 表名 Where 字段名称 In (Select 字段名称 From 表名 Group By 字段名称 Having Count(*)>1) #删除重复数据只留其中一条 DELETE FROM 表名 where id not in (select id from (select min(id) as id from 表名 group by 字段名称)

-

sim使用方法:https://blog.mythsman.com/post/5d2b46e325601931a5f8d788/amp/

-

大数据去重复/查重 经常会有大量的数据比如100G,要在内存为4G的处理器上进行查重和去重操作。 ConcurrentHashMap 数据量不大的时候可以采用concurrentHashMap来操作。 布隆过滤器 布隆过滤器是一种采用hash法进行查重的工具,它不是简单的做hash操作,而是将数据进行n次hash处理得到n个整数,将一个很长的数组的这n位从0设置为1。下次查找的时候经过同样的计算,

-

更新数据 import json import scrapy import time import pymongo from lxml import etree from spider.items import AnswerItem from spider.settings import MONGODB_PORT from spider.settings import MONGODB_HOST

-

数据抓取的命令行工具 curl curl是一个利用URL语法在命令行下进行网络通信的工具,类似于一个命令行版本的浏览器,但不会对页面进行渲染.其用法很简单,直接在命令行中输入curl [URL地址] [参数]即可,如: curl https://www.baidu.com 其常用参数如下: 参数 意义 示例 -X或--request 指定请求的HTTP类型(默认为GET) curl -X POS

-

每日分享: 如果你累了,学会休息,而不是放弃 目标:提取贴吧中每个帖子的标题和链接(内有自动翻页) 以下是爬取数据的源码: import requests from lxml import etree class TieBa(object): def __init__(self, name): self.url = 'https://tieba.baidu.com/f

-

博主的话: 推荐给域名投资者的这一款工具经过博主长期使用,其功能非常牛逼,我已将机器里其他类似软件全部DEL, 域霸扫描器是一款高速扫描(正常网速,平均每小时五万条)域名是否被注册,以及WHOIS信息,注册商信息,注册日期与过期日期。 指定位数排列组合生成英文字母、数字(a-z 0-9),也可利用现有词典导入生成指定后缀域名。在生成域名时可指定前后加入指定字符串。 目前支持的域名后缀有:com,

-

查重工具有paperYY、paperok、paperpass、格子达等。 这部分工具基本上都有免费一次的机会。

-

抓取网站为:https://luoyang.anjuke.com/sale/m530/?pi=baidu-cpc-luoyang-tyong1&kwid=90923896685中的数据 前台:<asp:Button ID="Button1" runat="server" Text="爬虫" OnClick="Button1_Click" /> 后台: public static string Ge

-

# -*- coding: utf-8 -*- import requests import time from bs4 import BeautifulSoup import io import sys #sys.stdout = io.TextIOWrapper(sys.stdout.buffer,encoding='gbk') #改变标准输出的默认编码 #生活大爆炸吧 ''' # 标题&

-

针对某关键词爬取相关数据 目标数据:2020.3.20微博用户发布的包含关键词“疫情”的微博文本数据。 针对上述目标数据,涉及到微博的https://weibo.com和https://weibo.cn站点,其中weibo.com的时间粒度是一个小时,weibo.cn的时间粒度是一天,为了抓取到尽可能多的关键词搜索结果,需要使用weibo.com的高级搜索功能来实现按照关键字和时间进行爬取。考虑到

-

Git 中的一些命令是以引入的变更即提交这样的概念为中心的,这样一系列的提交,就是一系列的补丁。 这些命令以这样的方式来管理你的分支。 git cherry-pick git cherry-pick 命令用来获得在单个提交中引入的变更,然后尝试将作为一个新的提交引入到你当前分支上。 从一个分支单独一个或者两个提交而不是合并整个分支的所有变更是非常有用的。 在 变基与拣选工作流 一节中描述和演示了

-

前言:我是一个高级Vaadin开发人员(我已经使用了6,7,现在我所有的项目都迁移到了Vaadin 8)。 我开始研究瓦丁10/Flow,但我发现自己陷入了困境。 我真正纠结的是“项目”本身。我越深入,就越觉得这个框架正在进入一个基于css/html的框架,这需要比java更多的css/html知识。我的意思是,如果你不完全知道css和html是如何工作的,你就不能再轻松地使用这个框架了。 问题是

-

有谁能向我解释一下Vaadin的服务器端Java组件是如何工作的吗?它们似乎在服务器端状态和称为“widgetset”的客户端javascript引擎之间进行同步。 有没有人对Vaadin的内部结构有更详细的解释?我一直试图向我的同事们解释这件事,却不知该说些什么。

-

013. Roman to Integer 问题 Given a roman numeral, convert it to an integer. Input is guaranteed to be within the range from 1 to 3999. Subscribe to see which companies asked this question 思路 首先要知道罗马数字的规

-

012. Integer to Roman[M] 问题 Given an integer, convert it to a roman numeral. Input is guaranteed to be within the range from 1 to 3999. 思路 分析罗马数字的规律: Symbol Value I 1 V 5 X 10 L 50 C 100 D 500 M 1,000

-

向app store发布新的app版本可能需要一些时间。Tabris.js允许直接向你的用户发布热更新,而无需等待app store更新。 为了符合Apple App Store的规则,修补程序必须“[…] not change the primary purpose of the app by providing features or functionality that are incons